Points de contrôle

Enable the Data Catalog API

/ 10

Create the PostgreSQL Database

/ 15

Create a Service Account for postgresql

/ 15

Execute PostgreSQL to Data Catalog connector

/ 15

Create the MySQL Database

/ 15

Create a Service Account for MySQL

/ 15

Execute MySQL to Data Catalog connector

/ 15

Créer et exécuter des connecteurs MySQL, PostgreSQL et SQL Server vers Data Catalog

GSP814

Présentation

Data Catalog est un service de gestion des métadonnées entièrement géré et évolutif qui permet aux organisations de découvrir, d'interpréter et de gérer rapidement toutes leurs données.

Il offre une interface de recherche simple d'utilisation pour la découverte de données, un système de catalogage flexible et performant pour la capture de métadonnées techniques et métier, ainsi qu'une base solide en termes de sécurité et de conformité avec les intégrations à Cloud Data Loss Prevention (DLP) et Cloud Identity and Access Management (IAM).

Utiliser Data Catalog

Vous pouvez interagir avec Data Catalog de deux manières :

-

En recherchant des éléments de données auxquels vous avez accès

-

En ajoutant des tags de métadonnées à des éléments

Objectifs de l'atelier

Dans cet atelier, vous allez apprendre à effectuer les tâches suivantes :

-

Activer l'API Data Catalog de manière à pouvoir utiliser ce service dans votre projet Google Cloud

-

Exécuter un connecteur SQL Server vers Data Catalog

-

Exécuter un connecteur PostgreSQL vers Data Catalog

-

Exécuter un connecteur MySQL vers Data Catalog

Prérequis

Très important: Avant de commencer cet atelier, déconnectez-vous de votre compte Gmail personnel ou d'entreprise, ou exécutez cet atelier en navigation privée. Cela évite toute confusion lors de la connexion pendant l'exécution de l'atelier.

Configuration et exigences

Avant de cliquer sur le bouton "Démarrer l'atelier"

Lisez ces instructions. Les ateliers sont minutés, et vous ne pouvez pas les mettre en pause. Le minuteur, qui démarre lorsque vous cliquez sur Démarrer l'atelier, indique combien de temps les ressources Google Cloud resteront accessibles.

Cet atelier pratique vous permet de suivre vous-même les activités dans un véritable environnement cloud, et non dans un environnement de simulation ou de démonstration. Nous vous fournissons des identifiants temporaires pour vous connecter à Google Cloud le temps de l'atelier.

Pour réaliser cet atelier :

- vous devez avoir accès à un navigateur Internet standard (nous vous recommandons d'utiliser Chrome) ;

- vous disposez d'un temps limité ; une fois l'atelier commencé, vous ne pouvez pas le mettre en pause.

Démarrer l'atelier et se connecter à la console Google Cloud

-

Cliquez sur le bouton Démarrer l'atelier. Si l'atelier est payant, un pop-up s'affiche pour vous permettre de sélectionner un mode de paiement. Sur la gauche, vous trouverez le panneau Détails concernant l'atelier, qui contient les éléments suivants :

- Le bouton Ouvrir la console Google Cloud

- Le temps restant

- Les identifiants temporaires que vous devez utiliser pour cet atelier

- Des informations complémentaires vous permettant d'effectuer l'atelier

-

Cliquez sur Ouvrir la console Google Cloud (ou effectuez un clic droit et sélectionnez Ouvrir le lien dans la fenêtre de navigation privée si vous utilisez le navigateur Chrome).

L'atelier lance les ressources, puis ouvre la page Se connecter dans un nouvel onglet.

Conseil : Réorganisez les onglets dans des fenêtres distinctes, placées côte à côte.

Remarque : Si la boîte de dialogue Sélectionner un compte s'affiche, cliquez sur Utiliser un autre compte. -

Si nécessaire, copiez le nom d'utilisateur ci-dessous et collez-le dans la boîte de dialogue Se connecter.

{{{user_0.username | "Username"}}} Vous trouverez également le nom d'utilisateur dans le panneau Détails concernant l'atelier.

-

Cliquez sur Suivant.

-

Copiez le mot de passe ci-dessous et collez-le dans la boîte de dialogue Bienvenue.

{{{user_0.password | "Password"}}} Vous trouverez également le mot de passe dans le panneau Détails concernant l'atelier.

-

Cliquez sur Suivant.

Important : Vous devez utiliser les identifiants fournis pour l'atelier. Ne saisissez pas ceux de votre compte Google Cloud. Remarque : Si vous utilisez votre propre compte Google Cloud pour cet atelier, des frais supplémentaires peuvent vous être facturés. -

Accédez aux pages suivantes :

- Acceptez les conditions d'utilisation.

- N'ajoutez pas d'options de récupération ni d'authentification à deux facteurs (ce compte est temporaire).

- Ne vous inscrivez pas à des essais gratuits.

Après quelques instants, la console Cloud s'ouvre dans cet onglet.

Activer Cloud Shell

Cloud Shell est une machine virtuelle qui contient de nombreux outils pour les développeurs. Elle comprend un répertoire d'accueil persistant de 5 Go et s'exécute sur Google Cloud. Cloud Shell vous permet d'accéder via une ligne de commande à vos ressources Google Cloud.

- Cliquez sur Activer Cloud Shell

en haut de la console Google Cloud.

Une fois connecté, vous êtes en principe authentifié et le projet est défini sur votre ID_PROJET. Le résultat contient une ligne qui déclare YOUR_PROJECT_ID (VOTRE_ID_PROJET) pour cette session :

gcloud est l'outil de ligne de commande pour Google Cloud. Il est préinstallé sur Cloud Shell et permet la complétion par tabulation.

- (Facultatif) Vous pouvez lister les noms des comptes actifs à l'aide de cette commande :

-

Cliquez sur Autoriser.

-

Vous devez à présent obtenir le résultat suivant :

Résultat :

- (Facultatif) Vous pouvez lister les ID de projet à l'aide de cette commande :

Résultat :

Exemple de résultat :

gcloud, dans Google Cloud, accédez au guide de présentation de la gcloud CLI.

Activer l'API Data Catalog

Ouvrez le menu de navigation et sélectionnez API et services> Bibliothèque

Dans la barre de recherche, saisissez "Data Catalog" et sélectionnez Google Cloud Data Catalog API.

Cliquez ensuite sur Enable (Activer).

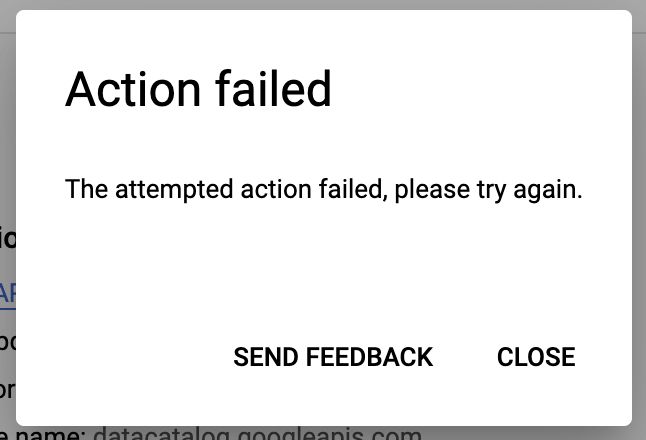

Si vous rencontrez l'erreur suivante lorsque vous essayez d'activer l'API Data Catalog :

- Cliquez sur Fermer.

- Actualisez l'onglet de votre navigateur.

- Cliquez de nouveau sur Activer.

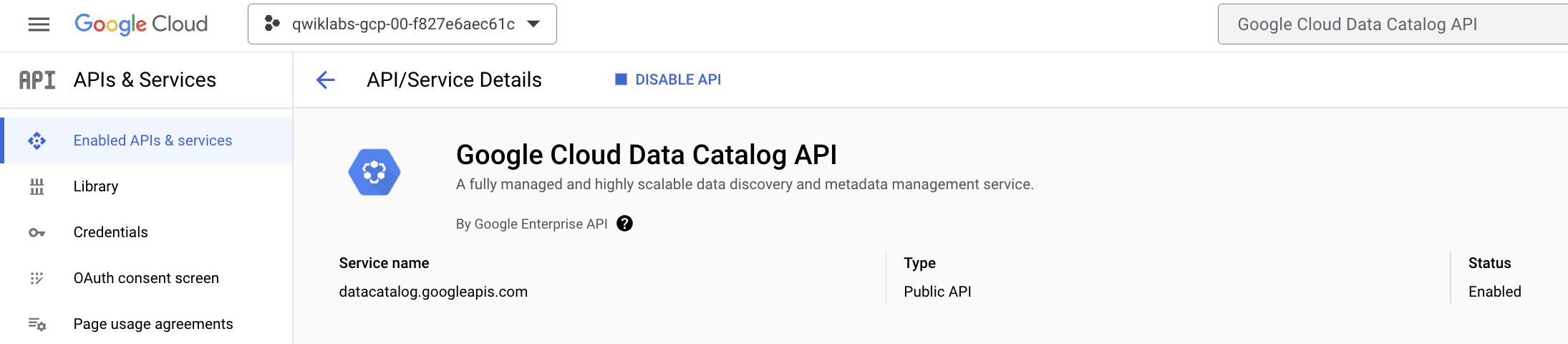

L'API Data Catalog doit alors être correctement activée :

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

SQL Server vers Data Catalog

Commençons par configurer l'environnement. Ouvrez une nouvelle session Cloud Shell et exécutez la commande suivante pour définir votre ID de projet, en remplaçant <YOUR_PROJECT_ID> par l'ID de votre projet Google Cloud dans Qwiklabs, qui est indiqué dans le panneau "Connection Details" (Détails de connexion) :

gcloud config set project <YOUR_PROJECT_ID>

Définissez ensuite votre ID de projet en tant que variable d'environnement :

export PROJECT_ID=$(gcloud config get-value project)

Créer la base de données SQL Server

Dans votre session Cloud Shell, exécutez la commande suivante pour télécharger les scripts afin de créer et de remplir votre instance SQLServer:

gsutil cp gs://spls/gsp814/cloudsql-sqlserver-tooling.zip .

unzip cloudsql-sqlserver-tooling.zip

Remplacez maintenant votre répertoire de travail actuel par le répertoire téléchargé :

cd cloudsql-sqlserver-tooling

Exécutez maintenant le script init-db.sh :

bash init-db.sh

Votre instance SQL Server est créée et renseignée selon un schéma aléatoire.

Error: Failed to load "tfplan" as a plan file, réexécutez le script init-db.Cela prendra environ 5 à 10 minutes. Vous pouvez passer à autre chose lorsque vous recevez le résultat suivant :

CREATE TABLE factory_warehouse15797.employees53b82dc5 ( school80581 REAL, reason91250 DATETIME, randomdata32431 BINARY, phone_number52754 REAL, person66471 REAL, credit_card75527 DATETIME )

COMPLETED

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Configurer le compte de service

Exécutez la commande suivante pour créer un compte de service :

gcloud iam service-accounts create sqlserver2dc-credentials \

--display-name "Service Account for SQLServer to Data Catalog connector" \

--project $PROJECT_ID

Créez et téléchargez la clé du compte de service.

gcloud iam service-accounts keys create "sqlserver2dc-credentials.json" \

--iam-account "sqlserver2dc-credentials@$PROJECT_ID.iam.gserviceaccount.com"

Accordez le rôle d'administrateur Data Catalog au compte de service :

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member "serviceAccount:sqlserver2dc-credentials@$PROJECT_ID.iam.gserviceaccount.com" \

--quiet \

--project $PROJECT_ID \

--role "roles/datacatalog.admin"

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Exécuter un connecteur SQL Server vers Data Catalog

Vous pouvez créer le connecteur SQL Server manuellement à partir de ce dépôt GitHub.

Pour faciliter son utilisation, nous allons utiliser une image docker.

Les variables nécessaires ont été générées par la configuration Terraform.

Remplacez les répertoires par l'emplacement des scripts Terraform :

cd infrastructure/terraform/

Saisissez les variables d'environnement :

public_ip_address=$(terraform output -raw public_ip_address)

username=$(terraform output -raw username)

password=$(terraform output -raw password)

database=$(terraform output -raw db_name)

Revenez au répertoire racine pour l'exemple de code :

cd ~/cloudsql-sqlserver-toolingUtilisez la commande suivante pour exécuter le connecteur :

docker run --rm --tty -v \

"$PWD":/data mesmacosta/sqlserver2datacatalog:stable \

--datacatalog-project-id=$PROJECT_ID \

--datacatalog-location-id=us-central1 \

--sqlserver-host=$public_ip_address \

--sqlserver-user=$username \

--sqlserver-pass=$password \

--sqlserver-database=$database

Vous devriez rapidement obtenir le résultat suivant :

============End sqlserver-to-datacatalog============

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Rechercher les entrées SQL Server dans Data Catalog

Une fois le script terminé, ouvrez le menu de navigation, puis sélectionnez Data Catalog dans la liste des services.

Dans la page Data Catalog, cliquez sur Tag Templates.

Vous devriez voir vos modèles de balises sqlserver répertoriés.

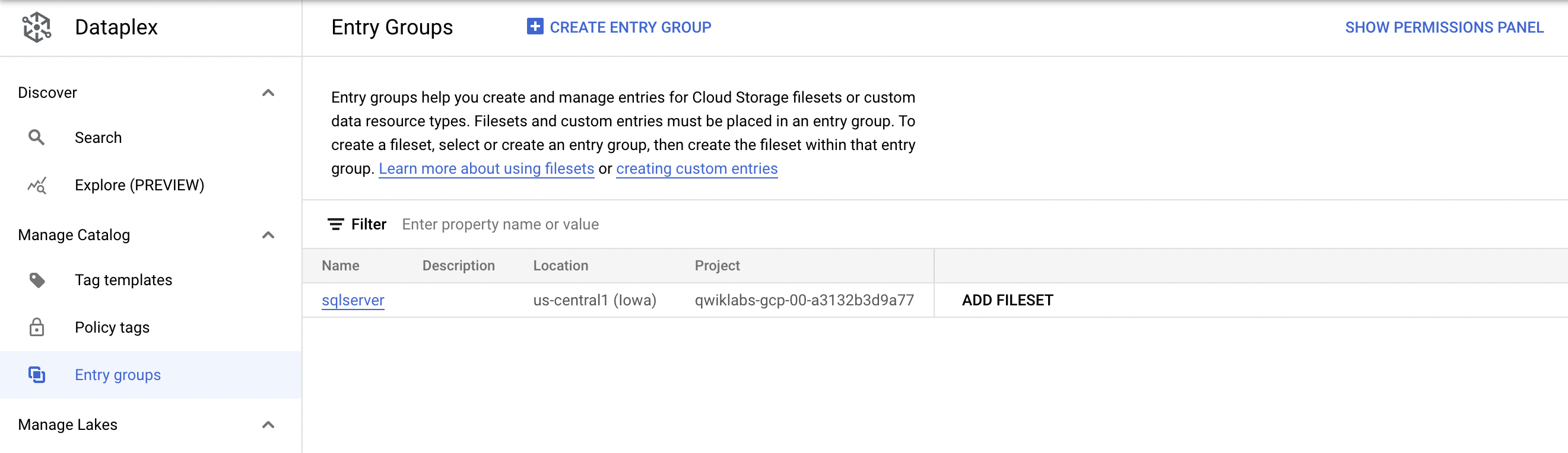

Ensuite, sélectionnez Groupes d'entrée.

Vous devriez voir le groupe d'entrées sqlserver :

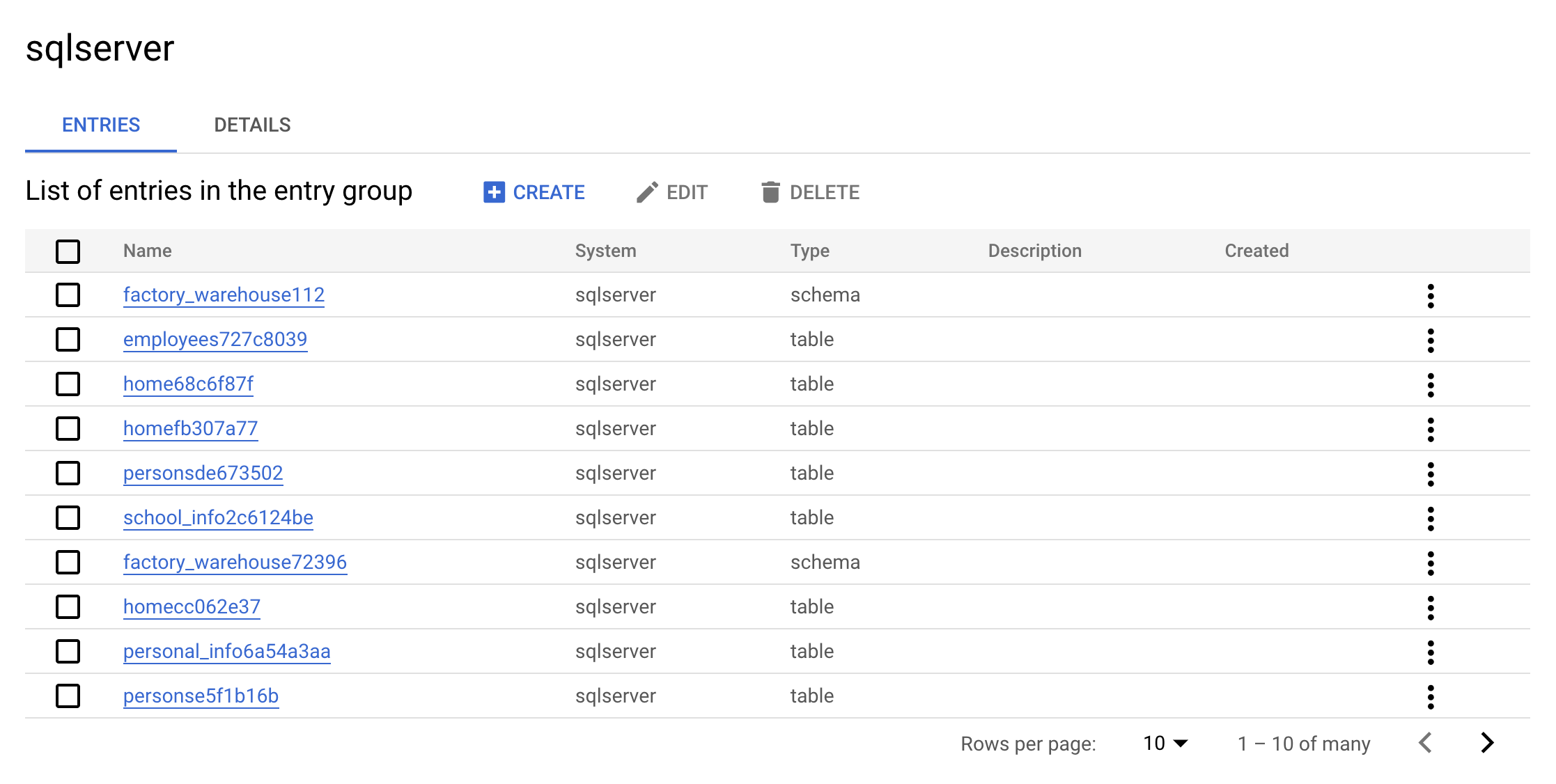

Cliquez maintenant sur le groupe d'entrée sqlserver. Votre console doit ressembler à ce qui suit:

Il s'agit de la valeur réelle d'un groupe d'entrées. L'interface utilisateur affiche toutes les entrées appartenant au groupe "sqlserver".

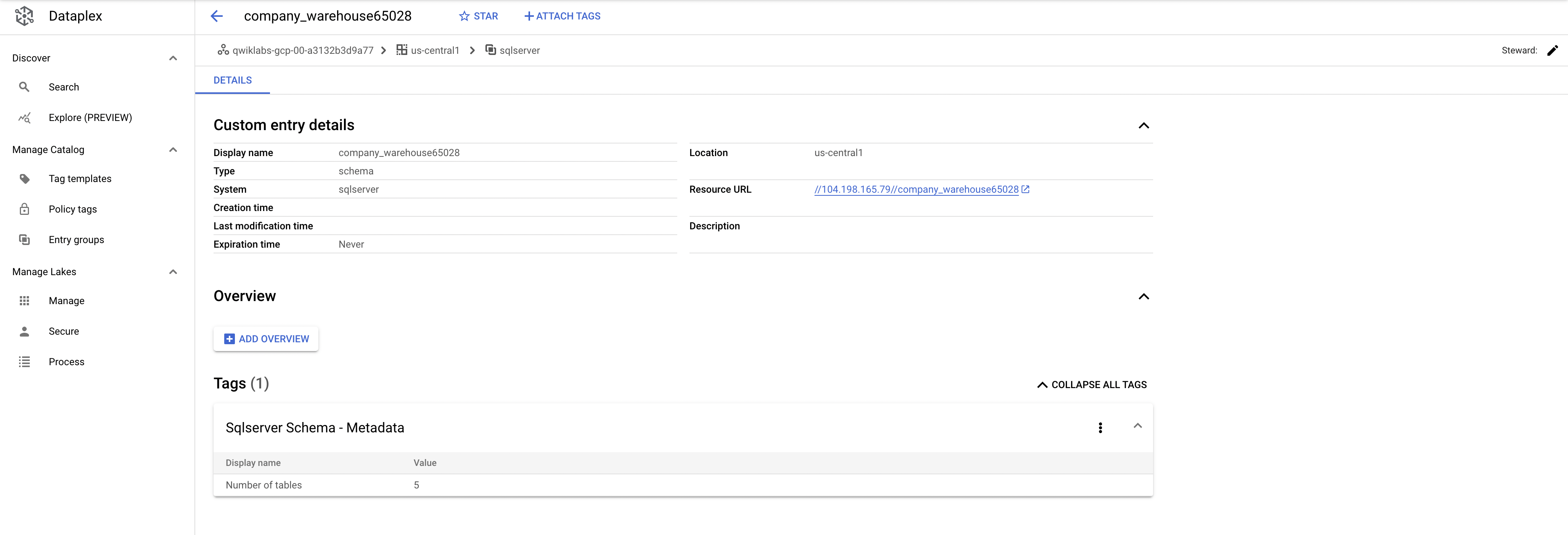

Cliquez sur l'une des entrées warehouse. Regardez les détails et les balises de l'entrée personnalisée :

Détails d'entrée personnalisés et tags :

Voilà tout l'intérêt du connecteur : il permet l'inclusion des métadonnées dans l'index de recherche de Data Catalog.

Effectuer un nettoyage

Exécutez la commande suivante pour supprimer les métadonnées SQL Server qui ont été créées :

./cleanup-db.sh

Exécutez maintenant le conteneur responsable du nettoyage :

docker run --rm --tty -v \

"$PWD":/data mesmacosta/sqlserver-datacatalog-cleaner:stable \

--datacatalog-project-ids=$PROJECT_ID \

--rdbms-type=sqlserver \

--table-container-type=schema

À présent, exécutez la commande suivante pour supprimer la base de données SQL Server :

./delete-db.sh

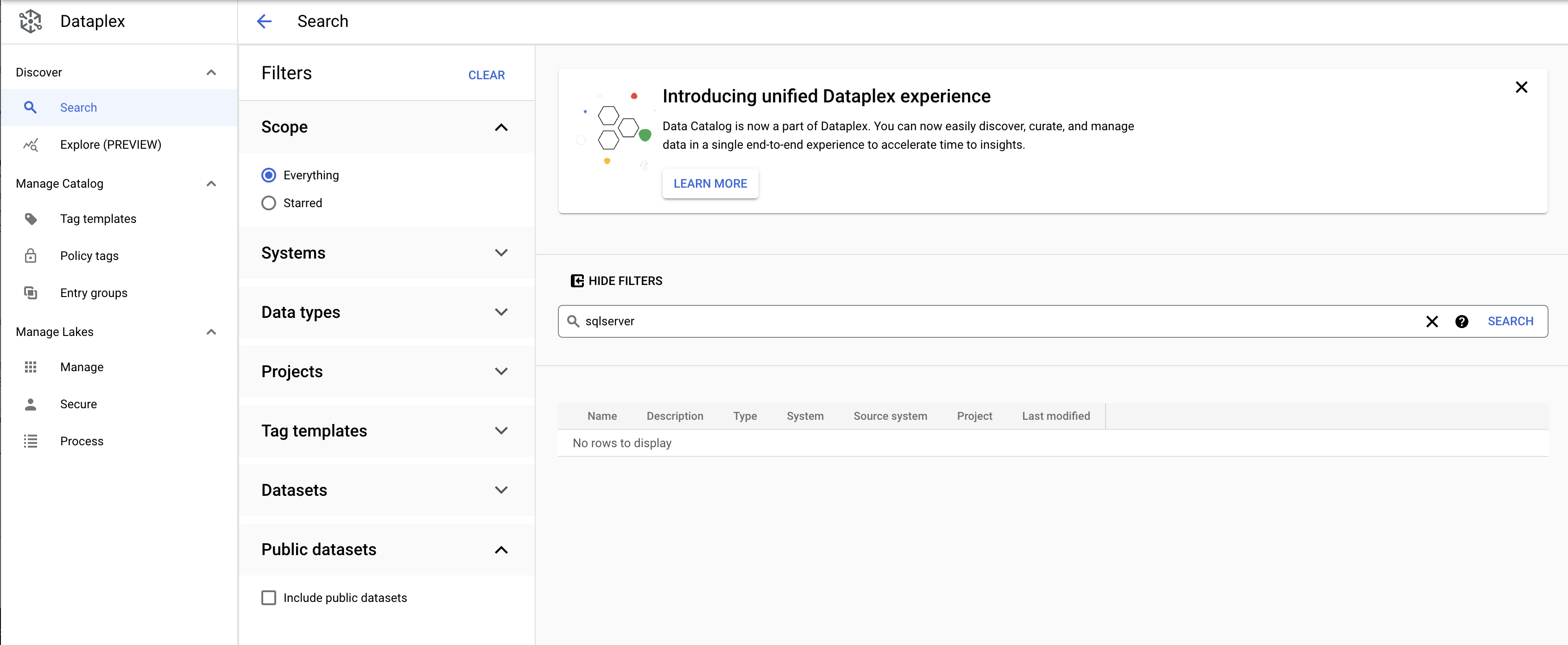

Dans le menu de navigation, sélectionnez Data Catalog. Recherchez sqlserver. Les modèles de tag SQL Server n'apparaissent plus dans les résultats :

Avant de continuer, vérifiez que vous obtenez le résultat suivant dans Cloud Shell :

Cloud SQL Instance deleted

COMPLETED

Maintenant, vous allez apprendre à réaliser la même opération avec une instance PostgreSQL.

PostgreSQL vers Data Catalog

Créer la base de données PostgreSQL

Exécutez la commande suivante dans Cloud Shell pour revenir à votre répertoire d'accueil :

cd

Exécutez la commande suivante pour cloner le dépôt GitHub :

gsutil cp gs://spls/gsp814/cloudsql-postgresql-tooling.zip .

unzip cloudsql-postgresql-tooling.zip

Passez de votre répertoire de travail actuel au répertoire du dépôt cloné :

cd cloudsql-postgresql-tooling

Exécutez maintenant le script init-db.sh :

bash init-db.sh

Cela créera votre instance PostgreSQL et la remplira avec un schéma aléatoire. Cela peut prendre environ 10 à 15 minutes.

Error: Failed to load "tfplan" as a plan file, réexécutez le script init-db.Soon after you should receive the following output:

CREATE TABLE factory_warehouse69945.home17e97c57 ( house57588 DATE, paragraph64180 SMALLINT, ip_address61569 JSONB, date_time44962 REAL, food19478 JSONB, state8925 VARCHAR(25), cpf75444 REAL, date_time96090 SMALLINT, reason7955 CHAR(5), phone_number96292 INT, size97593 DATE, date_time609 CHAR(5), location70431 DATE )

COMPLETED

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Configurer le compte de service

Créez un compte de service :

gcloud iam service-accounts create postgresql2dc-credentials \

--display-name "Service Account for PostgreSQL to Data Catalog connector" \

--project $PROJECT_ID

Ensuite, créez et téléchargez la clé du compte de service :

gcloud iam service-accounts keys create "postgresql2dc-credentials.json" \

--iam-account "postgresql2dc-credentials@$PROJECT_ID.iam.gserviceaccount.com"

Accordez le rôle d'administrateur Data Catalog au compte de service :

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member "serviceAccount:postgresql2dc-credentials@$PROJECT_ID.iam.gserviceaccount.com" \

--quiet \

--project $PROJECT_ID \

--role "roles/datacatalog.admin"

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Exécuter un connecteur PostgreSQL vers Data Catalog

Vous pouvez créer le connecteur PostgreSQL manuellement à partir de ce dépôt GitHub.

Pour faciliter son utilisation, nous allons utiliser une image docker.

Les variables nécessaires ont été générées par la configuration Terraform.

Remplacez les répertoires par l'emplacement des scripts Terraform :

cd infrastructure/terraform/

Saisissez les variables d'environnement :

public_ip_address=$(terraform output -raw public_ip_address)

username=$(terraform output -raw username)

password=$(terraform output -raw password)

database=$(terraform output -raw db_name)

Revenez au répertoire racine pour l'exemple de code :

cd ~/cloudsql-postgresql-toolingExécutez le connecteur :

docker run --rm --tty -v \

"$PWD":/data mesmacosta/postgresql2datacatalog:stable \

--datacatalog-project-id=$PROJECT_ID \

--datacatalog-location-id=us-central1 \

--postgresql-host=$public_ip_address \

--postgresql-user=$username \

--postgresql-pass=$password \

--postgresql-database=$database

Vous devriez rapidement obtenir le résultat suivant :

============End postgresql-to-datacatalog============

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Vérifier les résultats du script

Vérifiez que vous êtes bien sur la page d'accueil de Data Catalog.

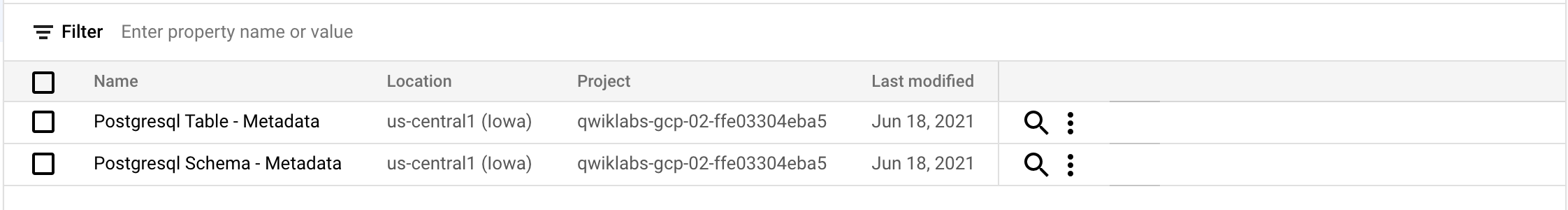

Cliquez sur Modèles de balises.

Vous devriez voir les modèles de balise postgresql suivants :

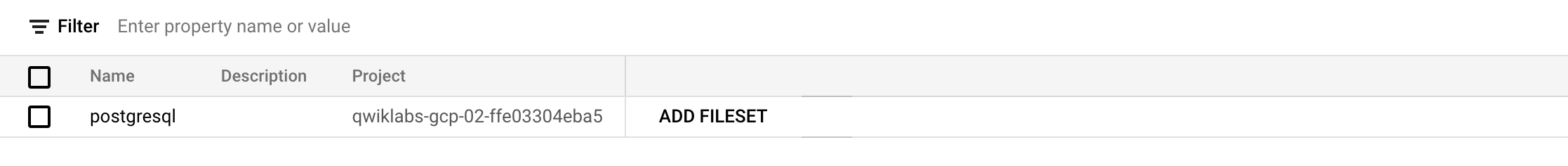

Cliquez sur Groupes d'entrée.

Vous devriez voir le groupe d'entrées postgresql suivant :

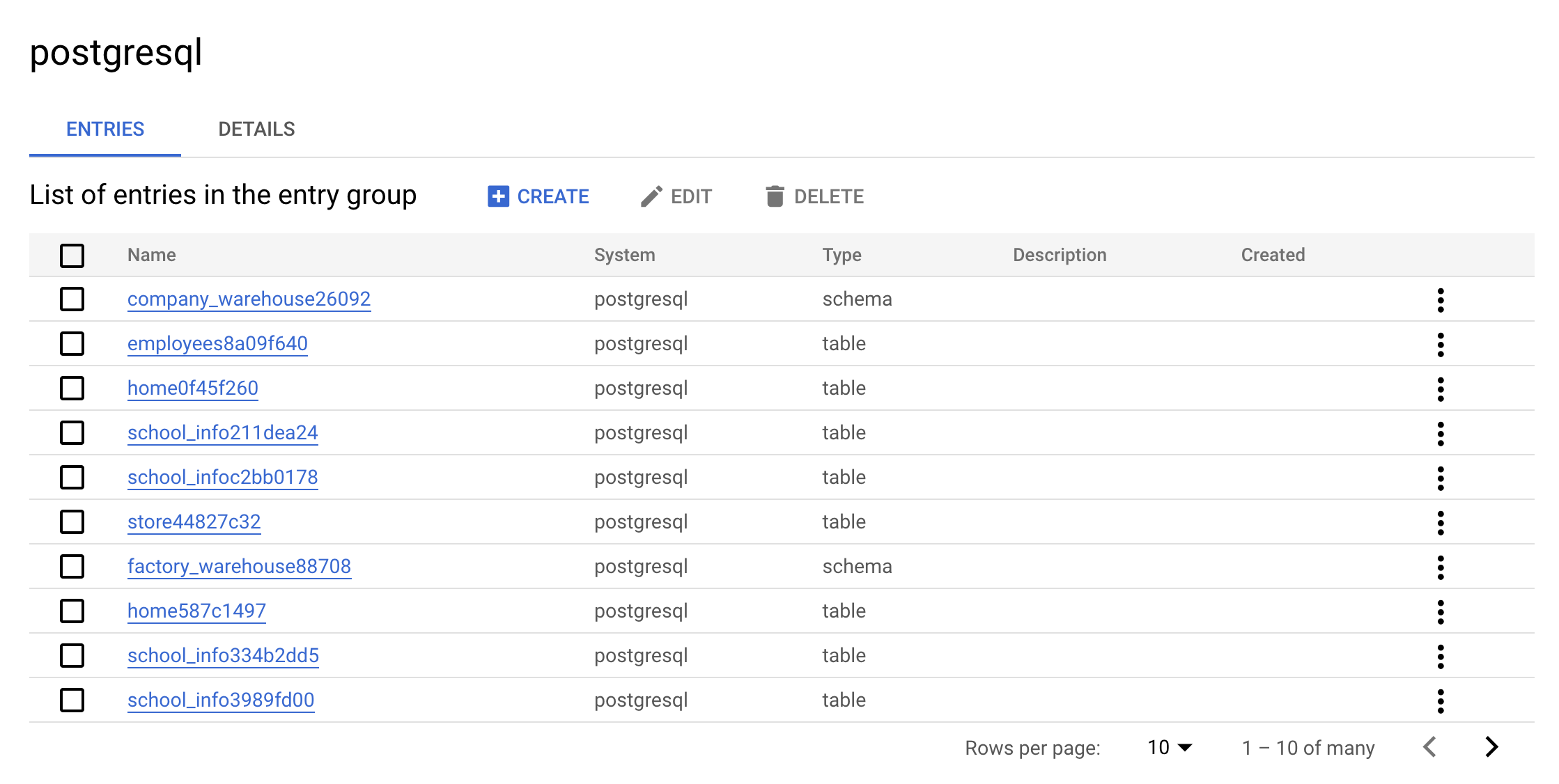

Maintenant, cliquez sur le groupe d'entrées postgresql. Votre console doit ressembler à ce qui suit:

Il s'agit de la valeur réelle d'un groupe d'entrées. L'interface utilisateur affiche toutes les entrées appartenant au groupe "postgresql".

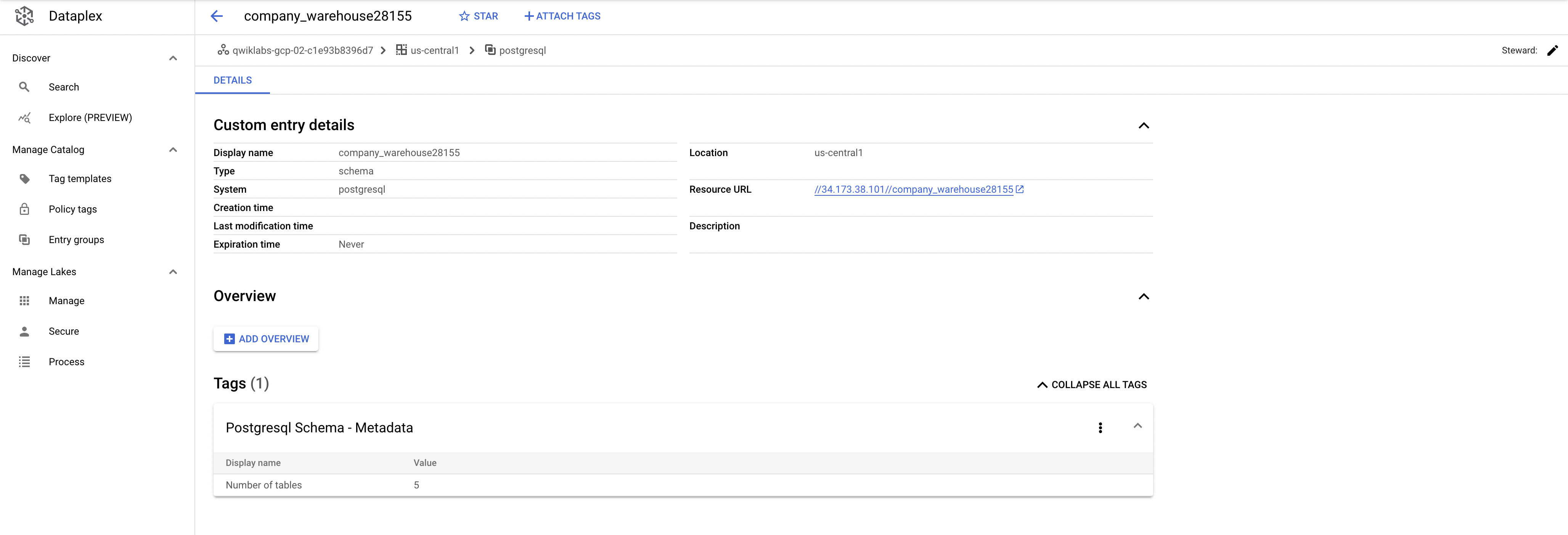

Cliquez sur l'une des entrées warehouse. Regardez les détails et les balises de l'entrée personnalisée :

Détails d'entrée personnalisés et tags :

Voilà tout l'intérêt du connecteur : il permet l'inclusion des métadonnées dans l'index de recherche de Data Catalog.

Effectuer un nettoyage

Exécutez la commande suivante pour supprimer les métadonnées PostgreSQL qui ont été créées :

./cleanup-db.sh

Exécutez maintenant le conteneur responsable du nettoyage :

docker run --rm --tty -v \

"$PWD":/data mesmacosta/postgresql-datacatalog-cleaner:stable \

--datacatalog-project-ids=$PROJECT_ID \

--rdbms-type=postgresql \

--table-container-type=schema

Enfin, supprimez la base de données PostgreSQL :

./delete-db.sh

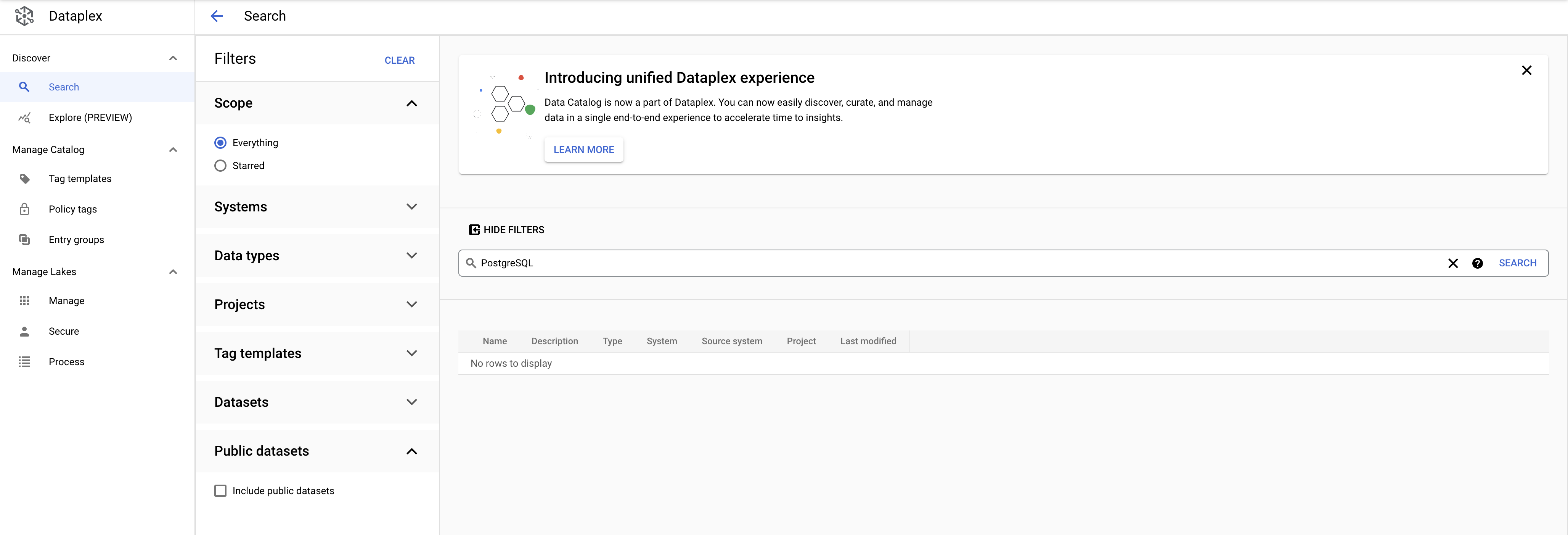

Dans le menu de navigation, sélectionnez Data Catalog. Recherchez PostgreSQL. Les modèles de tag PostgreSQL n'apparaissent plus dans les résultats :

Avant de continuer, vérifiez que vous obtenez le résultat suivant dans Cloud Shell :

Cloud SQL Instance deleted

COMPLETED

Maintenant, vous allez apprendre à réaliser la même opération avec une instance MySQL.

MySQL vers Data Catalog

Créer la base de données MySQL

Exécutez la commande suivante dans Cloud Shell pour revenir à votre répertoire d'accueil :

cd

Exécutez la commande suivante pour télécharger les scripts afin de créer et de remplir votre instance MySQL:

gsutil cp gs://spls/gsp814/cloudsql-mysql-tooling.zip .

unzip cloudsql-mysql-tooling.zip

Passez de votre répertoire de travail actuel au répertoire du dépôt cloné :

cd cloudsql-mysql-tooling

Exécutez maintenant le script init-db.sh :

bash init-db.sh

Votre instance MySQL est créée et renseignée selon un schéma aléatoire. Vous devriez obtenir le résultat suivant au bout de quelques minutes :

CREATE TABLE factory_warehouse14342.persons88a5ebc4 ( address9634 TEXT, cpf12934 FLOAT, food88799 BOOL, food4761 LONGTEXT, credit_card44049 FLOAT, city8417 TINYINT, name76076 DATETIME, address19458 TIME, reason49953 DATETIME )

COMPLETED

Error: Failed to load "tfplan" as a plan file, réexécutez le script init-db.Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Configurer le compte de service

Créez un compte de service :

gcloud iam service-accounts create mysql2dc-credentials \

--display-name "Service Account for MySQL to Data Catalog connector" \

--project $PROJECT_ID

Ensuite, créez et téléchargez la clé du compte de service :

gcloud iam service-accounts keys create "mysql2dc-credentials.json" \

--iam-account "mysql2dc-credentials@$PROJECT_ID.iam.gserviceaccount.com"

Accordez le rôle d'administrateur Data Catalog au compte de service :

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member "serviceAccount:mysql2dc-credentials@$PROJECT_ID.iam.gserviceaccount.com" \

--quiet \

--project $PROJECT_ID \

--role "roles/datacatalog.admin"

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Exécuter un connecteur MySQL vers Data Catalog

Vous pouvez créer le connecteur MySQL manuellement à partir de ce dépôt GitHub.

Pour faciliter son utilisation, nous allons utiliser une image docker.

Les variables nécessaires ont été générées par la configuration Terraform.

Remplacez les répertoires par l'emplacement des scripts Terraform :

cd infrastructure/terraform/

Saisissez les variables d'environnement :

public_ip_address=$(terraform output -raw public_ip_address)

username=$(terraform output -raw username)

password=$(terraform output -raw password)

database=$(terraform output -raw db_name)

Revenez au répertoire racine pour l'exemple de code :

cd ~/cloudsql-mysql-toolingExécutez le connecteur :

docker run --rm --tty -v \

"$PWD":/data mesmacosta/mysql2datacatalog:stable \

--datacatalog-project-id=$PROJECT_ID \

--datacatalog-location-id=us-central1 \

--mysql-host=$public_ip_address \

--mysql-user=$username \

--mysql-pass=$password \

--mysql-database=$database

Vous devriez rapidement obtenir le résultat suivant :

============End mysql-to-datacatalog============

Cliquez sur Vérifier ma progression pour vérifier l'objectif.

Vérifier les résultats du script

Vérifiez que vous êtes bien sur la page d'accueil de Data Catalog.

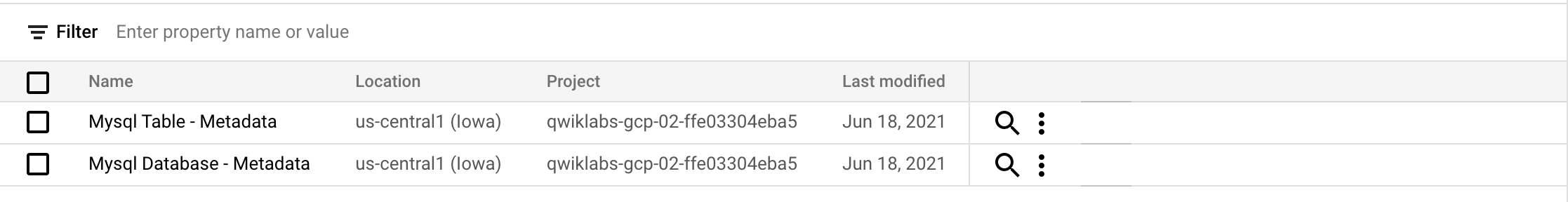

Cliquez sur Modèles de balises.

Vous devriez voir les modèles de balise mysql suivants :

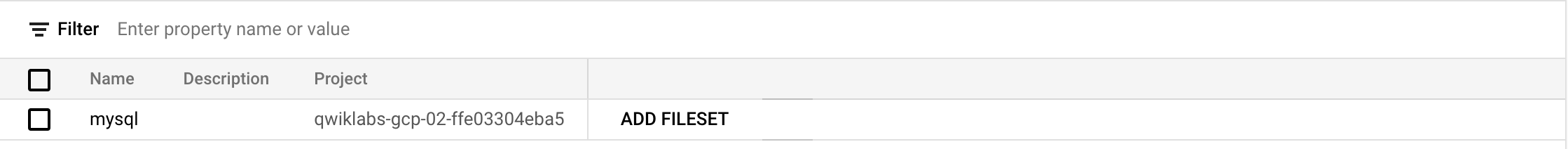

Cliquez sur Groupes d'entrée.

Vous devriez voir le groupe d'entrées mysql suivant :

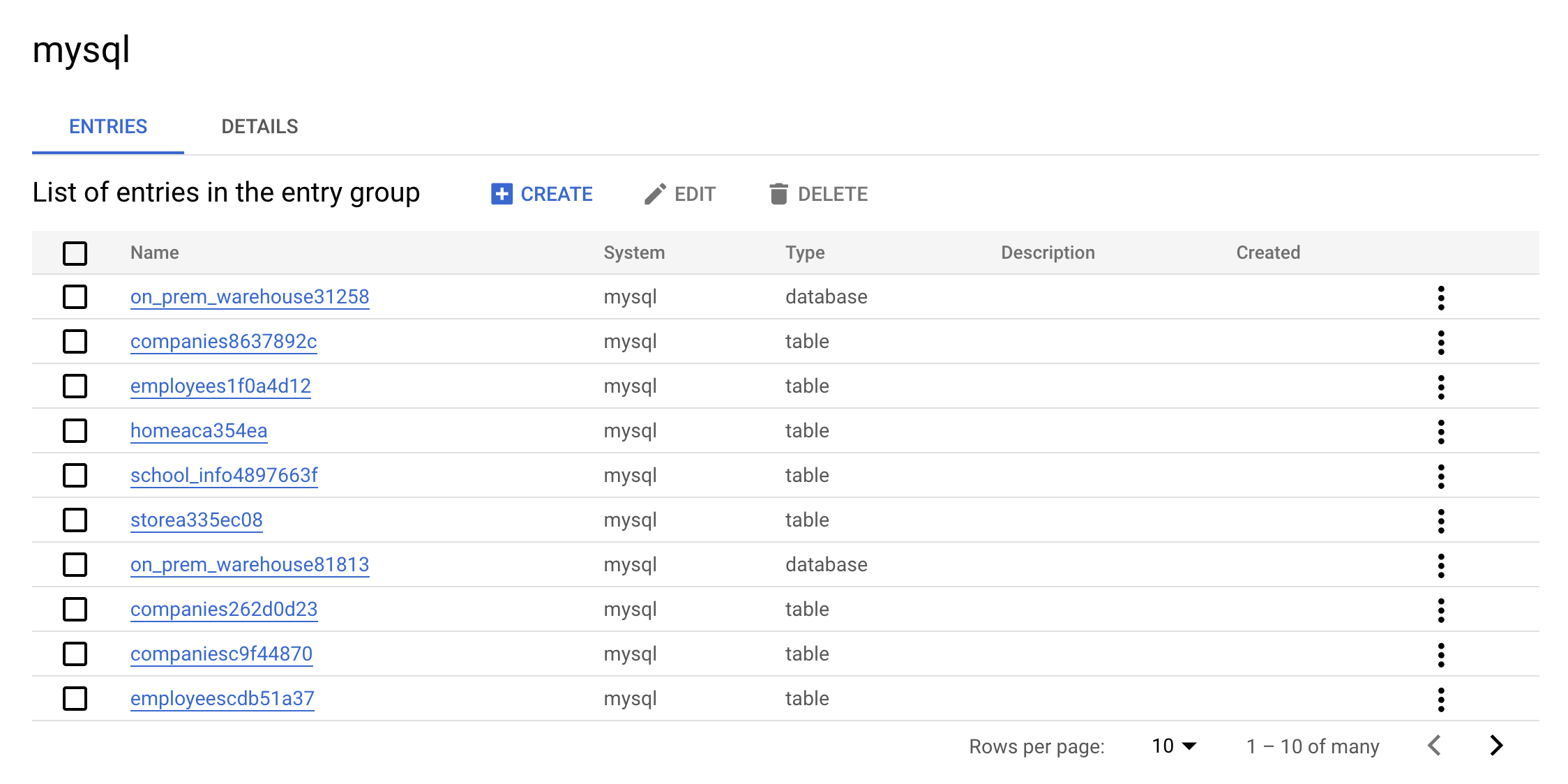

Maintenant, cliquez sur le groupe d'entrées mysql. La console doit se présenter comme suit :

Il s'agit de la valeur réelle d'un groupe d'entrées. L'interface utilisateur affiche toutes les entrées appartenant au groupe "mysql".

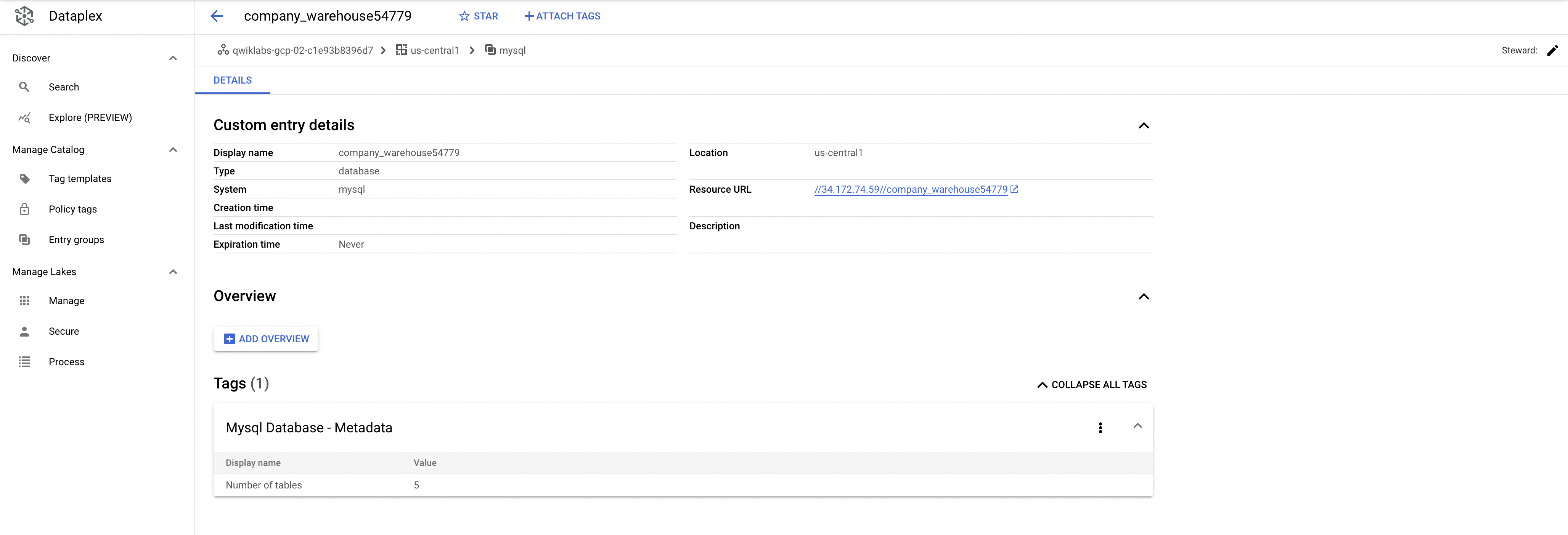

Cliquez sur l'une des entrées warehouse. Regardez les détails et les balises de l'entrée personnalisée :

Détails d'entrée personnalisés et tags :

Voilà tout l'intérêt du connecteur : il permet l'inclusion des métadonnées dans l'index de recherche de Data Catalog.

Effectuer un nettoyage

Exécutez la commande suivante pour supprimer les métadonnées MySQL qui ont été créées :

./cleanup-db.sh

Exécutez maintenant le conteneur responsable du nettoyage :

docker run --rm --tty -v \

"$PWD":/data mesmacosta/mysql-datacatalog-cleaner:stable \

--datacatalog-project-ids=$PROJECT_ID \

--rdbms-type=mysql \

--table-container-type=database

Enfin, supprimez la base de données PostgreSQL :

./delete-db.sh

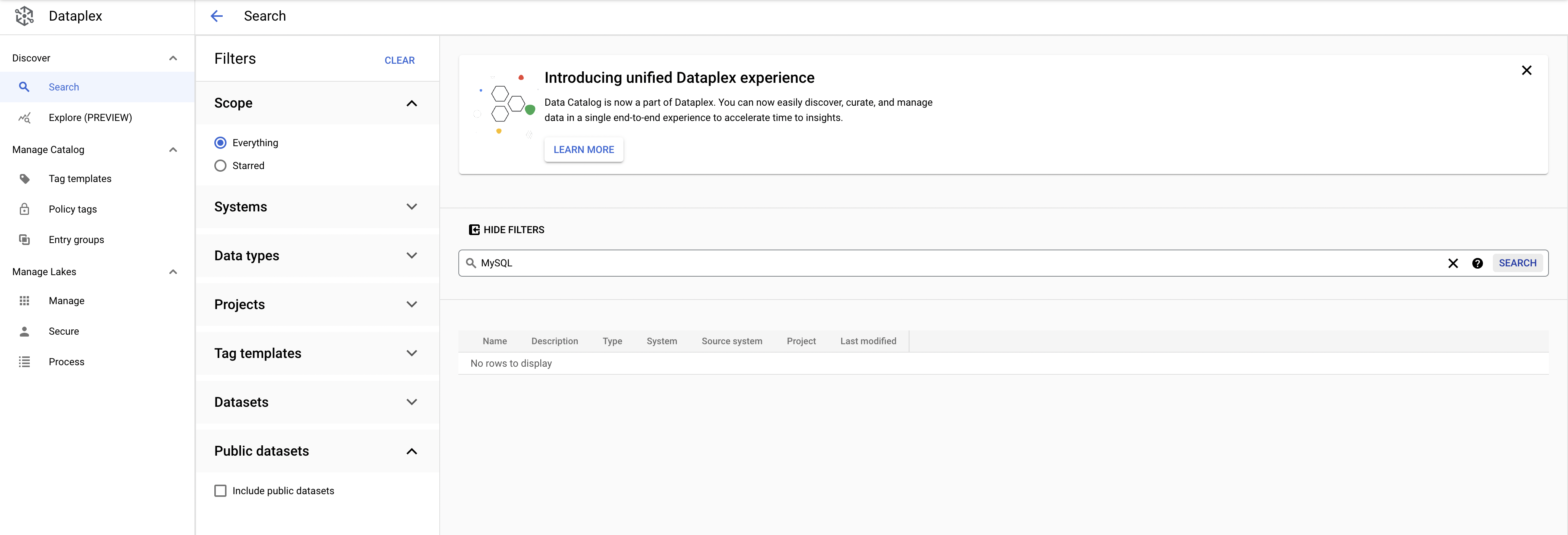

Dans le menu de navigation, sélectionnez Data Catalog. Recherchez MySQL. Les modèles de tag MySQL n'apparaissent plus dans les résultats :

Avant de continuer, vérifiez que vous obtenez le résultat suivant dans Cloud Shell :

Cloud SQL Instance deleted

COMPLETED

Félicitations !

Bravo ! Vous avez suivi un cours pratique sur les connecteurs Data Catalog.

Dans cet atelier, vous avez appris à effectuer les tâches suivantes :

- Activer l'API Data Catalog

- Créer un ensemble de données

- Copier une table publique des taxis new-yorkais dans votre ensemble de données

- Créer un modèle de tag et associer le tag à votre table

Terminer votre quête

Cet atelier d'auto-formation fait partie des quêtes BigQuery for Data Warehousing, BigQuery for Marketing Analysts et Data Catalog Fundamentals. Une quête est une série d'ateliers associés qui constituent une formation. Si vous terminez une quête, vous obtenez un badge attestant de votre réussite. Vous pouvez rendre publics les badges que vous recevez et ajouter leur lien dans votre CV en ligne ou sur vos comptes de réseaux sociaux. Inscrivez-vous à cette quête pour obtenir immédiatement les crédits associés à cet atelier si vous l'avez suivi. Découvrez les autres quêtes Qwiklabs disponibles.

Étapes suivantes et informations supplémentaires

- Consultez la présentation de Data Catalog.

- Découvrez comment effectuer des recherches avec Data Catalog.

- Consultez la présentation des API et des bibliothèques clientes.

Terminer l'atelier

Une fois l'atelier terminé, cliquez sur Terminer l'atelier. Votre compte et les ressources utilisées sont alors supprimés de la plate-forme d'atelier.

Si vous le souhaitez, vous pouvez noter l'atelier. Sélectionnez un nombre d'étoiles, saisissez un commentaire, puis cliquez sur Envoyer.

Voici à quoi correspond le nombre d'étoiles que vous pouvez attribuer à un atelier :

- 1 étoile = très insatisfait(e)

- 2 étoiles = insatisfait(e)

- 3 étoiles = ni insatisfait(e), ni satisfait(e)

- 4 étoiles = satisfait(e)

- 5 étoiles = très satisfait(e)

Si vous ne souhaitez pas donner votre avis, vous pouvez fermer la boîte de dialogue.

Pour soumettre des commentaires, suggestions ou corrections, veuillez accéder à l'onglet Assistance.

Formations et certifications Google Cloud

Les formations et certifications Google Cloud vous aident à tirer pleinement parti des technologies Google Cloud. Nos cours portent sur les compétences techniques et les bonnes pratiques à suivre pour être rapidement opérationnel et poursuivre votre apprentissage. Nous proposons des formations pour tous les niveaux, à la demande, en salle et à distance, pour nous adapter aux emplois du temps de chacun. Les certifications vous permettent de valider et de démontrer vos compétences et votre expérience en matière de technologies Google Cloud.

Dernière mise à jour du manuel : 08 avril 2022

Dernier test de l'atelier : 08 avril 2022

Copyright 2024 Google LLC Tous droits réservés. Google et le logo Google sont des marques de Google LLC. Tous les autres noms d'entreprises et de produits peuvent être des marques des entreprises auxquelles ils sont associés.