Prüfpunkte

Configure HTTP and health check firewall rules

/ 25

Configure instance templates and instance group

/ 25

Configure the HTTP Load Balancer

/ 25

Blacklist the siege-vm

/ 25

Application Load Balancer mit Cloud Armor

- GSP215

- Übersicht

- Einrichtung und Anforderungen

- Aufgabe 1: Firewallregeln für HTTP-Traffic und Systemdiagnose konfigurieren

- Aufgabe 2: Instanzvorlagen konfigurieren und Instanzgruppen erstellen

- Aufgabe 3: Application Load Balancer konfigurieren

- Aufgabe 4: Application Load Balancer testen

- Aufgabe 5: „siege-vm“ auf die Sperrliste setzen

- Glückwunsch!

GSP215

Übersicht

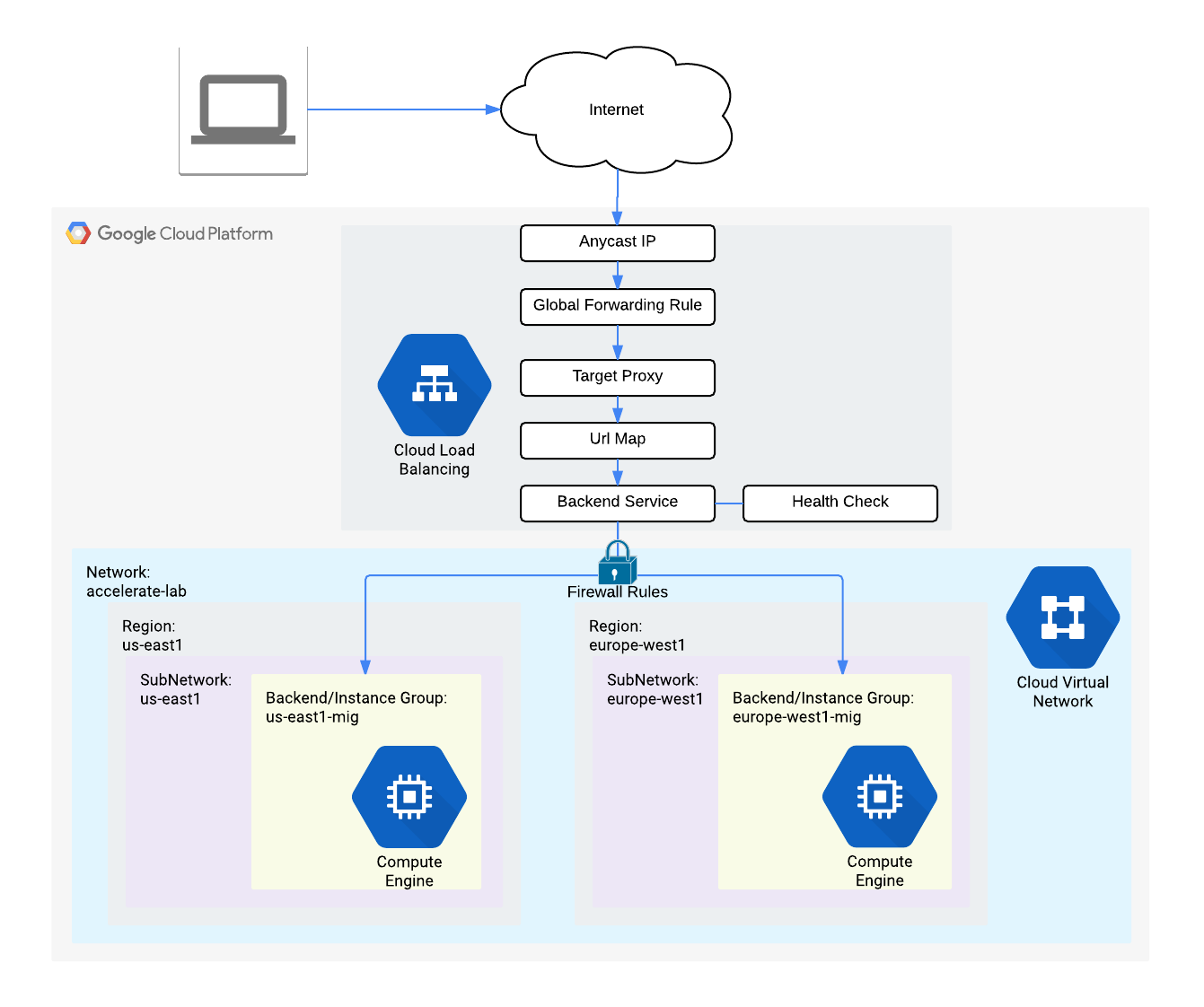

Das Application Load Balancing von Google Cloud wird an den weltweiten Edges des Google-Netzwerks in seinen Points of Presence (POPs) implementiert. Der an einen Application Load Balancer geleitete Nutzer-Traffic gelangt in den POP, der dem Nutzer am nächsten liegt, und wird dann über das globale Google-Netzwerk auf das nächstgelegene Backend mit ausreichender Kapazität verteilt.

Mit Google Cloud Armor können Sie mithilfe von Zulassungslisten bzw. Sperrlisten von IP-Adressen den Zugriff auf Ihren Application Load Balancer an den Edge-Netzwerkstandorten von Google Cloud beschränken oder zulassen, also in größtmöglicher Nähe zum Nutzer und auch zu unerwünschtem Traffic. Dadurch können böswillige Nutzer oder unerwünschter Traffic keine Ressourcen verbrauchen und auch nicht in Ihre VPC-Netzwerke (Virtual Private Cloud) eindringen.

In diesem Lab konfigurieren Sie den im folgenden Diagramm dargestellten Application Load Balancer mit globalen Backends. Danach führen Sie einen Stresstest durch und setzen die Stresstest-IP mithilfe von Cloud Armor auf die Sperrliste.

Lernziele

Aufgaben in diesem Lab:

- Firewallregeln für HTTP-Traffic und Systemdiagnose erstellen

- Zwei Instanzvorlagen konfigurieren

- Zwei verwaltete Instanzgruppen erstellen

- Application Load Balancer mit IPv4 und IPv6 konfigurieren

- Stresstest mit einem Application Load Balancer durchführen

- IP-Adresse auf die Sperrliste setzen, um den Zugriff auf einen Application Load Balancer einzuschränken

Einrichtung und Anforderungen

Vor dem Klick auf „Start Lab“ (Lab starten)

Lesen Sie diese Anleitung. Labs sind zeitlich begrenzt und können nicht pausiert werden. Der Timer beginnt zu laufen, wenn Sie auf Lab starten klicken, und zeigt Ihnen, wie lange die Ressourcen für das Lab verfügbar sind.

In diesem praxisorientierten Lab können Sie die Lab-Aktivitäten in einer echten Cloud-Umgebung selbst durchführen – nicht in einer Simulations- oder Demo-Umgebung. Dazu erhalten Sie neue, temporäre Anmeldedaten, mit denen Sie für die Dauer des Labs auf Google Cloud zugreifen können.

Für dieses Lab benötigen Sie Folgendes:

- Einen Standardbrowser (empfohlen wird Chrome)

- Zeit für die Durchführung des Labs – denken Sie daran, dass Sie ein begonnenes Lab nicht unterbrechen können.

Lab starten und bei der Google Cloud Console anmelden

-

Klicken Sie auf Lab starten. Wenn Sie für das Lab bezahlen müssen, wird ein Pop-up-Fenster geöffnet, in dem Sie Ihre Zahlungsmethode auswählen können. Auf der linken Seite befindet sich der Bereich Details zum Lab mit diesen Informationen:

- Schaltfläche Google Cloud Console öffnen

- Restzeit

- Temporäre Anmeldedaten für das Lab

- Ggf. weitere Informationen für dieses Lab

-

Klicken Sie auf Google Cloud Console öffnen (oder klicken Sie mit der rechten Maustaste und wählen Sie Link in Inkognitofenster öffnen aus, wenn Sie Chrome verwenden).

Im Lab werden Ressourcen aktiviert. Anschließend wird ein weiterer Tab mit der Seite Anmelden geöffnet.

Tipp: Ordnen Sie die Tabs nebeneinander in separaten Fenstern an.

Hinweis: Wird das Dialogfeld Konto auswählen angezeigt, klicken Sie auf Anderes Konto verwenden. -

Kopieren Sie bei Bedarf den folgenden Nutzernamen und fügen Sie ihn in das Dialogfeld Anmelden ein.

{{{user_0.username | "Username"}}} Sie finden den Nutzernamen auch im Bereich Details zum Lab.

-

Klicken Sie auf Weiter.

-

Kopieren Sie das folgende Passwort und fügen Sie es in das Dialogfeld Willkommen ein.

{{{user_0.password | "Password"}}} Sie finden das Passwort auch im Bereich Details zum Lab.

-

Klicken Sie auf Weiter.

Wichtig: Sie müssen die für das Lab bereitgestellten Anmeldedaten verwenden. Nutzen Sie nicht die Anmeldedaten Ihres Google Cloud-Kontos. Hinweis: Wenn Sie Ihr eigenes Google Cloud-Konto für dieses Lab nutzen, können zusätzliche Kosten anfallen. -

Klicken Sie sich durch die nachfolgenden Seiten:

- Akzeptieren Sie die Nutzungsbedingungen.

- Fügen Sie keine Wiederherstellungsoptionen oder Zwei-Faktor-Authentifizierung hinzu (da dies nur ein temporäres Konto ist).

- Melden Sie sich nicht für kostenlose Testversionen an.

Nach wenigen Augenblicken wird die Google Cloud Console in diesem Tab geöffnet.

Aufgabe 1: Firewallregeln für HTTP-Traffic und Systemdiagnose konfigurieren

Konfigurieren Sie Firewallregeln, um HTTP-Traffic zu den Backends und TCP-Traffic von der Systemdiagnose von Google Cloud zuzulassen.

HTTP-Firewallregel erstellen

Erstellen Sie eine Firewallregel, um HTTP-Traffic an die Backends zuzulassen.

-

Öffnen Sie in der Cloud Console das Navigationsmenü (

) und klicken Sie dann auf VPC‑Netzwerk > Firewall.

-

Sie sehen die folgenden Firewallregeln: ICMP, internal, RDP und SSH.

Jedes Google Cloud-Projekt startet mit dem Netzwerk default und dessen Firewallregeln.

-

Klicken Sie auf Firewallregel erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Name default-allow-http Netzwerk default Ziele Angegebene Ziel-Tags Ziel-Tags http-server Quellfilter IPv4-Bereiche Quell-IPv4-Bereiche 0.0.0.0/0 Protokolle und Ports Angegebene Protokolle und Ports, klicken Sie dann auf das Kästchen neben „TCP“ und geben Sie Folgendes ein: 80

Achten Sie darauf, dass /0 in Quell-IPv4-Bereiche enthalten ist und so alle Netzwerke angegeben sind.

- Klicken Sie auf Erstellen.

Firewallregeln für die Systemdiagnose erstellen

Mit Systemdiagnosen wird ermittelt, zu welchen Instanzen eines Load Balancers neue Verbindungen aufgebaut werden können. Beim Application Load Balancing werden die Systemdiagnosen für Ihre Instanzen mit Load Balancing über Adressen in den Bereichen 130.211.0.0/22 und 35.191.0.0/16 durchgeführt. Ihre Firewallregeln müssen diese Verbindungen zulassen.

-

Klicken Sie auf der Seite Firewallrichtlinien auf Firewallregel erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Name default-allow-health-check Netzwerk default Ziele Angegebene Ziel-Tags Ziel-Tags http-server Quellfilter IPv4-Bereiche Quell-IPv4-Bereiche 130.211.0.0/22,35.191.0.0/16Protokolle und Ports Angegebene Protokolle und Ports, klicken Sie dann auf das Kästchen neben „TCP“ Hinweis: Achten Sie darauf, die beiden Quell-IPv4-Bereiche nacheinander und durch ein Leerzeichen getrennt einzugeben. -

Klicken Sie auf Erstellen.

Klicken Sie auf Fortschritt prüfen.

Aufgabe 2: Instanzvorlagen konfigurieren und Instanzgruppen erstellen

Mit einer Instanzvorlage kann in einer verwalteten Instanzgruppe eine Gruppe identischer Instanzen eingerichtet werden. Erstellen Sie damit die Backends des Application Load Balancers.

Instanzvorlagen konfigurieren

Eine Instanzvorlage ist eine API-Ressource, mit der Sie VM-Instanzen und verwaltete Instanzgruppen erstellen können. In Instanzvorlagen sind Maschinentyp, Image des Bootlaufwerks, Subnetz, Labels und andere Instanzattribute definiert.

Erstellen Sie eine Instanzvorlage für

-

Öffnen Sie in der Cloud Console das Navigationsmenü (

) > Compute Engine > Instanzvorlagen und klicken Sie dann auf Instanzvorlage erstellen.

-

Geben Sie unter Name die Bezeichnung

-template ein. -

Wählen Sie unter Standort die Option Global aus.

-

Wählen Sie unter Reihe die Option E2 aus.

-

Wählen Sie als Maschinentyp die Option e2-micro aus.

-

Klicken Sie auf Erweiterte Optionen.

-

Klicken Sie auf Netzwerke. Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen Werte die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Netzwerk-Tags http-server -

Klicken Sie unter Netzwerkschnittstellen auf default. Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Netzwerk default Subnetzwerk default Klicken Sie auf Fertig.

Durch das Netzwerk-Tag http-server wird sichergestellt, dass die Firewallregeln für HTTP-Traffic und Systemdiagnose auf diese Instanzen angewendet werden.

-

Klicken Sie auf den Tab Verwaltung.

-

Klicken Sie unter Metadaten auf + ELEMENT HINZUFÜGEN und geben Sie Folgendes an:

Schlüssel Wert startup-script-url gs://cloud-training/gcpnet/httplb/startup.sh

Mit dem Schlüssel startup-script-url wird festgelegt, welches Skript ausgeführt wird, wenn Instanzen gestartet werden. Durch dieses Skript wird Apache installiert und die Begrüßungsseite so geändert, dass sie die Client-IP sowie den Namen, die Region und die Zone der VM-Instanz enthält. Sie können sich das Skript hier ansehen.

- Klicken Sie auf Erstellen.

- Warten Sie, bis die Instanzvorlage erstellt wurde.

Erstellen Sie nun eine weitere Instanzvorlage für subnet-b. Kopieren Sie hierfür die Vorlage

- Klicken Sie auf

-template und dann oben auf die Option + ÄHNLICHE ERSTELLEN. - Geben Sie unter Name die Bezeichnung

-template ein. - Wählen Sie unter Standort die Option Global aus.

- Klicken Sie auf Erweiterte Optionen.

- Klicken Sie auf Netzwerke.

- Achten Sie darauf, dass http-server als Netzwerk-Tag hinzugefügt wird.

- Wählen Sie im Abschnitt Netzwerkschnittstellen für Subnetzwerk die Option default (

) aus. - Klicken Sie auf Fertig.

- Klicken Sie auf Erstellen.

Verwaltete Instanzgruppen erstellen

Erstellen Sie eine verwaltete Instanzgruppe in

-

Klicken Sie unter Compute Engine im linken Menü auf Instanzgruppen.

-

Klicken Sie auf Instanzgruppe erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Name -mig. Entfernen Sie, falls nötig, das zusätzliche Leerzeichen aus dem Namen. Instanzvorlage -template Standort Mehrere Zonen Region Mindestanzahl von Instanzen 1 Maximale Anzahl von Instanzen 2 Autoscaling-Signale > Klicken Sie auf das Drop-down-Menü und dann auf „Signaltyp“. CPU-Auslastung CPU-Zielauslastung 80, klicken Sie auf Fertig. Initialisierungsphase 45

Verwaltete Instanzgruppen bieten Funktionen für das Autoscaling, mit denen Sie Instanzen lastabhängig automatisch hinzufügen oder entfernen lassen können. Mit Autoscaling bewältigen Ihre Anwendungen Anstiege im Traffic reibungslos. Darüber hinaus sinken bei einem geringeren Ressourcenbedarf die Kosten. Dazu definieren Sie einfach eine Autoscaling-Richtlinie zur automatischen Skalierung, die auf der gemessenen Last basiert.

- Klicken Sie auf Erstellen.

Wiederholen Sie den Vorgang jetzt, um in

-

Klicken Sie auf Instanzgruppe erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Name -mig Instanzvorlage -template Standort Mehrere Zonen Region Mindestanzahl von Instanzen 1 Maximale Anzahl von Instanzen 2 Autoscaling-Signale > Klicken Sie auf das Drop-down-Menü und dann auf „Signaltyp“. CPU-Auslastung CPU-Zielauslastung 80, klicken Sie auf Fertig. Initialisierungsphase 45 -

Klicken Sie auf Erstellen.

Klicken Sie auf Fortschritt prüfen.

Backends prüfen

Vergewissern Sie sich, dass VM-Instanzen in beiden Regionen erstellt werden und auf ihre HTTP-Websites zugreifen.

-

Klicken Sie unter Compute Engine im linken Menü auf VM-Instanzen.

-

Achten Sie auf die Instanzen, die mit

-mig und -mig beginnen. Diese Instanzen sind Teil der verwalteten Instanzgruppen.

-

Klicken Sie auf die externe IP-Adresse einer Instanz von

-mig. Es sollten dann die Client-IP (Ihre IP-Adresse), der Hostname (beginnt mit

-mig) und der Serverstandort (eine Zone in ) angezeigt werden. -

Klicken Sie auf die externe IP-Adresse einer Instanz von

-mig. Es sollten dann die Client-IP (Ihre IP-Adresse), der Hostname (beginnt mit

-mig) und der Serverstandort (eine Zone in ) angezeigt werden.

Aufgabe 3: Application Load Balancer konfigurieren

Konfigurieren Sie den Application Load Balancer, damit Traffic zwischen den beiden Backends (

Konfiguration starten

-

Klicken Sie in der Cloud Console auf Navigationsmenü (

) > ALLE PRODUKTE ANSEHEN > Netzwerk > Netzwerkdienste > Load Balancing.

-

Klicken Sie auf Load Balancer erstellen.

-

Klicken Sie unter Application Load Balancer HTTP(S) auf „Weiter“.

-

Wählen Sie für Öffentlich oder intern die Option Öffentlich (extern) aus und klicken Sie auf „Weiter“.

-

Wählen Sie unter Globale Bereitstellung oder Bereitstellung in einzelner Region die Option Optimal für globale Arbeitslasten aus und klicken Sie auf „Weiter“.

-

Klicken Sie unter Load Balancer erstellen auf Konfigurieren.

-

Legen Sie als Name des Load Balancers

http-lbfest.

Frontend konfigurieren

Host- und Pfadregeln bestimmen, wohin Ihr Traffic weitergeleitet wird. Sie könnten beispielsweise Traffic, der durch Videos entsteht, an ein Backend weiterleiten und Traffic, der aus statischen Daten entsteht, an ein anderes Backend. Allerdings konfigurieren wir in diesem Lab keine Host- und Pfadregeln.

-

Klicken Sie auf Frontend-Konfiguration.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellungen:

Attribut Wert (Wert eingeben bzw. Option auswählen) Protokoll HTTP IP-Version IPv4 IP-Adresse Sitzungsspezifisch Port 80 -

Klicken Sie auf Fertig.

-

Klicken Sie auf Frontend-IP-Adresse und -Port hinzufügen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellungen:

Attribut Wert (Wert eingeben bzw. Option auswählen) Protokoll HTTP IP-Version IPv6 IP-Adresse Automatisch zuweisen Port 80 -

Klicken Sie auf Fertig.

Das Application Load Balancing unterstützt Client-Traffic von IPv4- und IPv6-Adressen. IPv6-Anfragen von Clients werden auf der Load-Balancing-Ebene terminiert und dann über IPv4 an die Backends weitergeleitet.

Backend konfigurieren

Backend-Dienste leiten eingehenden Traffic an ein oder mehrere verknüpfte Backends weiter. Jedes Backend besteht aus einer Instanzgruppe und zusätzlichen Metadaten zur Kapazität.

-

Klicken Sie auf Backend-Konfiguration.

-

Klicken Sie unter Backend-Dienste und Backend-Buckets auf Backend-Dienst erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Option auswählen) Name http-backend Instanzgruppe -mig Portnummern 80 Balancing-Modus Rate Maximale Anzahl der Anfragen pro Sekunde 50 Kapazität 100

Diese Konfiguration bedeutet, dass der Load Balancer versucht, jede Instanz von

-

Klicken Sie auf Fertig.

-

Klicken Sie auf Backend hinzufügen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Option auswählen) Instanzgruppe -mig Portnummern 80 Balancing-Modus Auslastung Maximale Backend-Auslastung 80 Kapazität 100

Diese Konfiguration bedeutet, dass der Load Balancer versucht, jede Instanz von

-

Klicken Sie auf Fertig.

-

Klicken Sie unter Systemdiagnose auf Systemdiagnose erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen Werte die Standardeinstellung:

Attribut Wert (Option auswählen) Name http-health-check Protokoll TCP Port 80

Mit Systemdiagnosen lässt sich herausfinden, zu welchen Instanzen neue Verbindungen aufgebaut werden können. Diese HTTP-Systemdiagnose fragt Instanzen alle fünf Sekunden ab und wartet bis zu fünf Sekunden auf eine Antwort. Bei zwei erfolgreichen oder zwei fehlgeschlagenen Versuchen wird das System als fehlerfrei bzw. fehlerhaft bewertet.

- Klicken Sie auf Speichern.

- Klicken Sie auf das Kästchen für Logging aktivieren.

- Legen Sie die Abtastrate auf

1fest. - Klicken Sie auf Erstellen, um den Backend-Dienst zu erstellen.

- Klicken Sie auf OK.

Application Load Balancer prüfen und erstellen

- Klicken Sie auf Prüfen und abschließen.

- Prüfen Sie den Backend- und den Frontend-Dienst.

- Klicken Sie auf Erstellen.

- Warten Sie, bis der Load Balancer erstellt ist.

- Klicken Sie auf den Namen des Load Balancers (http-lb).

- Sehen Sie sich für die nächste Aufgabe die IPv4- und IPv6-Adressen des Load Balancers an. Sie lauten

[LB_IP_v4]bzw.[LB_IP_v6].

Klicken Sie auf Fortschritt prüfen.

Aufgabe 4: Application Load Balancer testen

Nachdem Sie einen Application Load Balancer für Ihre Backends erstellt haben, prüfen Sie nun, ob der Traffic zum Backend-Dienst weitergeleitet wird.

Auf den Application Load Balancer zugreifen

Öffnen Sie einen neuen Tab im Browser und rufen Sie http://[LB_IP_v4] auf, um den IPv4-Zugriff auf den Application Load Balancer zu testen. Ersetzen Sie dabei [LB_IP_v4] durch die IPv4-Adresse des Load Balancers.

Wenn Sie eine lokale IPv6-Adresse haben, versuchen Sie die IP-Adresse des Application Load Balancers unter http://[LB_IP_v6] aufzurufen. Ersetzen Sie [LB_IP_v6] durch die IPv6-Adresse des Load Balancers.

Stresstest des Application Load Balancers durchführen

Erstellen Sie mit siege eine virtuelle Maschine (VM), um eine Last auf dem Application Load Balancer zu simulieren. Stellen Sie dann fest, ob der Traffic zwischen den beiden Backends ausgeglichen wird, wenn die Last hoch ist.

-

Öffnen Sie in der Console das Navigationsmenü (

) und klicken Sie dann auf Compute Engine > VM-Instanzen.

-

Klicken Sie auf Instanz erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen Werte die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Name siege-vm Region Zone Reihe E2

Da

- Klicken Sie auf Erstellen.

- Warten Sie, bis die Instanz siege-vm erstellt ist.

- Klicken Sie bei siege-vm auf SSH, um ein Terminal zu starten und eine Verbindung herzustellen.

- Führen Sie den folgenden Befehl aus, um „siege“ zu installieren:

- Führen Sie den folgenden Befehl aus, um die IPv4-Adresse des Application Load Balancers in einer Umgebungsvariable zu speichern. Ersetzen Sie dabei

[LB_IP_v4]durch die IPv4-Adresse:

- Führen Sie den folgenden Befehl aus, um eine Last zu simulieren:

-

Klicken Sie in der Cloud Console auf Navigationsmenü (

) > ALLE PRODUKTE ANSEHEN > Netzwerk > Netzwerkdienste > Load Balancing.

-

Klicken Sie auf Backends.

-

Klicken Sie auf http-backend.

-

Wechseln Sie zu http-lb.

-

Klicken Sie auf den Tab Monitoring.

-

Beobachten Sie zwei bis drei Minuten lang unter Frontend-Zone (Eingehender Traffic insgesamt) den Traffic zwischen Nordamerika und den beiden Backends.

Zuerst sollte der Traffic nur an

Sie sehen, dass der Traffic standardmäßig an das nächstgelegene Backend weitergeleitet wird. Wird der Traffic aber zu hoch, kann er über mehrere Backends verteilt werden.

- Kehren Sie zum SSH-Terminal von siege-vm zurück.

- Drücken Sie Strg + C, um „siege“ zu beenden, falls es noch ausgeführt wird.

Die Ausgabe sollte in etwa so aussehen:

Aufgabe 5: „siege-vm“ auf die Sperrliste setzen

Setzen Sie siege-vm mithilfe von Cloud Armor auf die Sperrliste. So verhindern Sie den Zugriff auf den Application Load Balancer.

Sicherheitsrichtlinie erstellen

Erstellen Sie eine Cloud Armor-Sicherheitsrichtlinie mit einer Regel, die siege-vm auf die Sperrliste setzt.

- Öffnen Sie in der Console das Navigationsmenü (

) und klicken Sie dann auf Compute Engine > VM-Instanzen.

- Sehen Sie sich die externe IP-Adresse von siege-vm an. Sie wird hier als

[SIEGE_IP]bezeichnet.

-

Klicken Sie in der Cloud Console auf Navigationsmenü (

) > ALLE PRODUKTE ANSEHEN > Netzwerk > Netzwerksicherheit > Cloud Armor-Richtlinien.

-

Klicken Sie auf Richtlinie erstellen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Name denylist-siege Aktion der Standardregel Zulassen -

Klicken Sie auf Nächster Schritt.

-

Klicken Sie auf Regel hinzufügen.

-

Legen Sie die folgenden Werte fest und übernehmen Sie für alle anderen die Standardeinstellung:

Attribut Wert (Wert eingeben bzw. Option auswählen) Bedingung > Übereinstimmung Geben Sie die SIEGE_IP-Adresse ein. Vorgang Ablehnen Antwortcode 403 (Unzulässig) Priorität 1000 -

Klicken Sie auf Fertig.

-

Klicken Sie auf Nächster Schritt.

-

Klicken Sie auf Ziel hinzufügen.

-

Wählen Sie unter Typ die Option Backend-Dienst (externer Application Load Balancer) aus.

-

Wählen Sie http-backend als Ziel aus.

-

Klicken Sie auf Richtlinie erstellen.

- Warten Sie, bis die Richtlinie erstellt ist, bevor Sie fortfahren.

Klicken Sie auf Fortschritt prüfen.

Sicherheitsrichtlinie prüfen

Vergewissern Sie sich, dass siege-vm nicht auf den Application Load Balancer zugreifen kann.

- Kehren Sie zum SSH-Terminal von siege-vm zurück.

- Führen Sie folgenden Befehl aus, um auf den Load Balancer zuzugreifen:

Die Ausgabe sollte in etwa so aussehen:

- Öffnen Sie einen neuen Browsertab und rufen Sie

http://[LB_IP_v4]auf. Ersetzen Sie dabei[LB_IP_v4]durch die IPv4-Adresse des Load Balancers.

- Führen Sie im SSH-Terminal von „siege-vm“ den folgenden Befehl aus, um eine Last zu simulieren:

Mit dem Befehl wird keine Ausgabe generiert.

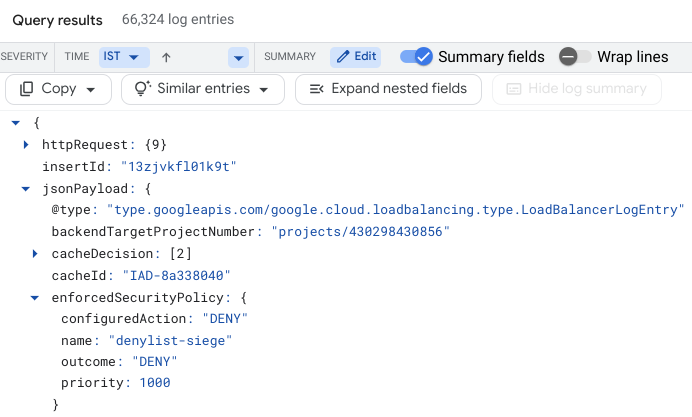

Untersuchen Sie die Protokolle der Sicherheitsrichtlinie, um festzustellen, ob dieser Traffic auch blockiert wird.

- Öffnen Sie in der Console das Navigationsmenü. Klicken Sie auf Netzwerksicherheit und dann auf Cloud Armor-Richtlinien.

- Klicken Sie auf denylist-siege.

- Klicken Sie auf Logs.

- Klicken Sie auf Richtlinienlogs ansehen.

- Löschen Sie auf der Logging-Seite unbedingt den gesamten Text der Abfragevorschau. Wählen Sie als Ressource Application Load Balancer > http-lb-forwarding-rule > http-lb aus und klicken Sie dann auf Anwenden.

- Klicken Sie jetzt auf Abfrage ausführen.

- Maximieren Sie einen der Logeinträge unter Abfrageergebnisse.

- Maximieren Sie httpRequest.

Diese Anfrage sollte von der IP-Adresse von siege-vm stammen. Falls nicht, maximieren Sie einen anderen Logeintrag.

- Maximieren Sie jsonPayload.

- Maximieren Sie enforcedSecurityPolicy.

- Sie sehen, dass configuredAction den Wert

DENYund den Namendenylist-siegehat.

Sicherheitsrichtlinien von Cloud Armor erstellen Logs, die Sie untersuchen können, um festzustellen, wann Traffic zugelassen oder abgelehnt wurde und aus welcher Quelle er stammt.

Glückwunsch!

Sie haben einen Application Load Balancer mit Backends in

Weitere Informationen

Google Cloud-Schulungen und -Zertifizierungen

In unseren Schulungen erfahren Sie alles zum optimalen Einsatz unserer Google Cloud-Technologien und können sich entsprechend zertifizieren lassen. Unsere Kurse vermitteln technische Fähigkeiten und Best Practices, damit Sie möglichst schnell mit Google Cloud loslegen und Ihr Wissen fortlaufend erweitern können. Wir bieten On-Demand-, Präsenz- und virtuelle Schulungen für Anfänger wie Fortgeschrittene an, die Sie individuell in Ihrem eigenen Zeitplan absolvieren können. Mit unseren Zertifizierungen weisen Sie nach, dass Sie Experte im Bereich Google Cloud-Technologien sind.

Anleitung zuletzt am 24. Oktober 2024 aktualisiert

Lab zuletzt am 18. April 2024 getestet

© 2024 Google LLC. Alle Rechte vorbehalten. Google und das Google-Logo sind Marken von Google LLC. Alle anderen Unternehmens- und Produktnamen können Marken der jeweils mit ihnen verbundenen Unternehmen sein.