Checkpoints

Create an API Key

/ 25

Create a request to Classify a news article

/ 25

Check the Entity Analysis response

/ 25

Create a new Dataset and table for categorized text data

/ 25

Classificar texto em categorias com a API Natural Language

- GSP063

- Visão geral

- Configuração e requisitos

- Tarefa 1: ativar a API Cloud Natural Language

- Tarefa 2: crie uma chave de API

- Tarefa 3: classifique uma notícia

- Tarefa 4: classificar um grande conjunto de dados de texto

- Tarefa 5: criar uma tabela do BigQuery para dados de texto categorizados

- Tarefa 6: classificar dados de notícias e armazenar o resultado no BigQuery

- Tarefa 7: analisar os dados de notícias categorizados no BigQuery

- Parabéns!

GSP063

Visão geral

Com a API Cloud Natural Language, é possível extrair entidades do texto, fazer análises sintáticas e de sentimento e classificar o texto em categorias. Este laboratório tem como foco a classificação de textos. Com um banco de dados de mais de 700 categorias, esse recurso de API facilita a classificação de um grande conjunto de dados de texto.

Conteúdo do laboratório

- Como criar uma solicitação da API Natural Language e chamar a API com curl

- Como usar o recurso de classificação de texto da API NL

- Como usar a classificação de texto para entender um conjunto de dados de artigos de notícias

Configuração e requisitos

Antes de clicar no botão Start Lab

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é iniciado quando você clica em Começar o laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

- Tempo para concluir o laboratório---não se esqueça: depois de começar, não será possível pausar o laboratório.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar, você verá um pop-up para selecionar a forma de pagamento. No painel Detalhes do laboratório à esquerda, você vai encontrar o seguinte:

- O botão Abrir console do Google Cloud

- O tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações, se forem necessárias

-

Se você estiver usando o navegador Chrome, clique em Abrir console do Google Cloud ou clique com o botão direito do mouse e selecione Abrir link em uma janela anônima.

O laboratório ativa os recursos e depois abre a página Fazer login em outra guia.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta. -

Se necessário, copie o Nome de usuário abaixo e cole na caixa de diálogo Fazer login.

{{{user_0.username | "Nome de usuário"}}} Você também encontra o Nome de usuário no painel Detalhes do laboratório.

-

Clique em Seguinte.

-

Copie a Senha abaixo e cole na caixa de diálogo de boas-vindas.

{{{user_0.password | "Senha"}}} Você também encontra a Senha no painel Detalhes do laboratório.

-

Clique em Seguinte.

Importante: você precisa usar as credenciais fornecidas no laboratório, e não as da sua conta do Google Cloud. Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais. -

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do Google Cloud será aberto nesta guia.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

- Clique em Ativar o Cloud Shell

na parte de cima do console do Google Cloud.

Depois de se conectar, vai notar que sua conta já está autenticada, e que o projeto está configurado com seu PROJECT_ID. A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

-

Clique em Autorizar.

-

A saída será parecida com esta:

Saída:

- (Opcional) É possível listar o ID do projeto usando este comando:

Saída:

Exemplo de saída:

gcloud, acesse o guia com informações gerais sobre a gcloud CLI no Google Cloud.

Tarefa 1: ativar a API Cloud Natural Language

-

Expanda o Menu de navegação (

) na parte superior esquerda da tela.

-

Selecione APIs e serviços > APIs e serviços ativados.

- Clique em Ativar APIs e serviços.

-

Em seguida, digite

languagena caixa de pesquisa. -

Clique em API Cloud Natural Language:

O botão Ativar vai aparecer se a API não estiver ativada.

- Clique em Ativar para ativar a API Cloud Natural Language.

Quando a API está ativada, o Google Cloud exibe informações sobre ela da seguinte forma:

Tarefa 2: crie uma chave de API

Já que você usa curl para enviar uma solicitação à API Natural Language, é necessário gerar uma chave de API para transmitir o URL da solicitação.

-

Para criar uma chave de API, acesse o console e clique em Menu de navegação > APIs e serviços > Credenciais.

-

Em seguida, clique em Criar credenciais.

-

No menu suspenso, selecione Chave de API.

-

Depois, copie a chave gerada e clique em Fechar.

Clique em Verificar meu progresso para conferir o objetivo.

Agora salve a chave de API como uma variável de ambiente para não precisar digitá-la em cada solicitação.

Para realizar as próximas etapas, conecte-se à instância provisionada para você por SSH.

- Abra o Menu de navegação e selecione Compute Engine > Instâncias de VM. Uma

linux-instanceprovisionada será exibida.

-

Clique no botão SSH. Um shell interativo será exibido.

-

Na linha de comando, digite as seguintes informações e substitua

<YOUR_API_KEY>pela chave que você copiou:

Tarefa 3: classifique uma notícia

Com o método classifyText da API Natural Language, você pode classificar dados de texto em categorias com uma única chamada da API. Esse método retorna uma lista de categorias de conteúdo que se aplicam a um documento de texto.

As categorias variam de amplas, como /Computers & Electronics, a altamente específicas, como /Computers & Electronics/Programming/Java (Programming Language). A lista completa das mais de 700 categorias possíveis está disponível na página Categorias de conteúdo.

Você vai começar classificando um único artigo e descobrindo como usar esse método para entender um grande conjunto de notícias.

- Confira esta manchete e esta descrição de um artigo do New York Times na seção de alimentos:

A Smoky Lobster Salad With a Tapa Twist. This spin on the Spanish pulpo a la gallega skips the octopus, but keeps the sea salt, olive oil, pimentón and boiled potatoes.

- Crie um arquivo chamado

request.jsone adicione o código abaixo. É possível criar o arquivo usando um dos seus editores de linha de comando preferenciais (nano, vim, emacs).

- Agora você pode enviar este texto para o método

classifyTextda API Natural Language com o seguinte comandocurl:

Confira a resposta:

Você criou uma solicitação da API Speech e chamou a API Speech.

- Execute este comando para salvar a resposta em um arquivo

result.json:

A API retornou duas categorias para o texto:

/Food & Drink/Cooking & Recipes/Food & Drink/Food/Meat & Seafood

O texto não menciona explicitamente que se trata de uma receita ou mesmo que inclui frutos do mar, mas a API é capaz de categorizá-lo. Classificar um único artigo é interessante. No entanto, para conhecer toda a capacidade desse recurso, classifique muitos dados de texto.

Tarefa 4: classificar um grande conjunto de dados de texto

Para conferir como o método classifyText pode ajudar você a entender um grande conjunto de dados de texto, use este conjunto de dados públicos baseado em matérias da BBC. O conjunto de dados é composto por 2.225 artigos em cinco áreas temáticas (negócios, entretenimento, política, esportes e tecnologia) de 2004 a 2005. Um subconjunto desses artigos está armazenado em um bucket público do Cloud Storage. Cada um dos artigos está em um arquivo .txt.

Para examinar os dados e enviá-los para a API Natural Language, você escreverá um script do Python para ler cada arquivo de texto do Cloud Storage, enviá-lo para o endpoint classifyText e armazenar os resultados em uma tabela do BigQuery. O BigQuery é a ferramenta de data warehouse para Big Data do Google Cloud. Com ele, você pode armazenar e analisar facilmente grandes conjuntos de dados.

- Execute o comando a seguir para conferir um dos artigos com que você vai trabalhar. O

gsutilé uma interface de linha de comando para o Cloud Storage.

Em seguida, você vai criar uma tabela do BigQuery para os dados.

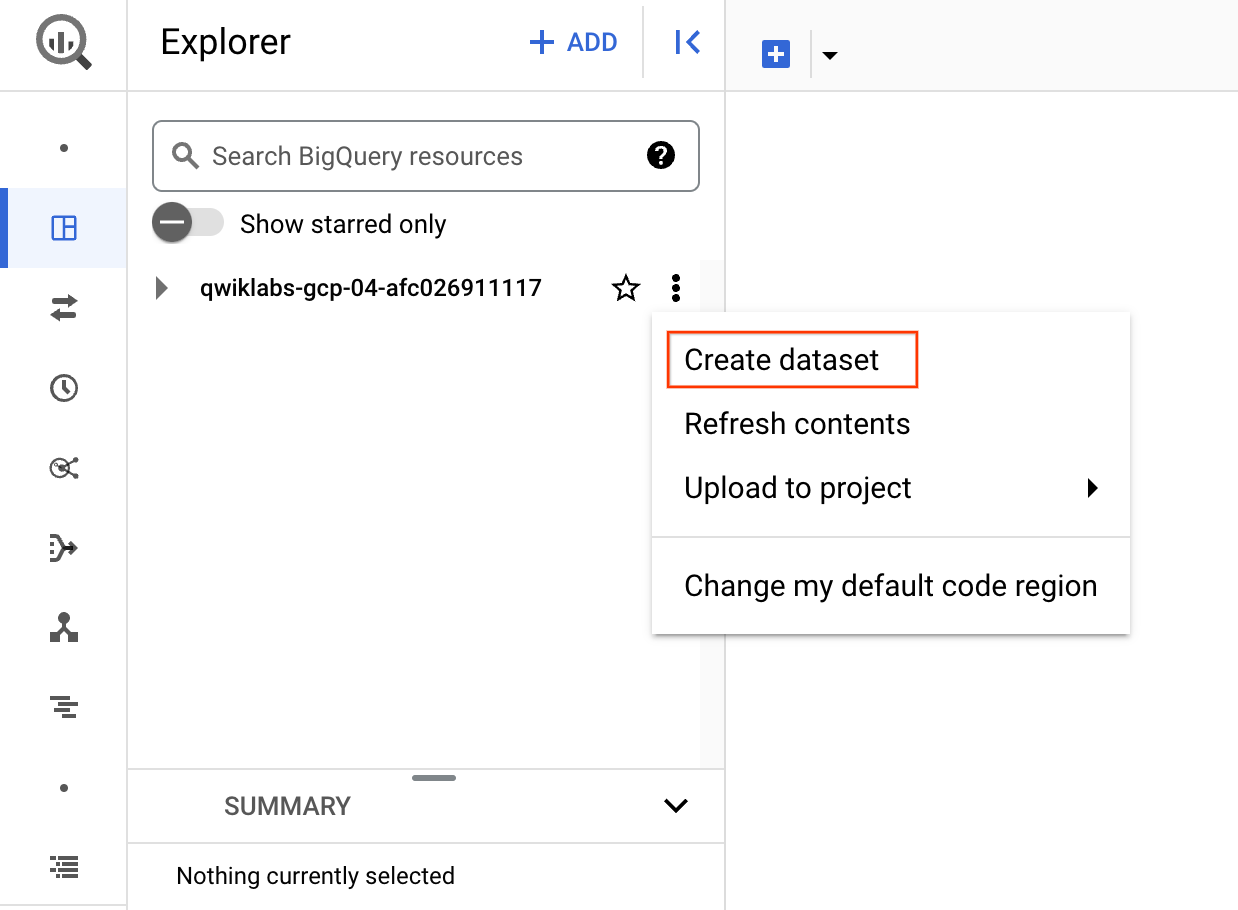

Tarefa 5: criar uma tabela do BigQuery para dados de texto categorizados

Antes de enviar o texto para a API Natural Language, você precisa de um local para armazenar o texto e a categoria de cada artigo.

-

Acesse Menu de navegação > BigQuery no console.

-

Clique em Concluído.

-

Para criar um conjunto de dados, clique no ícone Exibir ações ao lado do ID do projeto e selecione Criar conjunto de dados:

-

Dê o nome

news_classification_datasetao conjunto de dados e clique em Criar conjunto de dados. -

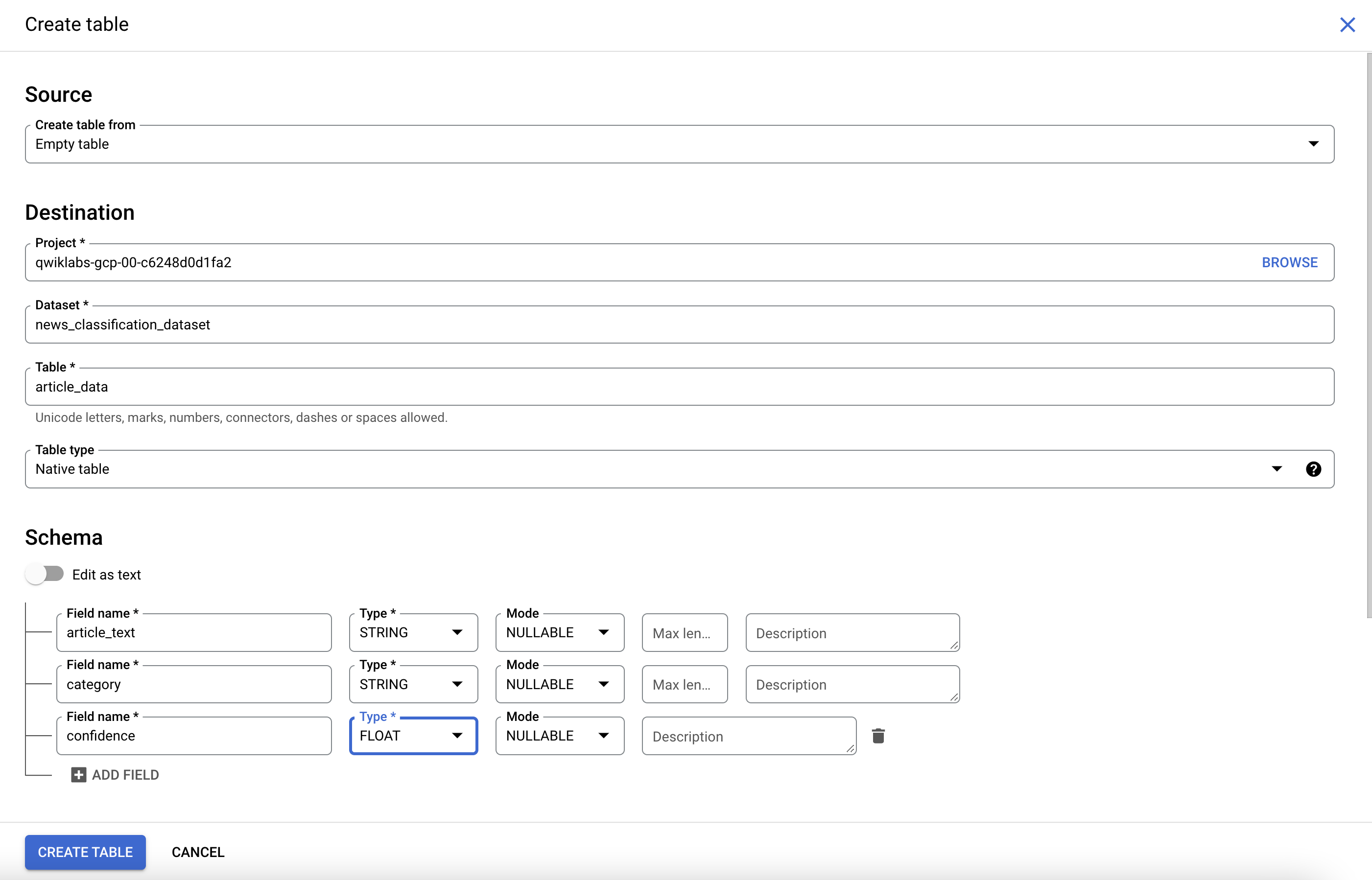

Para criar uma tabela, clique no ícone Exibir ações ao lado de

news_classification_datasete selecione Criar tabela.

- Use as configurações abaixo para a nova tabela:

- Criar tabela de: Tabela em branco

- Dê o nome article_data à tabela.

- Em "Esquema", clique em Adicionar campo e adicione os três seguintes campos:

| Nome do campo | Tipo | Modo |

|---|---|---|

article_text |

STRING | ANULÁVEL |

category |

STRING | ANULÁVEL |

confidence |

FLUTUAÇÃO | ANULÁVEL |

- Clique em Criar tabela.

A tabela está vazia por enquanto. Na próxima etapa, você vai ler artigos do Cloud Storage, enviar o texto para a classificação da API Natural Language e armazenar o resultado no BigQuery.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 6: classificar dados de notícias e armazenar o resultado no BigQuery

Para realizar as próximas etapas, conecte-se ao Cloud Shell. Se for solicitado, clique em Continuar.

Antes de escrever um script para enviar os dados de notícias para a API Natural Language, você precisa criar uma conta de serviço. Ela será usada para autenticar a API Natural Language e o BigQuery com um script do Python.

- Exporte o ID do projeto como uma variável de ambiente:

- Execute os seguintes comandos para criar uma conta de serviço:

Você já pode enviar os dados de texto para a API Natural Language.

- Escreva um script em Python usando o módulo do Python para Google Cloud.

Você pode fazer o mesmo em qualquer linguagem. Existem muitas bibliotecas de clientes de nuvem.

- Crie um arquivo chamado

classify-text.pye copie o código a seguir nele. É possível criar o arquivo usando um dos seus editores de linha de comando preferenciais (nano, vim, emacs).

Você já pode classificar artigos e importá-los para o BigQuery.

- Execute o script a seguir:

O script leva cerca de dois minutos para ser concluído. Enquanto ele está em execução, vamos discutir o que está acontecendo.

Você está usando a biblioteca de cliente do Python para Google Cloud a fim de acessar o Cloud Storage, a API Natural Language e o BigQuery. Primeiro, um cliente é criado para cada serviço. Em seguida, são criadas referências para a tabela do BigQuery. O código files é uma referência para cada um dos arquivos do conjunto de dados da BBC no bucket público. Os arquivos são analisados, é feito o download dos artigos como strings e cada um deles é enviado à API Natural Language na função classify_text. Os artigos em que a API Natural Language retorna uma categoria são salvos em uma lista rows_for_bq com os respectivos dados de categoria. Depois de classificar cada artigo, os dados são inseridos no BigQuery usando insert_rows().

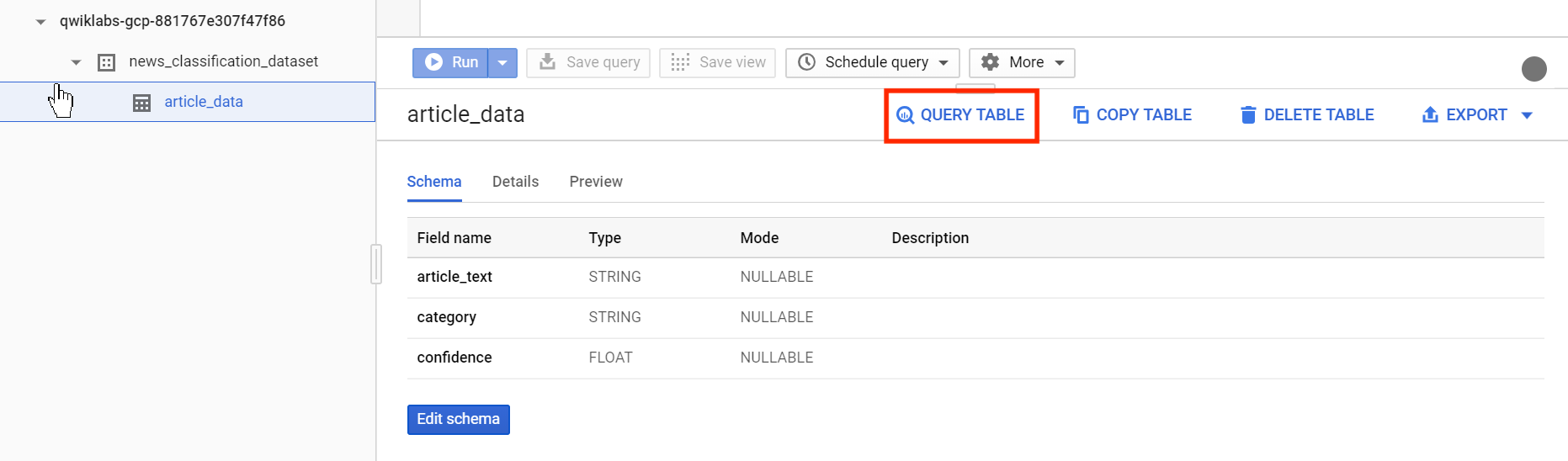

Quando a execução do script terminar, verifique se os dados do artigo foram salvos no BigQuery.

- No BigQuery, acesse a tabela

article_datana guia "Explorer" e clique em Consulta > Em uma nova guia para consultá-la:

- Edite os resultados na caixa Consulta não salva adicionando um asterisco entre SELECT e FROM:

- Clique em Executar.

Os dados serão exibidos quando a consulta for concluída.

- Role para a direita para acessar a coluna da categoria.

A coluna "category" tem o nome da primeira categoria que a API Natural Language retornou para o artigo. Além disso, confidence é um valor entre 0 e 1 que indica o grau de confiança da API na categorização correta do artigo.

Na próxima etapa, você vai aprender a realizar consultas mais complexas nos dados.

Tarefa 7: analisar os dados de notícias categorizados no BigQuery

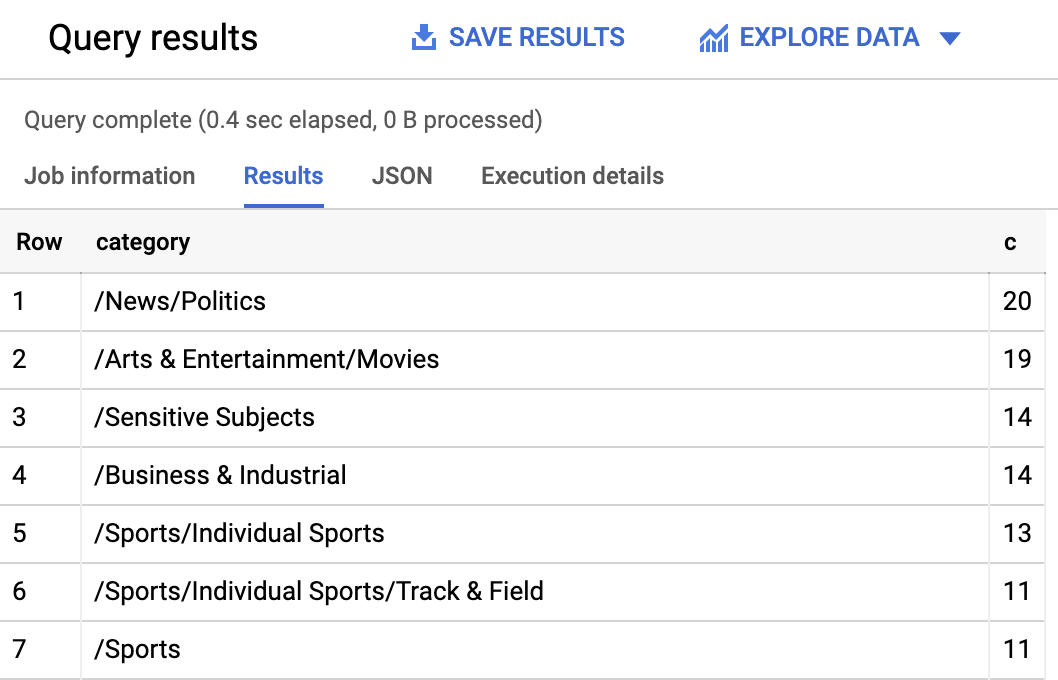

Primeiro confira quais categorias foram mais comuns no conjunto de dados.

-

No console do BigQuery, clique em + Criar consulta.

-

Digite a seguinte consulta:

- Clique em Executar.

Os resultados da consulta devem ser parecidos com estes:

Se você quiser encontrar o artigo classificado em uma categoria mais obscura como /Arts & Entertainment/Music & Audio/Classical Music, é possível usar a seguinte consulta:

Ou você pode exibir apenas os artigos que tiveram um índice de confiança maior que 90% retornado pela API Natural Language:

Para realizar mais consultas nos dados, confira a documentação do BigQuery. O BigQuery também se integra a várias ferramentas de visualização. Para criar visualizações com os dados de notícias categorizados, confira o Guia de início rápido do Data Studio para BigQuery.

Parabéns!

Você aprendeu a usar o método de classificação de texto da API Natural Language para classificar artigos de notícias. Você começou classificando um artigo e, em seguida, aprendeu a classificar e analisar um grande conjunto de dados de notícias usando a API NL com o BigQuery.

Conteúdo abordado

- Como criar uma solicitação

classifyTextda API Natural Language e chamar a API comcurl - Como usar o módulo do Python no Google Cloud para analisar um grande conjunto de dados de notícias

- Como importar e analisar dados no BigQuery

Termine a Quest

Este laboratório autoguiado faz parte das Quests Machine Learning APIs, Data Engineering e Language, Speech, Text, & Translation with Google Cloud APIs. Uma Quest é uma série de laboratórios relacionados que formam um programa de aprendizado. Ao concluir uma Quest, você ganha um selo como reconhecimento da sua conquista. É possível publicar os selos e incluir um link para eles no seu currículo on-line ou nas redes sociais. Inscreva-se em qualquer Quest que tenha este laboratório para receber os créditos de conclusão na mesma hora. Confira o catálogo do Google Cloud Ensina para conferir todas as Quests disponíveis.

Comece o próximo laboratório

Faça o laboratório Prever compras de visitantes com um modelo de classificação no BQML para continuar a Quest ou confira uma destas sugestões:

Próximas etapas / Saiba mais

- Confira os documentos sobre a classificação de conteúdos com a API Natural Language.

- Consulte a documentação do BigQuery para saber mais.

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 20 de setembro de 2023

Laboratório testado em 13 de outubro de 2023

Copyright 2024 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.