Checkpoints

Create a dataset

/ 25

Load Data to BigQuery Tables

/ 25

Explore and Investigate the Data with BigQuery

/ 10

Prepare Your Data

/ 10

Train an Unsupervised Model to Detect Anomalies

/ 10

Train a Supervised Machine Learning Model

/ 10

Predict Fraudulent Transactions on Test Data

/ 10

Detecção de fraudes em transações financeiras com o machine learning no Google Cloud

- GSP774

- Visão geral

- Configuração e requisitos

- Tarefa 1: baixar o arquivo de dados do laboratório

- Tarefa 2: copiar o conjunto de dados para o Cloud Storage

- Tarefa 3: carregar dados em tabelas do BigQuery

- Tarefa 4: explorar e investigar os dados com o BigQuery

- Tarefa 5: preparar os dados

- Tarefa 6: treinar um modelo não supervisionado para detectar anomalias

- Tarefa 7: treinar um modelo supervisionado de machine learning

- Tarefa 8: aprimorar o modelo

- Tarefa 9: avaliar os modelos supervisionados de machine learning

- Tarefa 10: prever transações fraudulentas em dados de teste

- Parabéns!

GSP774

Visão geral

Neste laboratório, você vai analisar fraudes em dados de transações financeiras e aplicar técnicas de engenharia de atributos e machine learning para detectar atividades fraudulentas usando o BigQuery ML.

Serão utilizados dados de transações financeiras públicas. Os dados contêm as seguintes colunas:

- Tipo da transação

- Valor transferido

- ID da conta de origem e de destino

- Saldos novos e antigos

- Tempo relativo da transação (número de horas desde o início do período de 30 dias)

- Flag

isfraud

A coluna de destino isfraud inclui os rótulos das transações fraudulentas. Com esses rótulos, você vai você treinar modelos supervisionados para detecção de fraudes e aplicar modelos não supervisionados para detecção de anomalias.

The data for this lab is from the Kaggle site. If you do not have a Kaggle account, it's free to create one.

Você vai aprender o seguinte:

- Carregar dados no BigQuery e explorá-los.

- Criar novos atributos no BigQuery.

- Criar um modelo não supervisionado para detecção de anomalias.

- Criar modelos supervisionados (com regressão logística e árvore otimizada) para detecção de fraudes.

- Avaliar e comparar os modelos e selecionar o mais adequado.

- Usar o modelo selecionado para prever a probabilidade de fraude nos dados de teste.

Neste laboratório, você vai usar a interface do BigQuery para engenharia de atributos, desenvolvimento de modelos, avaliação e previsão.

Participants that prefer Notebooks as the model development interface may choose to build models in AI Platform Notebooks instead of BigQuery ML. Then at the end of the lab, you can also complete the optional section. You can import open source libraries and create custom models or you can call BigQuery ML models within Notebooks using BigQuery magic commands.

If you want to train models in an automated way without any coding, you can use Google Cloud AutoML which builds models using state-of-the-art algorithms. The training process for AutoML would take almost 2 hours, that's why it is recommended to initiate it at the beginning of the lab, as soon as the data is prepared, so that you can see the results at the end. Check for the "Attention" phrase at the end of the data preparation step.

Configuração e requisitos

Antes de clicar no botão Start Lab

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é iniciado quando você clica em Começar o laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

- Tempo para concluir o laboratório---não se esqueça: depois de começar, não será possível pausar o laboratório.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar, você verá um pop-up para selecionar a forma de pagamento. No painel Detalhes do laboratório à esquerda, você vai encontrar o seguinte:

- O botão Abrir console do Google Cloud

- O tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações, se forem necessárias

-

Se você estiver usando o navegador Chrome, clique em Abrir console do Google Cloud ou clique com o botão direito do mouse e selecione Abrir link em uma janela anônima.

O laboratório ativa os recursos e depois abre a página Fazer login em outra guia.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta. -

Se necessário, copie o Nome de usuário abaixo e cole na caixa de diálogo Fazer login.

{{{user_0.username | "Nome de usuário"}}} Você também encontra o Nome de usuário no painel Detalhes do laboratório.

-

Clique em Seguinte.

-

Copie a Senha abaixo e cole na caixa de diálogo de boas-vindas.

{{{user_0.password | "Senha"}}} Você também encontra a Senha no painel Detalhes do laboratório.

-

Clique em Seguinte.

Importante: você precisa usar as credenciais fornecidas no laboratório, e não as da sua conta do Google Cloud. Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais. -

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do Google Cloud será aberto nesta guia.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

- Clique em Ativar o Cloud Shell

na parte de cima do console do Google Cloud.

Depois de se conectar, vai notar que sua conta já está autenticada, e que o projeto está configurado com seu PROJECT_ID. A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

-

Clique em Autorizar.

-

A saída será parecida com esta:

Saída:

- (Opcional) É possível listar o ID do projeto usando este comando:

Saída:

Exemplo de saída:

gcloud, acesse o guia com informações gerais sobre a gcloud CLI no Google Cloud.

Tarefa 1: baixar o arquivo de dados do laboratório

- Execute o seguinte comando para baixar o arquivo de dados no projeto:

- Se for solicitado, clique em Autorizar.

- Depois do upload do arquivo ZIP, execute o comando

unzip:

Perceba que um arquivo foi aumentado.

- Para facilitar a consulta posterior a esse arquivo, crie uma variável de ambiente para o nome dele:

- Execute o seguinte comando para encontrar o ID do projeto do laboratório e copie esse ID:

- Crie uma variável de ambiente para o ID do projeto copiado e substitua <project_id> por ele:

- Execute o seguinte comando no Cloud Shell para criar um conjunto de dados do BigQuery chamado

financea fim de armazenar as tabelas e os modelos deste laboratório:

A execução bem-sucedida do comando acima resulta nesta saída:

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 2: copiar o conjunto de dados para o Cloud Storage

- Execute o seguinte comando para criar um bucket do Cloud Storage usando o ID de projeto exclusivo como nome:

- Copie o arquivo CSV para o bucket recém-criado:

Tarefa 3: carregar dados em tabelas do BigQuery

Para carregar dados no BigQuery, use a interface do usuário do BigQuery ou o terminal de comando no Cloud Shell. Escolha uma das opções abaixo para carregar os dados.

Opção 1: linha de comando

- Carregue os dados na tabela

finance.fraud_dataexecutando o seguinte comando:

A opção --autodetect lê de modo automático o esquema da tabela (nomes de variáveis, tipos etc.).

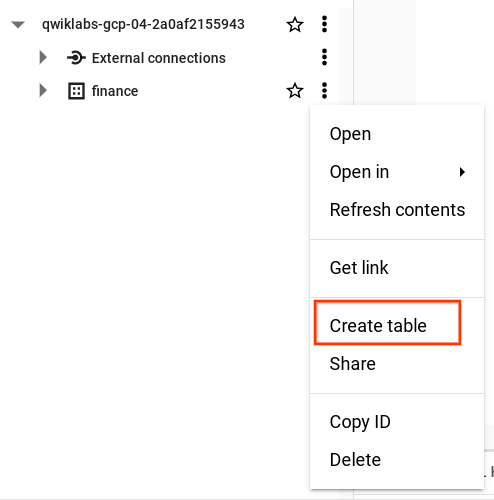

Opção 2: interface do usuário do BigQuery

É possível carregar dados do bucket do Cloud Storage abrindo o BigQuery no console do Cloud.

- Clique no nó “Expandir” próximo ao ID do projeto na seção “Explorador”.

- Clique em Conferir ações ao lado do conjunto de dados finance e pressione Criar tabela.

-

Na janela pop-up “Criar tabela”, defina

Sourcecomo Google Cloud Storage e selecione o arquivo CSV bruto no bucket do Cloud Storage. -

Insira o nome da tabela como fraud_data e selecione a opção Detecção automática em “Esquema” para que os nomes das variáveis sejam lidos de modo automático na primeira linha do arquivo bruto.

-

Selecione Criar tabela.

O processo de carregamento pode levar um ou dois minutos.

- Depois de concluído, na visualização do painel “Explorador” no BigQuery, clique no conjunto de dados finance e encontre a tabela fraud_data para visualizar os metadados e os dados da tabela.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 4: explorar e investigar os dados com o BigQuery

Se você ainda não abriu o BigQuery no console do Cloud, faça isso agora.

- Clique em Menu de navegação > BigQuery.

Em seguida, você vai começar a explorar os dados para entendê-los melhor e prepará-los para modelos de machine learning.

-

Adicione as seguintes consultas ao EDITOR de consultas, clique em EXECUTAR e explore os dados.

-

Clique em COMPOR NOVA CONSULTA para iniciar a próxima consulta. Isso permite a comparação fácil dos resultados após a conclusão.

- Qual é o número de transações fraudulentas em cada tipo de transação?

Procure na coluna isFraud 1 = sim.

- Execute o seguinte comando para conferir a proporção de atividades fraudulentas nos tipos de transação TRANSFER e CASH_OUT (fornece as contagens de

isFraud):

- Execute o seguinte comando para conferir os dez principais valores máximos de transações:

MOMENTO DE REFLEXÃO:

- Você notou algum valor de saldo interessante nas transações? Como fazer uma transação com o saldo da conta de origem zerado? Por que o saldo da conta de destino permanece zerado após a transferência do dinheiro? Esses casos devem ser sinalizados e adicionados como novos atributos na próxima etapa.

- Você acha que os dados estão desequilibrados? Sim. A proporção de transações fraudulentas é muito inferior a 1%? Ao dividir o número de

isfraudpelo número total de observações, você tem como resultado a proporção de transações fraudulentas.

Na próxima seção, você vai aprender a lidar com essas questões e melhorar os dados para modelos de machine learning.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 5: preparar os dados

É possível melhorar os dados de modelagem adicionando novos atributos, filtrando tipos de transações desnecessários e aumentando a proporção da variável de destino isFraud por meio da aplicação da subamostragem.

Com base nas descobertas da fase de análise, você só precisa analisar os tipos de transação "TRANSFER" e "CASH_OUT" e filtrar o restante. Também é possível calcular novas variáveis com base nos valores atuais.

O conjunto de dados contém um destino de fraude extremamente desequilibrado (taxa de fraude nos dados brutos = 0,0013%). Ter eventos raros é comum em fraudes. A fim de tornar o padrão de comportamento fraudulento mais óbvio para os algoritmos de machine learning, além de facilitar a interpretação dos resultados, estratifique os dados e aumente a proporção das flags fraudulentas.

- Na próxima etapa, crie uma nova consulta, adicione o seguinte código para incluir novos atributos nos dados, filtre os tipos de transação desnecessários e selecione um subconjunto das transações não fraudulentas com subamostragem:

-

Execute a consulta.

-

Crie uma tabela de dados TEST selecionando uma amostra aleatória de 20%:

- Execute a consulta.

Esses dados vão ser mantidos separados e não vão ser incluídos no treinamento. Você vai usá-los para pontuar o modelo na fase final.

O BigQuery ML e o AutoML vão particionar os dados do modelo de modo automático como TRAIN e VALIDATE usando os algoritmos de machine learning para testar a taxa de erro nos dados de treinamento e de validação e evitar overfitting.

- Execute o seguinte comando para criar dados de amostra:

Os dados de amostra criados para modelagem contêm aproximadamente 228 mil linhas de transações bancárias.

Também é possível particionar o conjunto de dados de modo manual como TRAIN/VALIDATE e TEST, em especial a fim de comparar modelos de diferentes ambientes, como AutoML ou AI Platform, e ter consistência.

MOMENTO DE REFLEXÃO:

- Como lidar com a ausência de eventos de fraude rotulados nos dados? Se não houver transações rotuladas, use técnicas de modelagem não supervisionada para analisar as anomalias nos dados, como clustering k-means. Na próxima seção, você vai testar esse método.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 6: treinar um modelo não supervisionado para detectar anomalias

Métodos não supervisionados são usados com frequência na detecção de fraudes, a fim de ajudar na exploração de comportamentos anormais nos dados. Eles também são úteis quando não há rótulos de fraude ou a taxa de eventos é muito baixa e o número de ocorrências não permite a criação de um modelo supervisionado.

Nesta seção, você vai usar o algoritmo de clustering k-means para criar segmentos de transações, analisar cada segmento e detectar quais deles têm anomalias.

- Crie uma consulta e execute o seguinte código no BigQuery com CREATE ou REPLACE MODEL e defina model_type como

kmeans:

Isso vai criar um modelo k-means chamado model_unsupervised com cinco clusters que usam as variáveis selecionadas de fraud_data_model.

Depois do treinamento do modelo, ele será exibido em Finanças > Modelos.

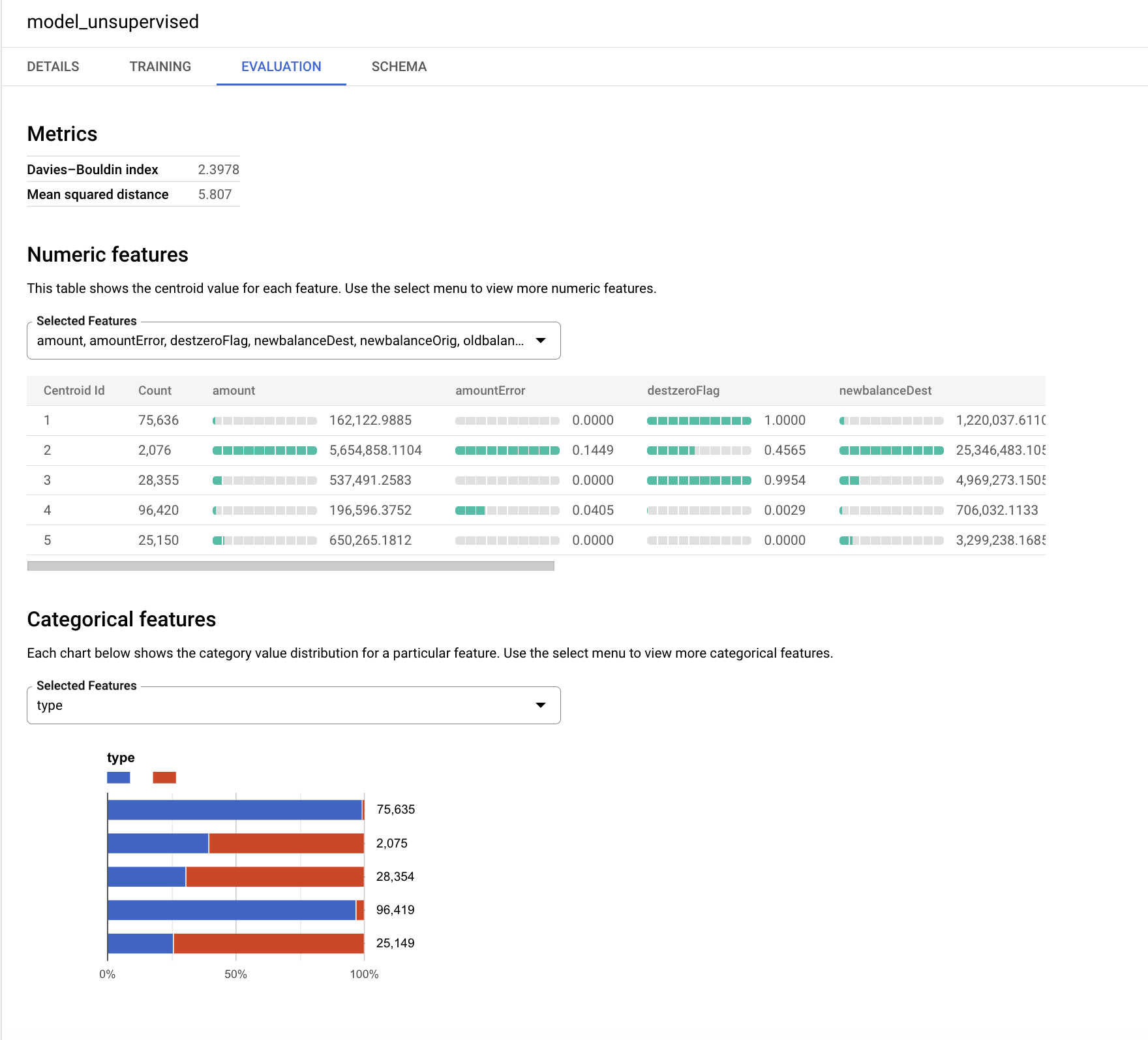

- Clique em model_unsupervised e, em seguida, na guia AVALIAÇÃO.

O algoritmo k-means cria uma variável de saída chamada centroid_id. Cada transação recebe um centroid_id. As transações semelhantes/mais próximas umas das outras são atribuídas ao mesmo cluster pelo algoritmo.

O índice Davies-Bouldin mostra uma indicação do nível de homogeneidade dos clusters. Quanto menor o valor, mais distantes os clusters estão uns dos outros, o que é o resultado pretendido.

Os atributos numéricos são exibidos com gráficos de barras para cada centroide (cluster) na guia “Avaliação”. Os números próximos às barras mostram o valor médio das variáveis em cada cluster. Como prática recomendada, é possível padronizar ou agrupar as variáveis de entrada em buckets a fim de evitar o impacto de grandes números ou outliers nos cálculos de distância para clustering. Para simplificar, este laboratório usa as variáveis originais do exercício.

As variáveis categóricas usadas como entrada são exibidas de modo separado. É possível conferir a distribuição das transações TRANSFER e CASH_OUT em cada segmento abaixo.

Embora os gráficos possam parecer diferentes para o modelo, concentre-se nos segmentos menores e tente interpretar as distribuições.

A variável de destino isFraud não foi usada neste modelo não supervisionado. Neste exercício, é recomendado manter essa variável para a criação de perfil e utilizá-la ao explorar a distribuição de atividades fraudulentas em cada cluster.

-

Pontue os dados de teste (

fraud_data_test) usando esse modelo e confira o número de eventos de fraude em cadacentroid_id. Os algoritmos de clustering criam grupos homogêneos de observações. Nesta consulta,ML.PREDICTvai chamar o modelo e gerar ocentroid_idpara cada transação nos dados de teste. -

Execute o seguinte código na nova consulta:

MOMENTO DE REFLEXÃO:

- Qual cluster você considera mais interessante? A resposta certa são os clusters pequenos com altos valores de erro.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 7: treinar um modelo supervisionado de machine learning

Agora tudo está pronto para você começar a criar modelos supervisionados usando o BigQuery ML a fim de prever a probabilidade de transações fraudulentas. Comece com um modelo simples: use o BigQuery ML para criar um modelo de regressão logística binária voltado à classificação. Esse modelo vai tentar prever se a transação provavelmente é fraudulenta ou não.

Para todas as variáveis não numéricas (categóricas), o BigQuery ML executa de modo automático uma transformação de codificação one-hot. Essa transformação gera um atributo separado para cada valor único na variável. Neste exercício, a codificação one-hot será executada de modo automático pelo BigQuery ML para a variável TYPE.

- Para criar seu primeiro modelo supervisionado, execute a seguinte instrução SQL no BigQuery:

Quando tudo estiver pronto, a tabela model_supervised_initial será adicionada em Finanças > Modelos.

Depois que o modelo for criado, será possível acessar os metadados, o treinamento e as estatísticas de avaliação do modelo na interface do console do BigQuery.

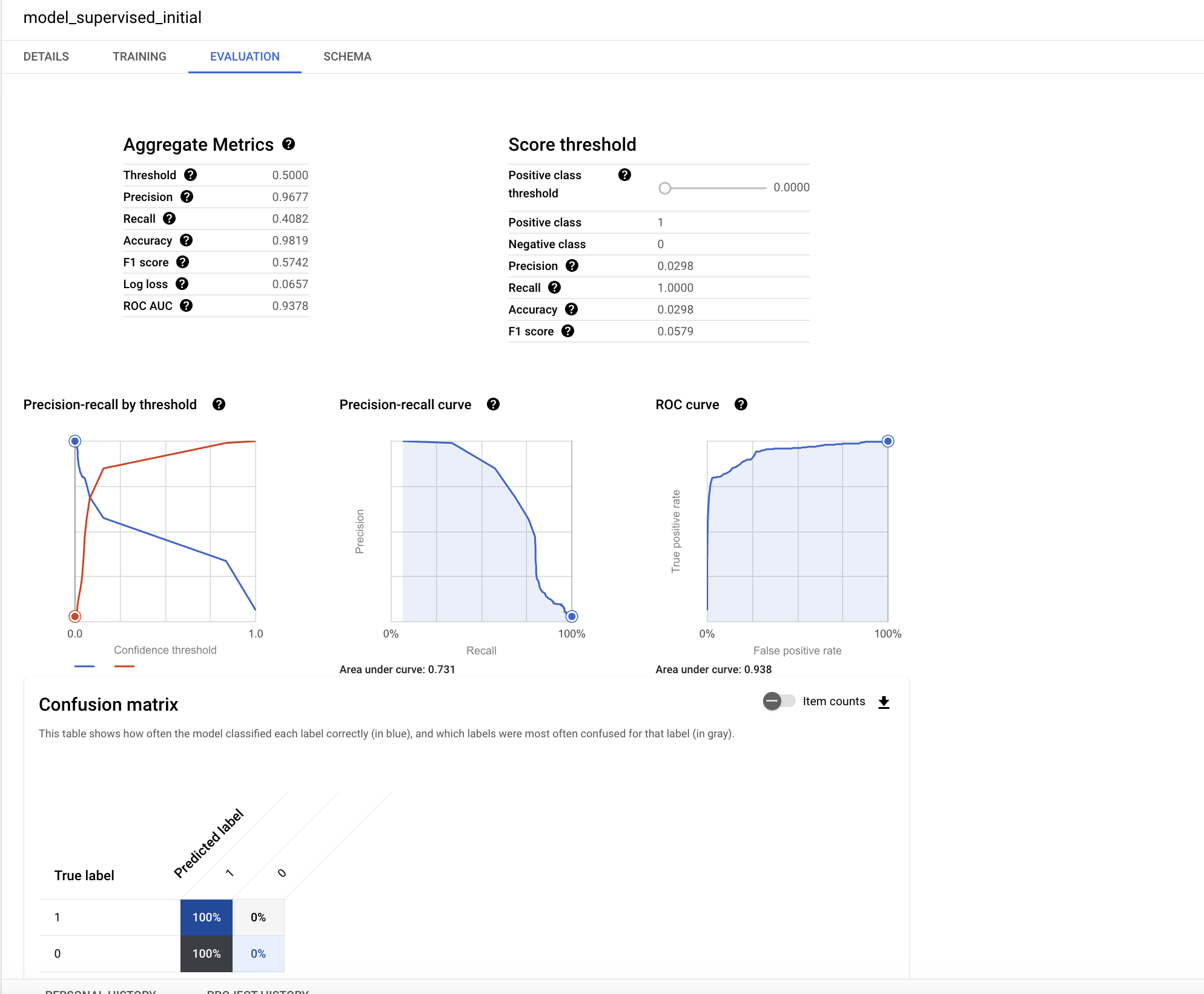

- Clique em model_supervised_initial no painel esquerdo e, depois, na guia Detalhes, Treinamento, Avaliação ou Esquema para saber mais.

Na guia Avaliação, é possível encontrar várias métricas de desempenho específicas do modelo de classificação.

Compreender o desempenho do modelo é um tópico importante no machine learning. Como você executou uma regressão logística para classificação, é útil entender os seguintes conceitos importantes:

- precisão: a precisão identifica a proporção de casos positivos selecionados em que o modelo estava correto.

- recall: uma métrica que responde à pergunta “de todos os rótulos reais positivos possíveis, quantos o modelo identificou corretamente?”.

- acurácia: a acurácia é a proporção geral de previsões corretas.

- pontuação F1: uma medida da acurácia do modelo. A pontuação f1 é a média harmônica da precisão e do recall, assumindo valores de 0 a 1, em que quanto maior melhor.

- ROC AUC: a área sob a curva ROC. Fornece informações sobre a capacidade de discriminação de um classificador binário considerando diferentes limites, assumindo valores entre 0 e 1, em que quanto maior melhor. Para um modelo moderado, a expectativa seria ter um valor de ROC superior a 0,7.

O gráfico nesta página da Wikipédia explica muito bem os conceitos de precisão e recall.

O valor de ROC para este modelo de regressão é muito alto. É possível compreender melhor a acurácia testando os resultados com relação a diferentes limites de probabilidade.

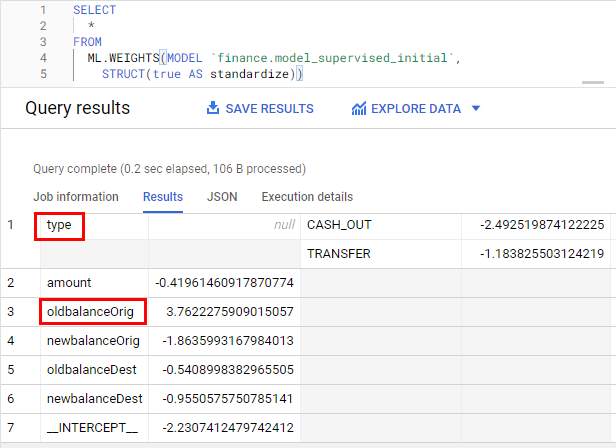

Agora, observe os atributos mais influentes do modelo.

- Execute a seguinte consulta para verificar a importância do atributo:

Os pesos são padronizados para eliminar o impacto da escala das variáveis por meio da opção Padronizar. Os pesos maiores são os mais importantes. O sinal do peso indica a direção, dependendo da relação direta ou inversa com o destino.

MOMENTO DE REFLEXÃO:

- Quais duas variáveis parecem ser as mais importantes?

oldbalanceOrigetypesão as variáveis mais importantes.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 8: aprimorar o modelo

Agora é hora de um exercício divertido: crie um modelo e treine os dois modelos para conseguir uma acurácia melhor.

- Crie um modelo de otimização de gradiente executando o seguinte comando:

A seguir, compare os dois modelos que você criou e escolha o melhor.

Tarefa 9: avaliar os modelos supervisionados de machine learning

Melhore o modelo de regressão logística atual adicionando novas variáveis.

Depois de criar o modelo, será possível avaliar o desempenho do classificador usando a função ML.EVALUATE. A função ML.EVALUATE avalia o resultado ou os valores previstos em relação aos dados reais.

- Execute as consultas a seguir para anexar os resultados dos dois modelos em uma única tabela e escolha o modelo mais adequado para uso ao pontuar novos dados.

MOMENTO DE REFLEXÃO:

- Qual modelo apresentou o melhor desempenho? No início, você executou um modelo de regressão. Em seguida, você adicionou mais variáveis e treinou um novo modelo usando a regressão (o modelo supervisionado). Por fim, você usou uma árvore otimizada como o segundo modelo supervisionado. Ao comparar as tabelas de desempenho, o modelo de árvore otimizada apresenta um desempenho melhor. A adição de novos atributos adicionais melhorou a acurácia do modelo.

Tarefa 10: prever transações fraudulentas em dados de teste

A última etapa do machine learning é usar o modelo mais adequado para prever a saída em novos conjuntos de dados.

Os algoritmos de machine learning no BQML criam uma variável aninhada chamada predicted_<target_name\>_probs. Essa variável inclui as pontuações de probabilidade para a decisão do modelo. A decisão do modelo é relacionada a transações fraudulentas ou genuínas.

- Execute a consulta a seguir no BigQuery para conferir a previsão de transações fraudulentas nos dados de teste criados no início do laboratório. A instrução WHERE abaixo vai fornecer as transações com as maiores pontuações de probabilidade:

MOMENTO DE REFLEXÃO:

- Qual é a proporção de atividades fraudulentas no conjunto de transações previsto? Menos de 3%.

- Quanto a taxa de eventos aumentou no conjunto de linhas previsto em comparação com os dados de teste gerais? Mais de 95%.

Clique em Verificar meu progresso para conferir o objetivo.

Parabéns!

Próximas etapas

- Saiba mais sobre o machine learning no Google Developers Crash Course.

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 12 de outubro de 2023

Laboratório testado em 12 de outubro de 2023

Copyright 2024 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.