チェックポイント

Create an API Key

/ 30

Upload image to a bucket

/ 30

Analyzing the image's text with the Natural Language API

/ 40

Cloud ML API を使用して画像内のテキストの抽出、分析、翻訳を行う

GSP075

概要

このラボでは、複数の ML API を組み合わせて使用し、ML によってできることを体験します。最初に Cloud Vision API のテキスト検出メソッドを使用し、光学式文字認識(OCR)を利用して画像からテキストを抽出します。次に、そのテキストを Translation API で翻訳する方法と、Natural Language API で分析する方法を学びます。

学習内容

- Vision API リクエストを作成し、curl で API を呼び出す

- Vision API のテキスト検出(OCR)メソッドを使用する

- Translation API を使用して画像から抽出したテキストを翻訳する

- Natural Language API を使用してテキストを分析する

設定と要件

[ラボを開始] ボタンをクリックする前に

こちらの手順をお読みください。ラボの時間は記録されており、一時停止することはできません。[ラボを開始] をクリックするとスタートするタイマーは、Google Cloud のリソースを利用できる時間を示しています。

このハンズオンラボでは、シミュレーションやデモ環境ではなく、実際のクラウド環境を使ってご自身でラボのアクティビティを行うことができます。そのため、ラボの受講中に Google Cloud にログインおよびアクセスするための、新しい一時的な認証情報が提供されます。

このラボを完了するためには、下記が必要です。

- 標準的なインターネット ブラウザ(Chrome を推奨)

- ラボを完了するために十分な時間を確保してください。ラボをいったん開始すると一時停止することはできません。

ラボを開始して Google Cloud コンソールにログインする方法

-

[ラボを開始] ボタンをクリックします。ラボの料金をお支払いいただく必要がある場合は、表示されるポップアップでお支払い方法を選択してください。 左側の [ラボの詳細] パネルには、以下が表示されます。

- [Google Cloud コンソールを開く] ボタン

- 残り時間

- このラボで使用する必要がある一時的な認証情報

- このラボを行うために必要なその他の情報(ある場合)

-

[Google Cloud コンソールを開く] をクリックします(Chrome ブラウザを使用している場合は、右クリックして [シークレット ウィンドウでリンクを開く] を選択します)。

ラボでリソースが起動し、別のタブで [ログイン] ページが表示されます。

ヒント: タブをそれぞれ別のウィンドウで開き、並べて表示しておきましょう。

注: [アカウントの選択] ダイアログが表示されたら、[別のアカウントを使用] をクリックします。 -

必要に応じて、下のユーザー名をコピーして、[ログイン] ダイアログに貼り付けます。

{{{user_0.username | "Username"}}} [ラボの詳細] パネルでも [ユーザー名] を確認できます。

-

[次へ] をクリックします。

-

以下のパスワードをコピーして、[ようこそ] ダイアログに貼り付けます。

{{{user_0.password | "Password"}}} [ラボの詳細] パネルでも [パスワード] を確認できます。

-

[次へ] をクリックします。

重要: ラボで提供された認証情報を使用する必要があります。Google Cloud アカウントの認証情報は使用しないでください。 注: このラボでご自身の Google Cloud アカウントを使用すると、追加料金が発生する場合があります。 -

その後次のように進みます。

- 利用規約に同意してください。

- 一時的なアカウントなので、復元オプションや 2 要素認証プロセスは設定しないでください。

- 無料トライアルには登録しないでください。

その後、このタブで Google Cloud コンソールが開きます。

Cloud Shell をアクティブにする

Cloud Shell は、開発ツールと一緒に読み込まれる仮想マシンです。5 GB の永続ホーム ディレクトリが用意されており、Google Cloud で稼働します。Cloud Shell を使用すると、コマンドラインで Google Cloud リソースにアクセスできます。

- Google Cloud コンソールの上部にある「Cloud Shell をアクティブにする」アイコン

をクリックします。

接続した時点で認証が完了しており、プロジェクトに各自の PROJECT_ID が設定されます。出力には、このセッションの PROJECT_ID を宣言する次の行が含まれています。

gcloud は Google Cloud のコマンドライン ツールです。このツールは、Cloud Shell にプリインストールされており、タブ補完がサポートされています。

- (省略可)次のコマンドを使用すると、有効なアカウント名を一覧表示できます。

-

[承認] をクリックします。

-

出力は次のようになります。

出力:

- (省略可)次のコマンドを使用すると、プロジェクト ID を一覧表示できます。

出力:

出力例:

gcloud ドキュメントの全文については、gcloud CLI の概要ガイドをご覧ください。

タスク 1. API キーを作成する

curl を使用して Vision API にリクエストを送信するため、リクエスト URL に渡す API キーを生成する必要があります。

- API キーを作成するには、ナビゲーション メニュー > [API とサービス] > [認証情報] の順に移動します。

-

[+ 認証情報を作成] をクリックします。

-

プルダウン メニューで [API キー] を選択します。

-

次に、生成したキーをコピーして [閉じる] をクリックします。

-

各リクエストに API キーの値を挿入する必要がないように、環境変数に API キーを保存します。

-

Cloud Shell で次のコマンドを実行します。

<your_api_key>は先ほどコピーしたキーに置き換えます。

[進行状況を確認] をクリックして、実行したタスクを確認します。

タスク 2. Cloud Storage バケットに画像をアップロードする

Cloud Storage バケットを作成する

画像検出のために Vision API に画像を送信する方法は 2 つあります。base64 でエンコードされた画像文字列を API に送信する方法と、Cloud Storage に保存されたファイルの URL を渡す方法です。このラボでは、Cloud Storage バケットを作成して画像を保存します。

-

コンソールでナビゲーション メニュー > [Cloud Storage] ブラウザの順に移動し、[+ 作成] をクリックします。

-

バケットに

- バケットという一意の名前を付けます。 -

バケットに名前を付けたら、[オブジェクトへのアクセスを制御する方法を選択する] をクリックします。

-

[このバケットに対する公開アクセス禁止を適用する] のボックスの選択を解除します。

-

[アクセス制御] の下の [きめ細かい管理] を選択して [作成] をクリックします。

バケットに画像をアップロードする

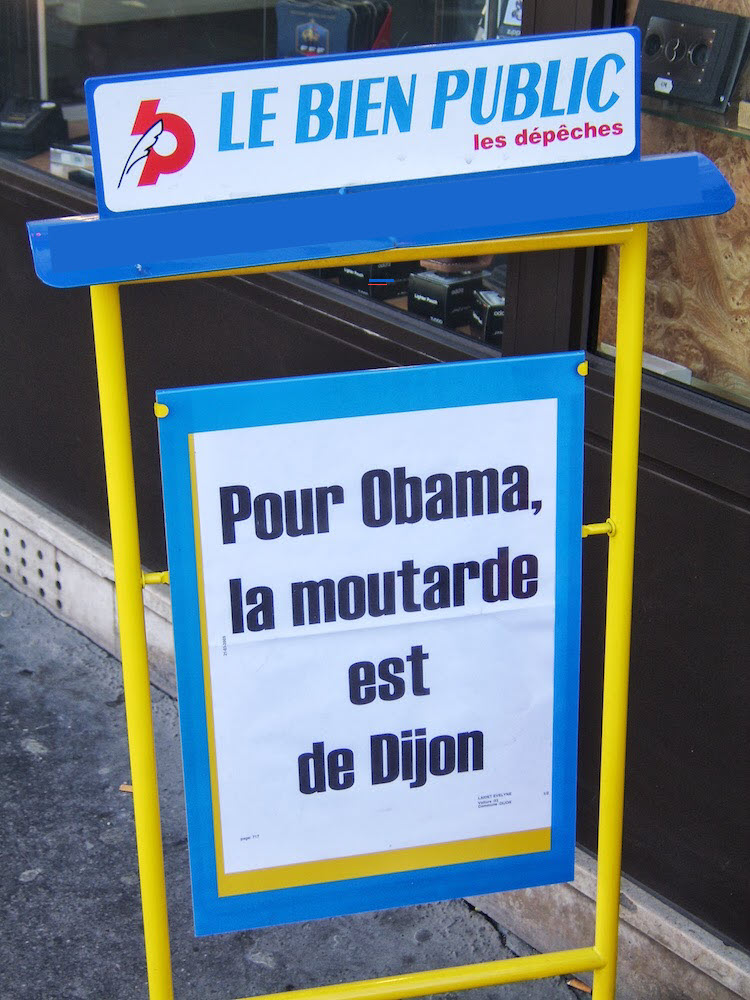

- 下のフランス語の看板の画像を右クリックし、[名前を付けて画像を保存] をクリックして、sign.jpg という名前でパソコンに保存します。

- [Cloud Storage] ブラウザで先ほど作成したバケットに移動し、[ファイルをアップロード] をクリックして sign.jpg を選択します。

次に、バケットへのアクセスを非公開にしたままで、ファイルを公開して表示できるようにします。

- 画像ファイルのその他アイコンをクリックします。

-

[アクセス権の編集] を選択します。

-

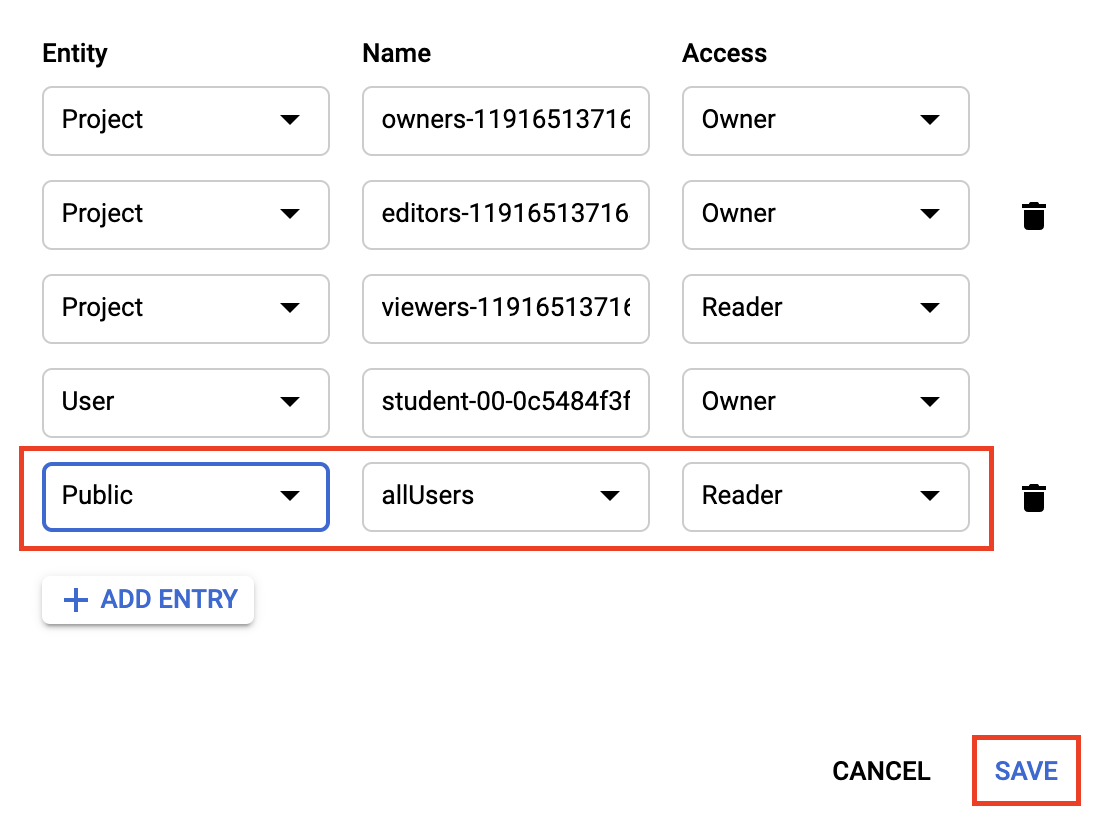

[エントリを追加] をクリックして、次のように設定します。

- [エンティティ] には [Public] を選択します。

- 名前の値が [allUsers] であることを確認します。

- アクセスには [Reader] を選択します。

- [保存] をクリックします。

ファイルに公開アクセス権が設定されます。

これで、ファイルをバケットに保存できました。次は Vision API リクエストを作成し、この画像の URL を渡します。

[進行状況を確認] をクリックして、実行したタスクを確認します。

タスク 3. Cloud Vision API リクエストを作成する

- Cloud Shell 環境で

ocr-request.jsonファイルを作成した後、以下のコードをそのファイルに追加します。my-bucket-name は、作成したバケットの名前に置き換えます。ファイルを作成するには、任意のコマンドライン エディタ(nano、vim、emacs)を使用するか、または Cloud Shell で鉛筆アイコンをクリックしてコードエディタを開きます。

-

ocr-request.jsonファイルに次の行を追加します。

この後、Cloud Vision API の TEXT_DETECTION 機能を使用します。この機能は、画像に対して光学式文字認識(OCR)を実行してテキストを抽出します。

タスク 4. テキスト検出メソッドを呼び出す

- Cloud Shell で、

curlを使用して Cloud Vision API を呼び出します。

レスポンスの最初の部分は次のようになります。

OCR メソッドにより、画像から多くのテキストを抽出できます。

textAnnotations で取り出された最初のデータは、API が画像内で見つけたテキストのブロック全体です。これには次のものが含まれます。

- 言語コード(このケースではフランス語)

- テキストの文字列

- 画像内でテキストが見つかった場所を示す境界ボックス

その下には、テキスト内で見つかった単語それぞれについてのオブジェクトが、該当の単語の境界ボックスも含めて示されます。

フランス語を知らなければ、このテキストの意味はおそらくわかりません。次のステップは翻訳です。

- 次の

curlコマンドを実行してレスポンスをocr-response.jsonファイルに保存し、後で参照できるようにします。

タスク 5. 画像から抽出したテキストを Translation API に送信する

Translation API では、テキストを 100 以上の言語に翻訳できます。入力テキストの言語を検出することもできます。フランス語のテキストを英語に翻訳するには、テキストとターゲット言語の言語コード(en-US)を Translation API に渡します。

- まず、

translation-request.jsonファイルを作成して、次の行を追加します。

q は翻訳する文字列を渡す場所です。

-

ファイルを保存します。

-

Cloud Shell で次の Bash コマンドを実行し、前の手順で説明した画像テキストを抽出して、新しい

translation-request.jsonにコピーします(これらはすべて 1 つのコマンドで行われます)。

- これで、Translation API を呼び出す準備が整いました。次のコマンドを実行すると、レスポンスが

translation-response.jsonファイルにコピーされます。

- このファイルで Translation API のレスポンスを確認するには、次のコマンドを実行します。

看板の内容が理解しやすくなりました。

レスポンスの説明:

-

translatedTextには翻訳結果が含まれ、 -

detectedSourceLanguageはfr、つまりフランス語の ISO 言語コードです。

Translation API は 100 以上の言語をサポートし、言語サポートのリファレンスでその一覧が示されています。

画像に含まれるテキストを翻訳するだけでなく、詳細に分析したい場合があります。そのような場合は、Natural Language API が役に立ちます。次のステップに進みましょう。

タスク 6. Natural Language API を使用して画像のテキストを分析する

Natural Language API は、エンティティを抽出して感情と構文を分析し、テキストをカテゴリ別に分類することによって、テキストの理解を助けます。analyzeEntities メソッドを使用して、Natural Language API がこの画像のテキストにどのようなエンティティを見つけられるかを見てみましょう。

- API リクエストを設定するために、次のような

nl-request.jsonファイルを作成します。

リクエストでは、送信するテキストについて次の情報を Natural Language API に知らせます。

-

type: サポートされている型の値は

PLAIN_TEXTまたはHTMLです。 -

content: 分析のために Natural Language API に送信するテキストを渡します。Natural Language API では、Cloud Storage に保存されているファイルをテキスト処理用に送信することもできます。Cloud Storage からファイルを送信するには、

contentをgcsContentUriに置き換えて、Cloud Storage に保存されているテキスト ファイルの URI の値を使用します。 -

encodingType: テキストを処理するときに使用するテキスト エンコードの種類を API に指示します。API はこの情報により、特定のエンティティがテキストのどこに出現するかを調べます。

- Cloud Shell で次の Bash コマンドを実行し、翻訳されたテキストを Natural Language API リクエストの content ブロックにコピーします。

nl-request.json ファイルに、元の画像から翻訳された英語のテキストが含まれるようになりました。いよいよこのテキストを分析します。

- 次の

curlリクエストを使用して、Natural Language API のanalyzeEntitiesエンドポイントを呼び出します。

レスポンス全体をスクロールすると、Natural Language API によって発見されたエンティティを参照できます。

wikipedia のページを含むエンティティの場合、API はそのページの URL を含むメタデータとエンティティの mid を提供します。mid とは、Google のナレッジグラフでこのエンティティにマッピングされる ID です。詳細情報を取得するには、Knowledge Graph API を呼び出してこの ID を渡します。Natural Language API はすべてのエンティティについて、mentions(テキスト内の出現箇所)、type(タイプ)、および salience(テキスト全体におけるエンティティの重要性を示す [0,1] の範囲)の情報を提供します。Natural Language API では英語以外に言語サポート リファレンスの一覧にある言語もサポートされています。

この画像に限れば重要なエンティティを見つけ出すのは比較的簡単ですが、数千に及ぶ画像のライブラリがある場合、その作業は非常に困難になります。OCR、翻訳、および自然言語処理は、大量の画像データセットから意味を抽出するのに役立ちます。

[進行状況を確認] をクリックして、実行したタスクを確認します。

お疲れさまでした

ここでは、3 つの異なる ML API を組み合わせる方法を学びました。すなわち、Vision API の OCR メソッドで画像からテキストを抽出し、Translation API でそのテキストを英語に翻訳して、Natural Language API でそのテキスト内のエンティティを検出しました。

学習した内容

- 複数の ML API を組み合わせたユースケース

- Vision API の OCR リクエストを作成し、curl で API を呼び出す方法

- Translation API でテキストを翻訳する方法

- Natural Language API を使用してテキストからエンティティを抽出する方法

クエストを完了する

このセルフペース ラボは、「Integrate with Machine Learning APIs」クエストと「Intro to ML: Image Processing」クエストの一部です。クエストとは学習プログラムを構成する一連のラボのことで、完了すると成果が認められて上のようなバッジが贈られます。バッジは公開して、オンライン レジュメやソーシャル メディア アカウントにリンクできます。このラボの修了後、このラボが含まれるクエストに登録すれば、すぐにクレジットを受け取ることができます。受講可能な全クエストについては、Google Cloud Skills Boost カタログをご覧ください。

次のラボを受講する

ML API に関する別のラボをお試しください。たとえば、次のようなものがあります。

次のステップと詳細情報

- Vision、Translation、Natural Language のチュートリアルとドキュメントでさらに学習する

Google Cloud トレーニングと認定資格

Google Cloud トレーニングと認定資格を通して、Google Cloud 技術を最大限に活用できるようになります。必要な技術スキルとベスト プラクティスについて取り扱うクラスでは、学習を継続的に進めることができます。トレーニングは基礎レベルから上級レベルまであり、オンデマンド、ライブ、バーチャル参加など、多忙なスケジュールにも対応できるオプションが用意されています。認定資格を取得することで、Google Cloud テクノロジーに関するスキルと知識を証明できます。

マニュアルの最終更新日: 2023 年 10 月 6 日

ラボの最終テスト日: 2023 年 10 月 6 日

Copyright 2024 Google LLC All rights reserved. Google および Google のロゴは Google LLC の商標です。その他すべての企業名および商品名はそれぞれ各社の商標または登録商標です。

![ナビゲーション メニューを開いて [API とサービス] サブメニューと [認証情報] オプションがハイライト表示されている](https://cdn.qwiklabs.com/%2BP6jLoRF1%2F5zohA4QDir1sG9WKEZPoya7uwopH2Kk00%3D)

![プルダウン メニューで [API キー] オプションがハイライト表示されている](https://cdn.qwiklabs.com/cO1%2Fe9TXIdPC4AxJ6eSqF6%2BoOe3NrKJQXYFmANbI0wE%3D)

![[オブジェクト] タブに看板の画像ファイルがアップロードされ、その他のオプションのボタンがハイライト表示されている](https://cdn.qwiklabs.com/YFK8BqfjPUAl%2FTi8G4c6dsRlDY8IKmGch%2F3yDiRMNoY%3D)

![鉛筆アイコンが表示されている [エディタを開く] ボタン](https://cdn.qwiklabs.com/Th5i4GhZ4KZmFOQ9NWdNmyDXleSWVH9rxHGBt3ECj3M%3D)