체크포인트

Create an API Key

/ 40

Make an Entity Analysis Request

/ 30

Check the Entity Analysis response

/ 30

Natural Language API를 사용한 항목 및 감정 분석

GSP038

개요

Cloud Natural Language API를 사용하면 텍스트에서 항목을 추출하고 감정 및 구문 분석을 수행하며 텍스트를 카테고리로 분류할 수 있습니다.

이 실습에서는 Natural Language API를 사용해 항목, 감정, 문법을 분석하는 방법을 알아봅니다.

목표

이 실습에서는 다음 작업을 수행하는 방법을 배웁니다.

- Natural Language API 요청 만들기 및 curl로 API 호출

- Natural Language API를 사용하여 텍스트에서 항목 추출하기 및 감정 분석 실행

- Natural Language API를 사용하여 텍스트에서 언어 분석 수행

- 여러 언어로 Natural Language API 요청 만들기

설정 및 요건

실습 시작 버튼을 클릭하기 전에

다음 안내를 확인하세요. 실습에는 시간 제한이 있으며 일시중지할 수 없습니다. 실습 시작을 클릭하면 타이머가 시작됩니다. 이 타이머에는 Google Cloud 리소스를 사용할 수 있는 시간이 얼마나 남았는지 표시됩니다.

실무형 실습을 통해 시뮬레이션이나 데모 환경이 아닌 실제 클라우드 환경에서 직접 실습 활동을 진행할 수 있습니다. 실습 시간 동안 Google Cloud에 로그인하고 액세스하는 데 사용할 수 있는 새로운 임시 사용자 인증 정보가 제공됩니다.

이 실습을 완료하려면 다음을 준비해야 합니다.

- 표준 인터넷 브라우저 액세스 권한(Chrome 브라우저 권장)

- 실습을 완료하기에 충분한 시간---실습을 시작하고 나면 일시중지할 수 없습니다.

실습을 시작하고 Google Cloud 콘솔에 로그인하는 방법

-

실습 시작 버튼을 클릭합니다. 실습 비용을 결제해야 하는 경우 결제 수단을 선택할 수 있는 팝업이 열립니다. 왼쪽에는 다음과 같은 항목이 포함된 실습 세부정보 패널이 있습니다.

- Google Cloud 콘솔 열기 버튼

- 남은 시간

- 이 실습에 사용해야 하는 임시 사용자 인증 정보

- 필요한 경우 실습 진행을 위한 기타 정보

-

Google Cloud 콘솔 열기를 클릭합니다(Chrome 브라우저를 실행 중인 경우 마우스 오른쪽 버튼으로 클릭하고 시크릿 창에서 링크 열기를 선택합니다).

실습에서 리소스가 가동되면 다른 탭이 열리고 로그인 페이지가 표시됩니다.

팁: 두 개의 탭을 각각 별도의 창으로 나란히 정렬하세요.

참고: 계정 선택 대화상자가 표시되면 다른 계정 사용을 클릭합니다. -

필요한 경우 아래의 사용자 이름을 복사하여 로그인 대화상자에 붙여넣습니다.

{{{user_0.username | "Username"}}} 실습 세부정보 패널에서도 사용자 이름을 확인할 수 있습니다.

-

다음을 클릭합니다.

-

아래의 비밀번호를 복사하여 시작하기 대화상자에 붙여넣습니다.

{{{user_0.password | "Password"}}} 실습 세부정보 패널에서도 비밀번호를 확인할 수 있습니다.

-

다음을 클릭합니다.

중요: 실습에서 제공하는 사용자 인증 정보를 사용해야 합니다. Google Cloud 계정 사용자 인증 정보를 사용하지 마세요. 참고: 이 실습에 자신의 Google Cloud 계정을 사용하면 추가 요금이 발생할 수 있습니다. -

이후에 표시되는 페이지를 클릭하여 넘깁니다.

- 이용약관에 동의합니다.

- 임시 계정이므로 복구 옵션이나 2단계 인증을 추가하지 않습니다.

- 무료 체험판을 신청하지 않습니다.

잠시 후 Google Cloud 콘솔이 이 탭에서 열립니다.

작업 1. API 키 만들기

Natural Language API로 요청을 전송하기 위해 curl을 사용하므로, 요청 URL에 전달할 API 키를 만들어야 합니다.

-

API 키를 생성하려면 Cloud 콘솔에서 탐색 메뉴 > API 및 서비스 > 사용자 인증 정보를 선택합니다.

-

사용자 인증 정보 만들기를 클릭한 후 API 키를 선택합니다.

-

생성된 API 키를 복사하고 닫기를 클릭합니다.

내 진행 상황 확인하기를 클릭하여 목표를 확인합니다.

다음 단계를 수행하려면 SSH를 통해 프로비저닝된 인스턴스에 연결합니다.

-

탐색 메뉴 > Compute Engine을 클릭합니다. VM 인스턴스 목록에 프로비저닝된 Linux 인스턴스

linux-instance가 표시됩니다. -

SSH 버튼을 클릭합니다. 대화형 셸로 이동하게 됩니다.

-

명령줄에서 다음을 입력합니다. 이때

<YOUR_API_KEY>를 방금 복사한 키로 대체합니다.

작업 2. 항목 분석 요청 만들기

가장 먼저 사용할 Natural Language API 메서드는 analyzeEntities입니다. 이 메서드를 사용하면 API가 텍스트에서 항목(인물, 장소, 이벤트 등)을 추출할 수 있습니다. API의 항목 분석을 시도해 보려면 다음 문장을 사용하세요.

Joanne Rowling, who writes under the pen names J. K. Rowling and Robert Galbraith, is a British novelist and screenwriter who wrote the Harry Potter fantasy series.

request.json 파일에서 Natural Language API에 대한 요청을 빌드합니다.

- nano(코드 편집기)를 사용하여 다음과 같이

request.json파일을 만듭니다.

- 다음 코드를

request.json에 입력하거나 붙여넣습니다.

- Ctrl+X 키를 눌러 nano를 종료한 다음 Y 키를 눌러 파일을 저장한 후 Enter 키를 눌러 확인합니다.

요청에서는 전송하는 텍스트에 대한 사항을 Natural Language API에 알립니다. 지원되는 유형(type) 값은 PLAIN_TEXT 또는 HTML입니다. 콘텐츠(content)에서는 Natural Language API에 전송하여 분석하려는 텍스트를 전달합니다.

또한 Natural Language API는 Cloud Storage에 저장된 파일을 전송하여 텍스트 처리를 할 수 있도록 지원합니다. Cloud Storage에서 파일을 전송하려면 content를 gcsContentUri로 바꾸고 Cloud Storage의 텍스트 파일로 연결되는 URI 값으로 지정해야 합니다.

encodingType은 API에 텍스트를 처리할 때 사용할 텍스트 인코딩 유형을 알려줍니다. API는 이를 사용하여 특정 항목이 텍스트의 어느 위치에 포함되는지 계산합니다.

내 진행 상황 확인하기를 클릭하여 목표를 확인합니다.

작업 3. Natural Language API 호출

- 이제 아래

curl명령어를 사용하여 이전에 저장한 API 키 환경 변수와 함께 요청 본문을 Natural Language API에 전달할 수 있습니다(하나의 명령줄로 모두 전달).

- 응답을 확인하려면 다음을 실행합니다.

응답의 시작 부분이 다음과 같이 나타납니다.

응답의 각 항목마다 항목의 type, 관련된 Wikipedia의 URL(있는 경우), salience, 텍스트에서 항목이 나타난 위치의 색인이 표시됩니다. Salience는 텍스트 전체에 대한 항목의 중요성을 가리키는 [0,1] 범위의 숫자입니다.

Natural Language API는 다른 방식으로 언급된 동일한 항목을 인식할 수도 있습니다. 응답에서 mentions 목록을 확인해 봅니다. API는 'Joanne Rowling', 'Rowling', 'novelist' 및 'Robert Galbriath'가 모두 같은 사람임을 판단할 수 있습니다.

내 진행 상황 확인하기를 클릭하여 목표를 확인합니다.

작업 4. Natural Language API를 사용한 감정 분석

항목 추출 외에도 Natural Language API를 사용하면 텍스트 블록에서 감정 분석을 수행할 수 있습니다. 이 JSON 요청에는 위 요청과 동일한 매개변수가 포함되지만, 이번에는 텍스트를 변경하여 더 강한 감정이 포함되도록 하겠습니다.

- nano를 사용하여

request.json의 코드를 다음 코드로 대체합니다. 원하는 경우 아래의content를 원하는 텍스트로 대체할 수 있습니다.

-

Ctrl+X 키를 눌러 nano를 종료한 다음 Y 키를 눌러 파일을 저장한 후 Enter 키를 눌러 확인합니다.

-

그런 다음 요청을 API의

analyzeSentiment엔드포인트에 전송합니다.

다음과 같은 응답이 나타납니다.

두 가지 감정 값이 반환되는 것을 알 수 있는데, 하나는 문서 전체의 감정이고 다른 하나는 문장별로 나눠진 감정입니다. 감정 메서드는 다음 두 값을 반환합니다.

-

score- -1.0~1.0 사이의 수치로, 표현이 긍정적이거나 부정적인 정도를 나타냅니다. -

magnitude- 0에서 무한대에 이르는 수치로, 긍정적이거나 부정적인 정도와 상관없이 진술에 표현된 감정의 비중을 나타냅니다.

가중치가 높은 표현이 있는 텍스트 블록의 길이가 길수록 magnitude 값이 커집니다. 첫 번째 문장의 score는 긍정적이지만(0.7), 두 번째 문장의 score는 중립적입니다(0.1).

작업 5. 항목 감정 분석

전체 텍스트 문서의 감정 세부정보를 제공하는 것 외에도, Natural Language API를 사용하면 텍스트의 항목별로도 감정을 분석할 수 있습니다. 다음 문장을 예로 사용해 보겠습니다.

I liked the sushi but the service was terrible.

이 경우, 위에서처럼 전체 문장의 감정 점수를 가져오는 것이 그리 유용하지 않을 수도 있습니다. 이 문장이 식당 리뷰이고 동일한 식당에 대해 수백 개의 리뷰가 있다면, 여러분은 리뷰에서 정확하게 어떤 부분을 사람들이 좋아하고 싫어했는지 알고 싶을 것입니다. 다행히도 Natural Language API에는 텍스트의 각 항목에 대한 감정을 얻을 수 있는 analyzeEntitySentiment라는 메서드가 있습니다. 어떻게 작동하는지 살펴보겠습니다.

- nano를 사용하여

request.json을 다음과 같이 아래 문장으로 업데이트합니다.

-

Ctrl+X 키를 눌러 nano를 종료한 다음 Y 키를 눌러 파일을 저장한 후 Enter 키를 눌러 확인합니다.

-

그런 다음

analyzeEntitySentiment엔드포인트를 다음 curl 명령어로 호출합니다.

응답에서 두 개의 항목 객체, 'sushi'에 대한 객체와 'service'에 대한 객체가 반환됩니다. 전체 JSON 응답은 다음과 같습니다.

'sushi'에는 score 0이 반환되고 'service'에는 score -0.7이 반환된 것을 알 수 있습니다. 아주 잘 분석하죠! 또한 항목별로 반환된 감정 개체가 2개임을 알 수 있습니다. 이러한 용어 중 하나가 두 번 이상 언급된 경우, API는 항목에 대한 집계된 감정과 함께 각 언급에 대해 감정 score와 magnitude를 반환합니다.

작업 6. 구문 및 품사 분석하기

또 다른 Natural Language API의 메서드인 syntactic analysis를 사용하면 텍스트를 언어적으로 자세히 분석할 수 있습니다. analyzeSyntax는 언어 정보를 추출하여 주어진 텍스트를 일련의 문장과 토큰(일반적으로 단어 경계)으로 분류하고 해당 토큰을 심층 분석합니다. API는 텍스트의 각 단어에 대해 단어의 품사(명사, 동사, 형용사 등)와 문장에서 다른 단어와의 관계(어근 동사인지 또는 수식어인지)를 알려줍니다.

간단한 문장으로 시험해 보겠습니다. 다음 JSON 요청은 위의 요청과 비슷하지만 특성 키가 추가되어 있습니다. 따라서 API에 구문 주석 추가를 수행하도록 지시합니다.

- nano를 사용하여

request.json의 코드를 다음과 같이 대체합니다.

-

Ctrl+X 키를 눌러 nano를 종료한 다음 Y 키를 눌러 파일을 저장한 후 Enter 키를 눌러 확인합니다.

-

그런 다음 API의

analyzeSyntax메서드를 다음과 같이 호출합니다.

응답에서 문장의 각 토큰마다 아래와 같은 객체를 반환합니다.

응답을 분석해 보겠습니다.

-

partOfSpeech는 'Joanne'이 명사임을 알려줍니다. -

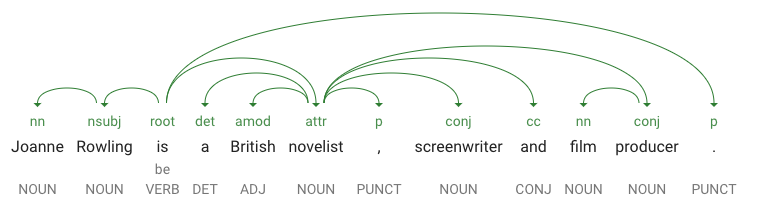

dependencyEdge에는 텍스트의 종속 항목 파싱 트리를 만드는 데 사용할 수 있는 데이터가 있습니다. 기본적으로 이는 문장 내 개별 단어가 서로 어떻게 연관되는지를 보여주는 다이어그램입니다. 위 문장의 종속 항목 파싱 트리는 다음과 같습니다.

-

headTokenIndex는 'Joanne'을 가리키는 토큰의 색인입니다. 문장의 각 토큰을 배열된 단어로 생각해 보세요. - 'Joanne'에 대한

headTokenIndex1은 'Rowling'을 의미하며, 이는 트리에 연결되어 있습니다.NN라벨(명사 복합 수식어)은 문장 내 단어의 역할을 설명합니다. 'Joanne'은 문장의 주어인 'Rowling'을 수식합니다. -

lemma는 단어의 기본형입니다. 예를 들어 run, runs, ran, running의 기본형은 모두 run입니다. lemma 값은 분량이 많은 텍스트에서 단어의 어커런스를 점차적으로 추적하는 데 유용합니다.

작업 7. 다국어 자연어 처리

Natural Language API는 영어 이외의 언어도 지원합니다(언어 지원 가이드에서 전체 목록 확인).

-

request.json의 코드를 일본어 문장으로 수정해 보겠습니다.

- Ctrl+X 키를 눌러 nano를 종료한 다음 Y 키를 눌러 파일을 저장한 후 Enter 키를 눌러 확인합니다.

API에 어떤 언어의 텍스트인지 알려주지 않아도 자동으로 언어를 감지할 수 있음을 알 수 있습니다.

- 다음으로 코드를

analyzeEntities엔드포인트에 보냅니다.

그러면 다음과 같은 응답이 반환됩니다.

Wikipedia URL은 심지어 일본어 Wikipedia 페이지까지 알려줍니다.

수고하셨습니다

지금까지 Cloud Natural Language API를 통해 항목을 추출하고, 감정을 분석하고, 문법 주석을 추가하여 텍스트를 분석하는 방법을 알아보았습니다. 이 실습에서는 Natural Language API 요청을 만들고 curl로 API를 호출했으며, Natural Language API로 항목을 추출하고 텍스트에 대한 감정 분석을 실행했으며, 텍스트에 대한 언어 분석을 수행하고, 다른 언어로 Natural Language API 요청을 만들었습니다.

다음 단계

- 문서에서 Natural Language API 튜토리얼 확인하기

Google Cloud 교육 및 자격증

Google Cloud 기술을 최대한 활용하는 데 도움이 됩니다. Google 강의에는 빠른 습득과 지속적인 학습을 지원하는 기술적인 지식과 권장사항이 포함되어 있습니다. 기초에서 고급까지 수준별 학습을 제공하며 바쁜 일정에 알맞은 주문형, 실시간, 가상 옵션이 포함되어 있습니다. 인증은 Google Cloud 기술에 대한 역량과 전문성을 검증하고 입증하는 데 도움이 됩니다.

설명서 최종 업데이트: 2024년 2월 14일

실습 최종 테스트: 2023년 10월 13일

Copyright 2024 Google LLC All rights reserved. Google 및 Google 로고는 Google LLC의 상표입니다. 기타 모든 회사명 및 제품명은 해당 업체의 상표일 수 있습니다.