Checkpoints

Create the connection resource

/ 20

Set up access to a Cloud Storage data lake

/ 30

Create the BigLake table

/ 20

Create the external table

/ 10

Update external table to Biglake table

/ 20

BigLake: Qwik Start

- GSP1040

- Visão geral

- Objetivos

- Configuração e requisitos

- Tarefa 1: criar um recurso de conexão

- Tarefa 2: configurar o acesso a um data lake do Cloud Storage

- Tarefa 3: criar uma tabela do BigLake

- Tarefa 4: consultar uma tabela do BigLake por meio do BigQuery

- Tarefa 5: configurar políticas de controle de acesso

- Tarefa 6: fazer upgrade de tabelas externas para tabelas do BigLake

- Parabéns!

GSP1040

Visão geral

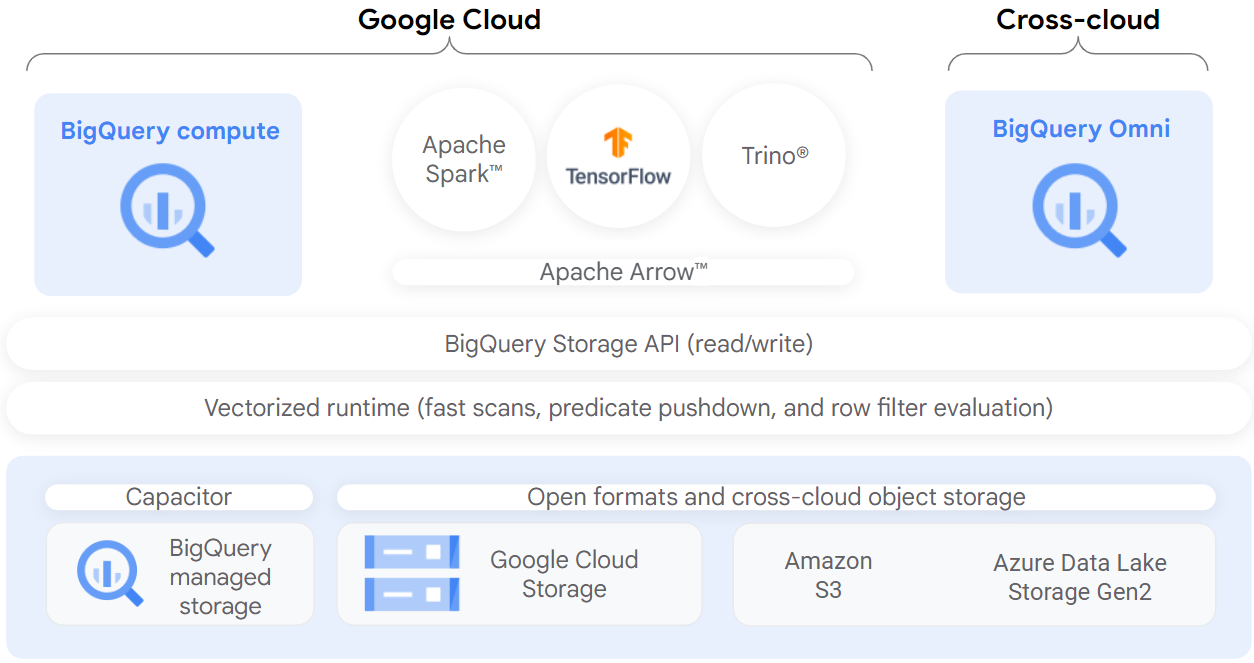

O BigLake é um mecanismo de armazenamento unificado que simplifica o acesso aos dados para data warehouses e data lakes fornecendo controle de acesso uniforme e detalhado em armazenamento multicloud e formatos abertos.

O BigLake estende a segurança detalhada no nível da linha e da coluna do BigQuery para tabelas em repositórios de objetos residentes em dados, como o Amazon S3, o Azure Data Lake Storage Gen2 e o Google Cloud Storage. O BigLake desacopla o acesso à tabela dos dados de armazenamento em nuvem subjacentes por meio da delegação de acesso. Esse recurso ajuda você a conceder acesso no nível da linha e da coluna com segurança aos usuários e pipelines da sua organização sem precisar fornecer acesso total à tabela.

Após criar uma tabela do BigLake, você pode consultá-la como faz com outras tabelas do BigQuery. O BigQuery aplica controles de acesso no nível da linha e da coluna, e cada usuário vê apenas a fração dos dados que está autorizado a ver. As políticas de governança são aplicadas a todo o acesso aos dados por meio das APIs do BigQuery. Por exemplo, a API BigQuery Storage permite que os usuários acessem dados autorizados usando mecanismos de consulta de código aberto, como o Apache Spark, como mostra o diagrama a seguir:

Objetivos

Neste laboratório, você vai aprender a:

- Criar e visualizar um recurso de conexão

- Configurar o acesso a um data lake do Cloud Storage

- Criar uma tabela do BigLake

- Consultar uma tabela do BigLake pelo BigQuery

- Configurar políticas de controle de acesso

- Fazer upgrade de tabelas externas para tabelas do BigLake

Configuração e requisitos

Antes de clicar no botão Start Lab

Leia estas instruções. Os laboratórios são cronometrados e não podem ser pausados. O timer é iniciado quando você clica em Começar o laboratório e mostra por quanto tempo os recursos do Google Cloud vão ficar disponíveis.

Este laboratório prático permite que você realize as atividades em um ambiente real de nuvem, não em uma simulação ou demonstração. Você vai receber novas credenciais temporárias para fazer login e acessar o Google Cloud durante o laboratório.

Confira os requisitos para concluir o laboratório:

- Acesso a um navegador de Internet padrão (recomendamos o Chrome).

- Tempo para concluir o laboratório---não se esqueça: depois de começar, não será possível pausar o laboratório.

Como iniciar seu laboratório e fazer login no console do Google Cloud

-

Clique no botão Começar o laboratório. Se for preciso pagar, você verá um pop-up para selecionar a forma de pagamento. No painel Detalhes do laboratório à esquerda, você vai encontrar o seguinte:

- O botão Abrir console do Google Cloud

- O tempo restante

- As credenciais temporárias que você vai usar neste laboratório

- Outras informações, se forem necessárias

-

Se você estiver usando o navegador Chrome, clique em Abrir console do Google Cloud ou clique com o botão direito do mouse e selecione Abrir link em uma janela anônima.

O laboratório ativa os recursos e depois abre a página Fazer login em outra guia.

Dica: coloque as guias em janelas separadas lado a lado.

Observação: se aparecer a caixa de diálogo Escolher uma conta, clique em Usar outra conta. -

Se necessário, copie o Nome de usuário abaixo e cole na caixa de diálogo Fazer login.

{{{user_0.username | "Nome de usuário"}}} Você também encontra o Nome de usuário no painel Detalhes do laboratório.

-

Clique em Seguinte.

-

Copie a Senha abaixo e cole na caixa de diálogo de boas-vindas.

{{{user_0.password | "Senha"}}} Você também encontra a Senha no painel Detalhes do laboratório.

-

Clique em Seguinte.

Importante: você precisa usar as credenciais fornecidas no laboratório, e não as da sua conta do Google Cloud. Observação: se você usar sua própria conta do Google Cloud neste laboratório, é possível que receba cobranças adicionais. -

Acesse as próximas páginas:

- Aceite os Termos e Condições.

- Não adicione opções de recuperação nem autenticação de dois fatores (porque essa é uma conta temporária).

- Não se inscreva em testes gratuitos.

Depois de alguns instantes, o console do Google Cloud será aberto nesta guia.

Ativar o Cloud Shell

O Cloud Shell é uma máquina virtual com várias ferramentas de desenvolvimento. Ele tem um diretório principal permanente de 5 GB e é executado no Google Cloud. O Cloud Shell oferece acesso de linha de comando aos recursos do Google Cloud.

- Clique em Ativar o Cloud Shell

na parte de cima do console do Google Cloud.

Depois de se conectar, vai notar que sua conta já está autenticada, e que o projeto está configurado com seu PROJECT_ID. A saída contém uma linha que declara o projeto PROJECT_ID para esta sessão:

gcloud é a ferramenta de linha de comando do Google Cloud. Ela vem pré-instalada no Cloud Shell e aceita preenchimento com tabulação.

- (Opcional) É possível listar o nome da conta ativa usando este comando:

-

Clique em Autorizar.

-

A saída será parecida com esta:

Saída:

- (Opcional) É possível listar o ID do projeto usando este comando:

Saída:

Exemplo de saída:

gcloud, acesse o guia com informações gerais sobre a gcloud CLI no Google Cloud.

Tarefa 1: criar um recurso de conexão

As tabelas do BigLake acessam dados do Google Cloud Storage usando um recurso de conexão. Um recurso de conexão pode ser associado a uma única tabela ou a um grupo arbitrário de tabelas no projeto.

-

No menu de navegação, acesse BigQuery > BigQuery Studio. Clique em Concluído.

-

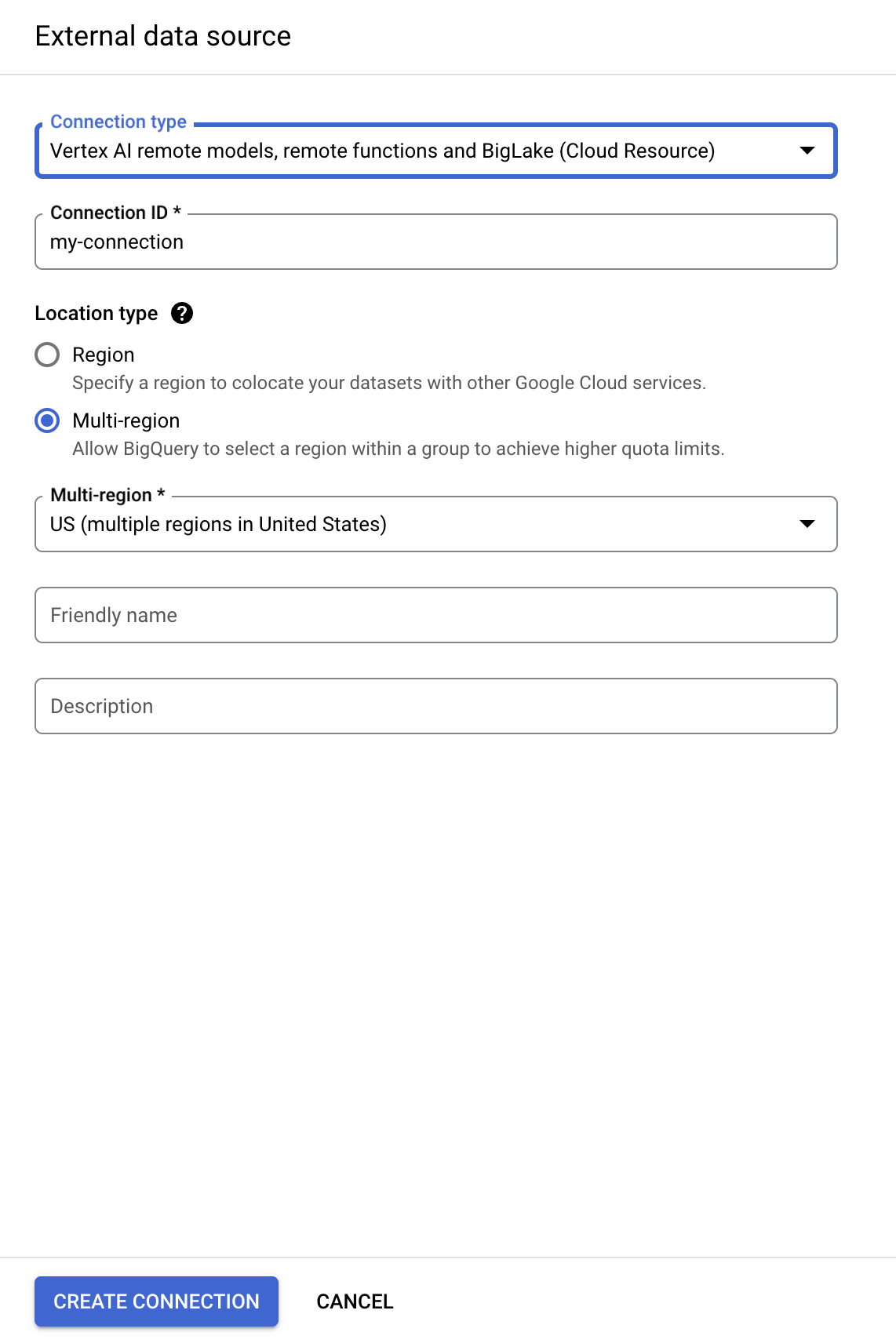

Para criar uma conexão, clique em +ADICIONAR e selecione Conexões com fontes de dados externas.

- Na lista Tipo de conexão, selecione Modelos remotos, funções remotas e BigLake (recurso do Cloud) da Vertex AI.

-

No campo ID da conexão, digite

my-connection. -

Em Tipo de localização, escolha Multirregião e selecione EUA (várias regiões nos Estados Unidos) no menu suspenso.

-

Clique em Criar conexão.

-

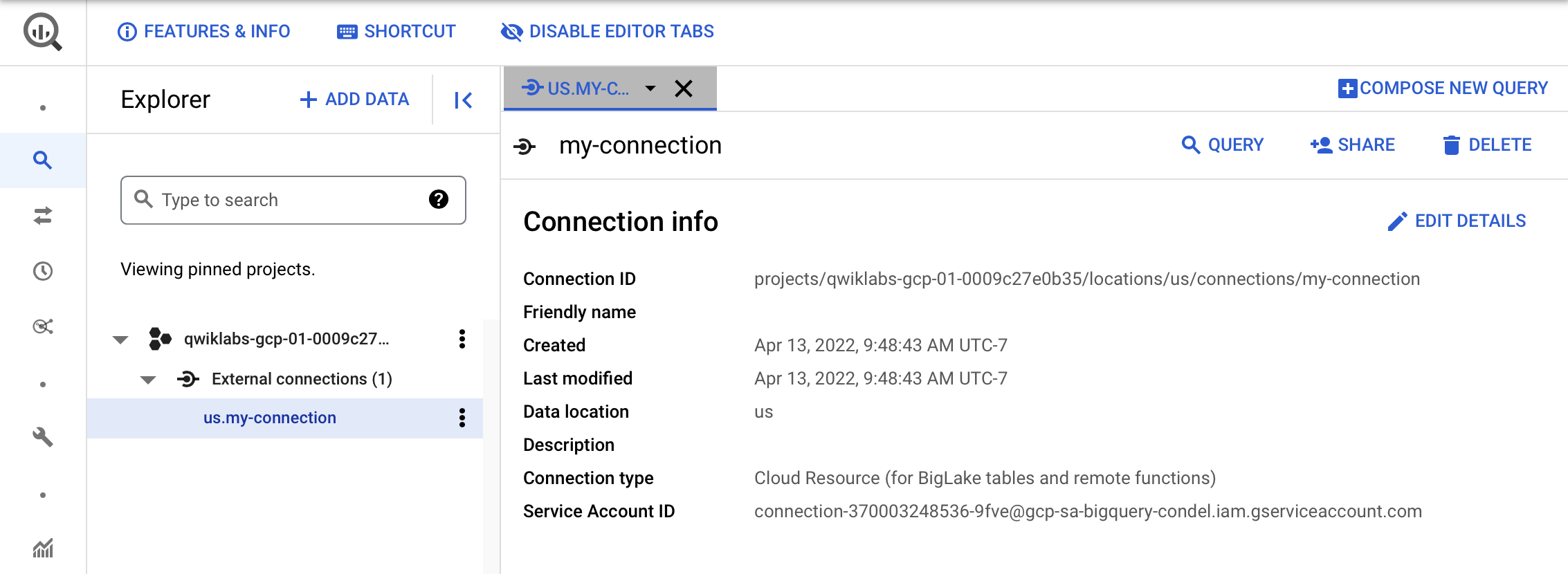

Para ver suas informações de conexão, selecione a conexão no menu de navegação.

- Na seção Informações da conexão, copie o ID da conta de serviço. Você vai precisar dele na próxima seção.

Clique em Verificar meu progresso para conferir o objetivo.

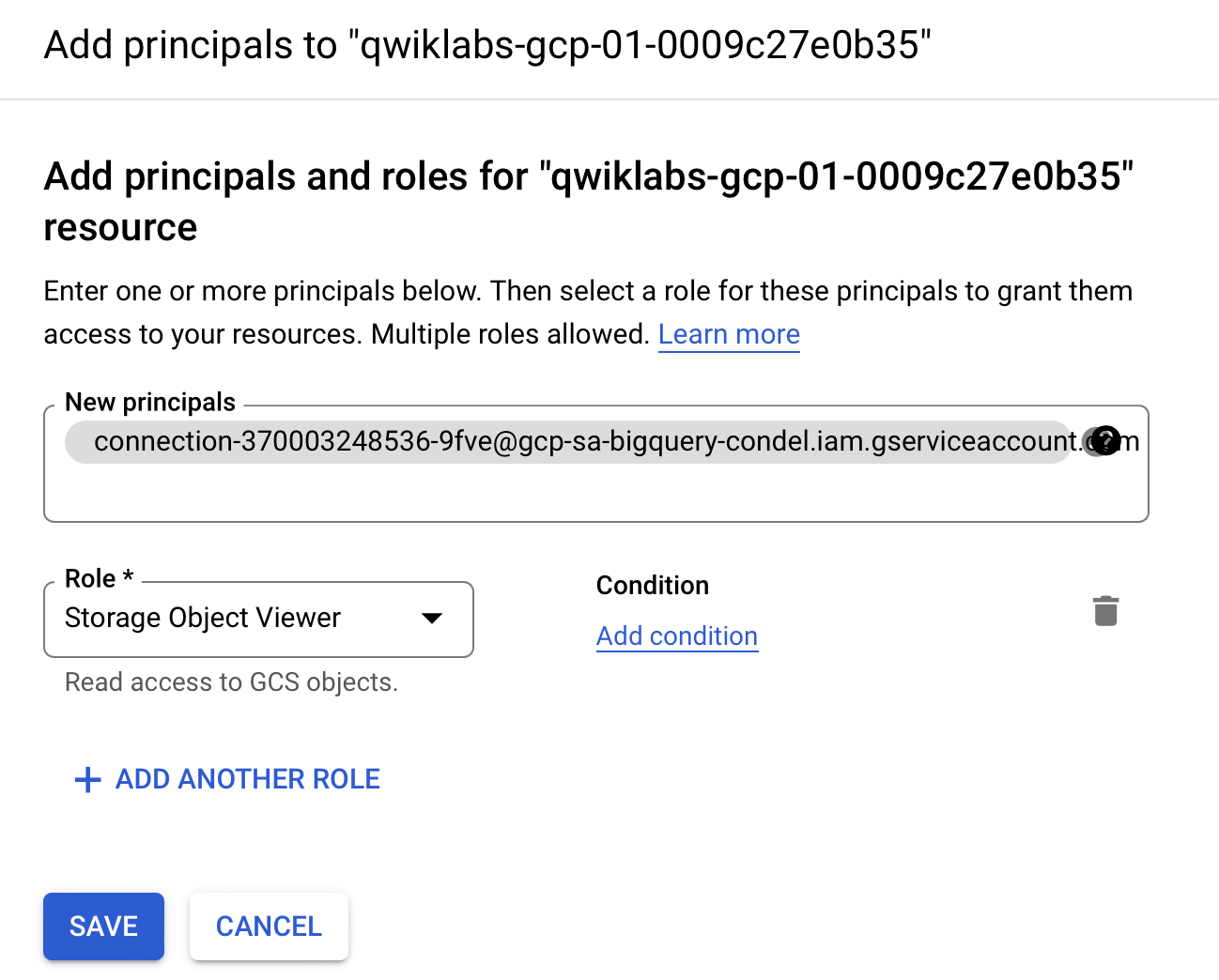

Tarefa 2: configurar o acesso a um data lake do Cloud Storage

Nesta seção, você vai conceder ao novo recurso de conexão acesso somente leitura ao data lake do Cloud Storage para que o BigQuery possa acessar arquivos do Cloud Storage em nome dos usuários. Recomendamos que você conceda à conta de serviço de recurso de conexão o papel do IAM de Leitor de objetos do Storage, que permite que a conta de serviço acesse buckets do Cloud Storage.

-

No Menu de navegação, acesse IAM e administrador > IAM.

-

Clique em +PERMITIR ACESSO.

-

No campo Novos principais, digite o ID da conta de serviço que você copiou.

-

No campo Selecionar papel, escolha Cloud Storage e, em seguida, Visualizador de objetos do Storage.

- Clique em Salvar.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 3: criar uma tabela do BigLake

O exemplo a seguir usa o formato do arquivo CSV, mas é possível usar qualquer formato compatível com o BigLake, conforme mostrado em Limitações. Se você sabe criar tabelas no BigQuery, vai achar esse processo semelhante. A única diferença é que você especifica a conexão de recurso do Cloud associado.

Se nenhum esquema tiver sido fornecido e a conta de serviço não tiver recebido acesso ao bucket na etapa anterior, esta etapa vai falhar com uma mensagem de acesso negado.

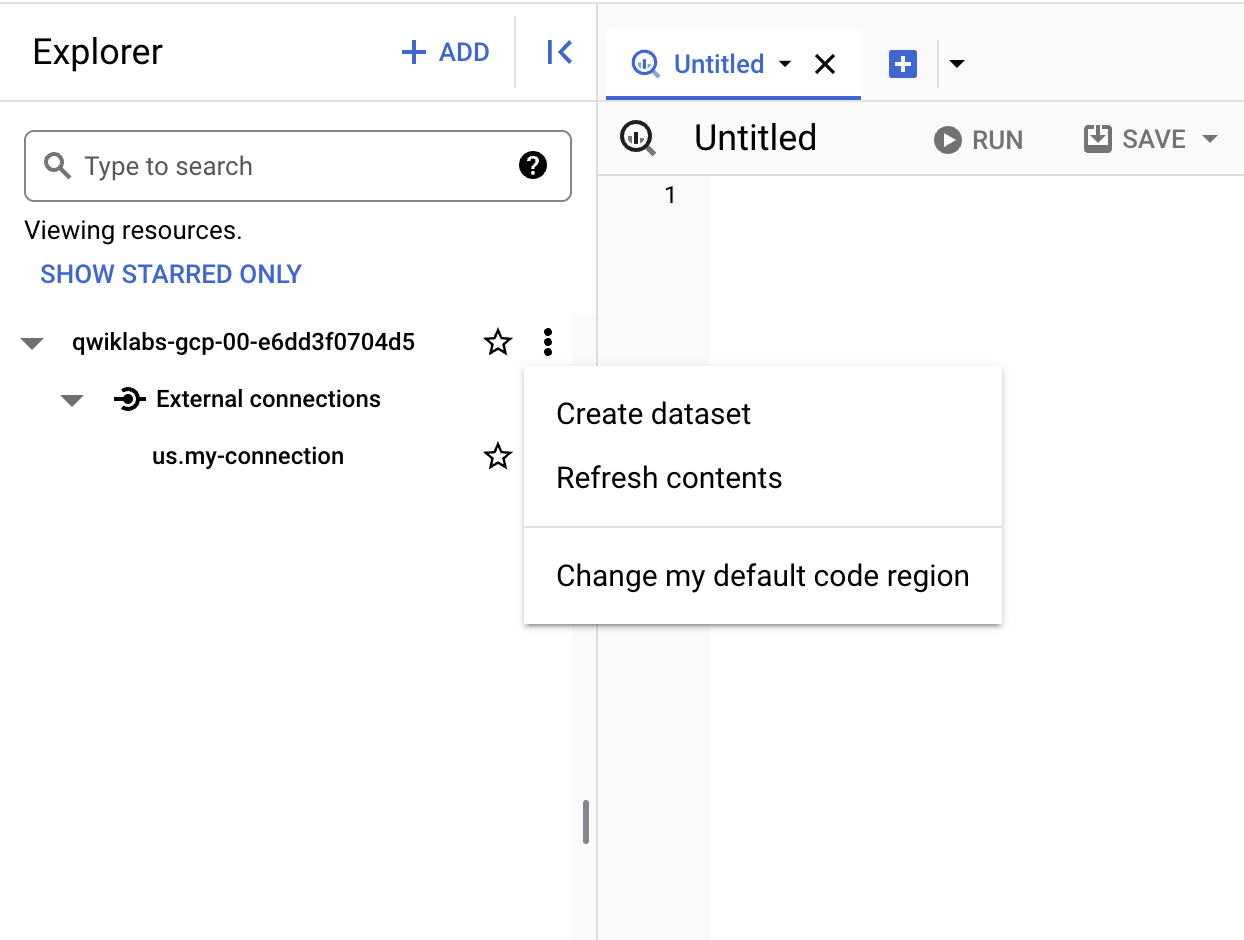

Criar um conjunto de dados

-

Volte ao BigQuery > BigQuery Studio.

-

Clique nos três pontos ao lado do nome do projeto e selecione Criar conjunto de dados.

-

Em ID do conjunto de dados, use

demo_dataset. -

Em Tipo de localização, escolha Multirregião e selecione EUA (várias regiões nos Estados Unidos) no menu suspenso.

-

Deixe os demais campos como padrão e clique em Criar conjunto de dados.

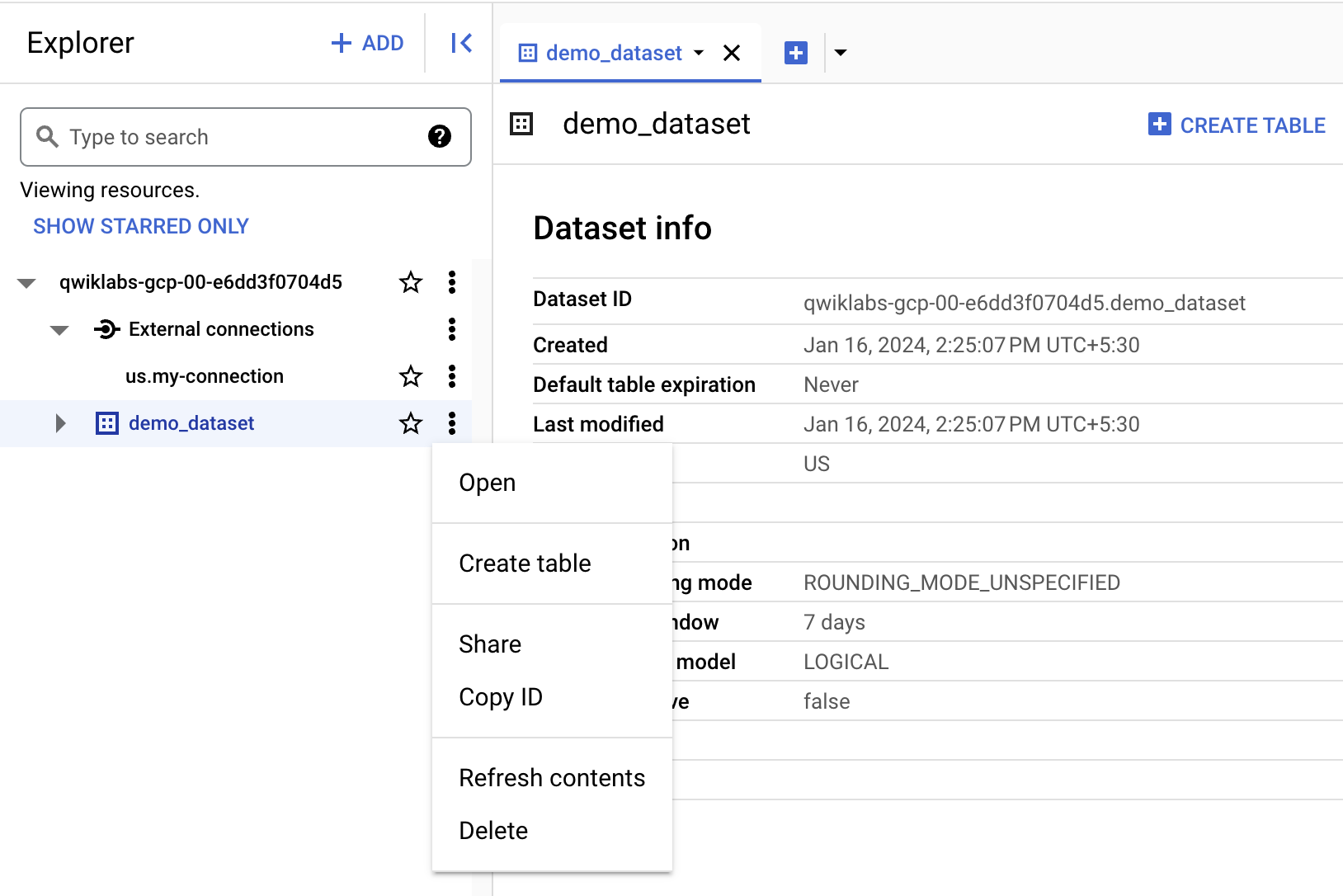

Agora que um conjunto de dados foi criado, você pode copiar um existente do Cloud Storage para o BigQuery.

Criar a tabela

- Clique nos três pontos ao lado do demo_dataset e escolha Criar tabela.

- Em Criar tabela de, abaixo de "Origem", escolha Google Cloud Storage.

-

Clique em Procurar para selecionar o conjunto de dados. Navegue até o bucket chamado

e, em seguida, até o arquivo customer.csvpara importá-lo para o BigQuery e clique em Selecionar. -

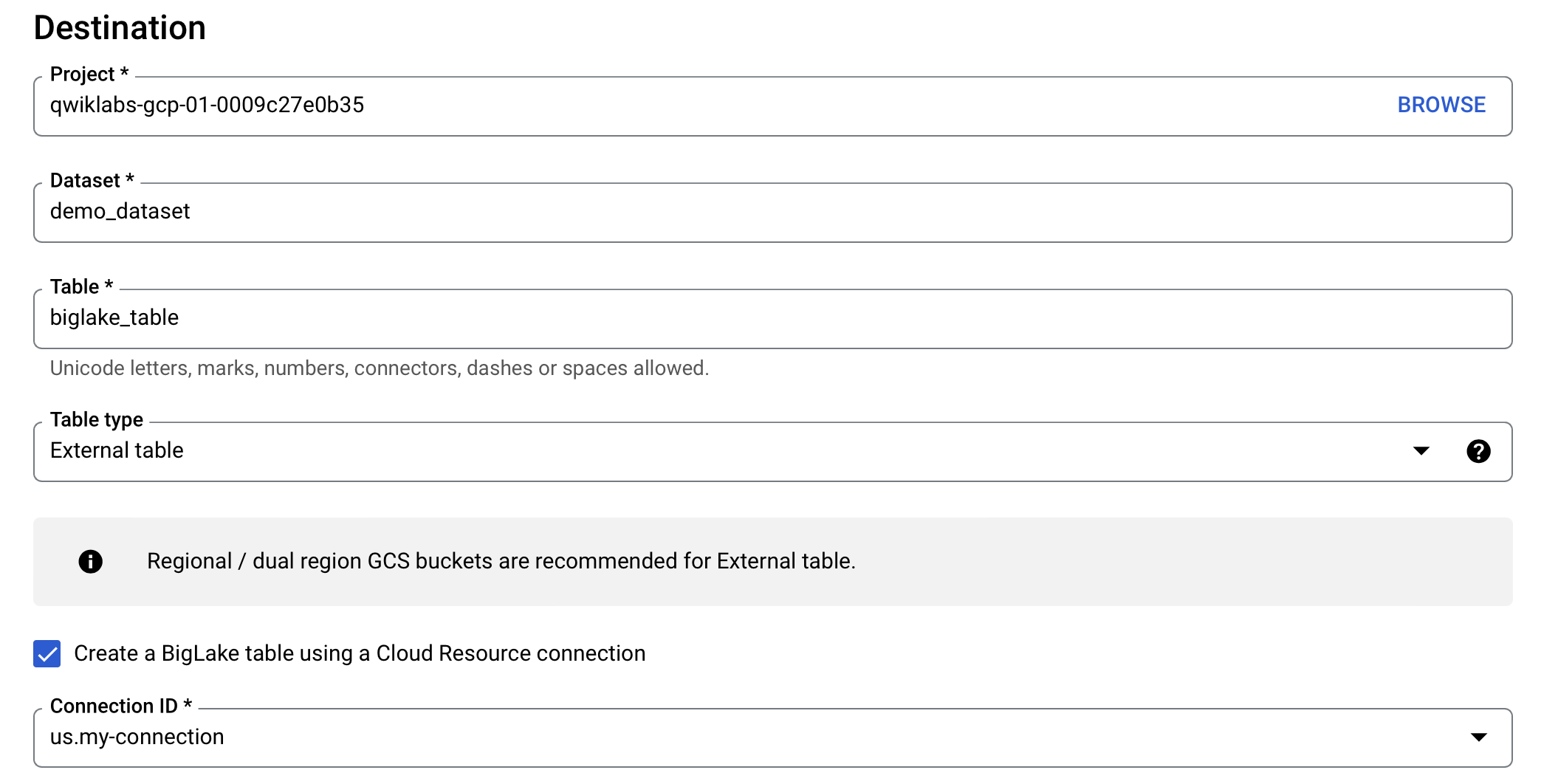

Em Destino, verifique se seu projeto do laboratório foi selecionado e se você está usando o demo_dataset.

-

Para o nome da tabela, use

biglake_table. -

Defina o tipo de tabela como Tabela externa.

-

Marque a caixa Criar uma tabela do BigLake usando uma conexão do Cloud Resource.

Verifique se o ID da conexão us.my-connection está selecionado. Sua configuração será parecida com o seguinte:

- Em Esquema, ative a opção Editar como texto e copie e cole o esquema a seguir na caixa de texto:

- Clique em Criar tabela.

Clique em Verificar meu progresso para conferir o objetivo.

Tarefa 4: consultar uma tabela do BigLake por meio do BigQuery

Agora que você criou a tabela do BigLake, pode usar qualquer cliente do BigQuery para enviar uma consulta.

-

Na barra de ferramentas de visualização biglake_table, clique em Consulta > Em uma nova guia.

-

Execute o seguinte para consultar a tabela do BigLake por meio do Editor do BigQuery:

-

Clique em Executar.

-

Verifique se você consegue ver todas as colunas e dados na tabela resultante.

Tarefa 5: configurar políticas de controle de acesso

Após ser criada, uma tabela do BigLake pode ser gerenciada de maneira semelhante às tabelas do BigQuery. Para criar políticas de controle de acesso para tabelas do BigLake, primeiro crie uma taxonomia de tags de política no BigQuery. Em seguida, aplique as tags de política às linhas ou colunas confidenciais. Nesta seção, você vai criar uma política no nível da coluna. Para instruções sobre como configurar a segurança no nível da linha, consulte o guia de segurança no nível da linha.

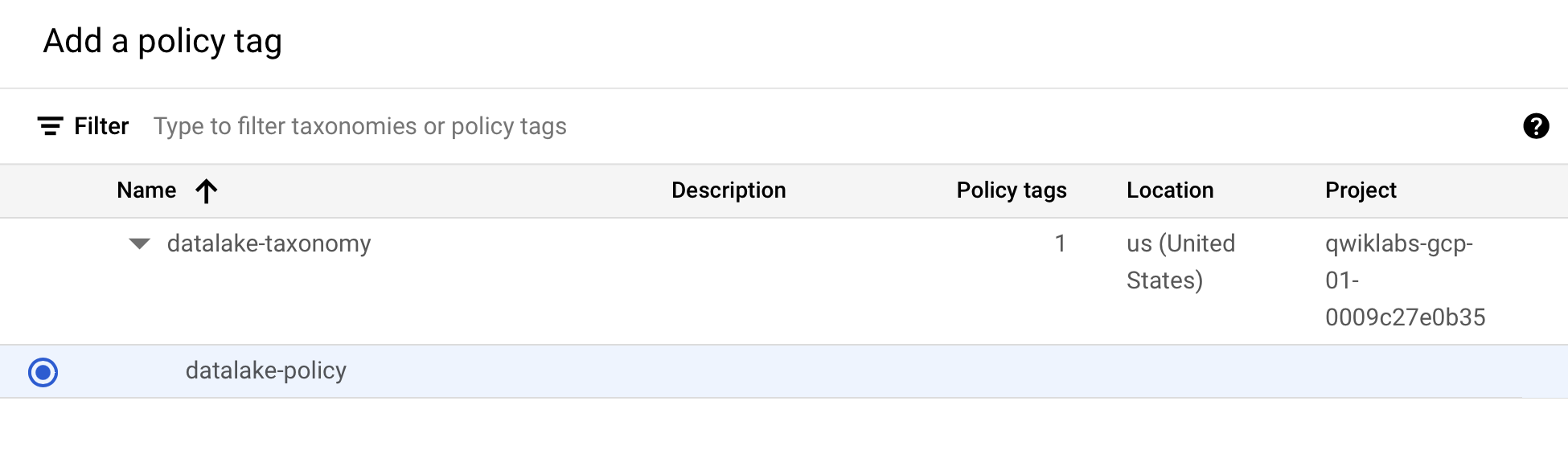

Para esses fins, uma taxonomia do BigQuery chamada

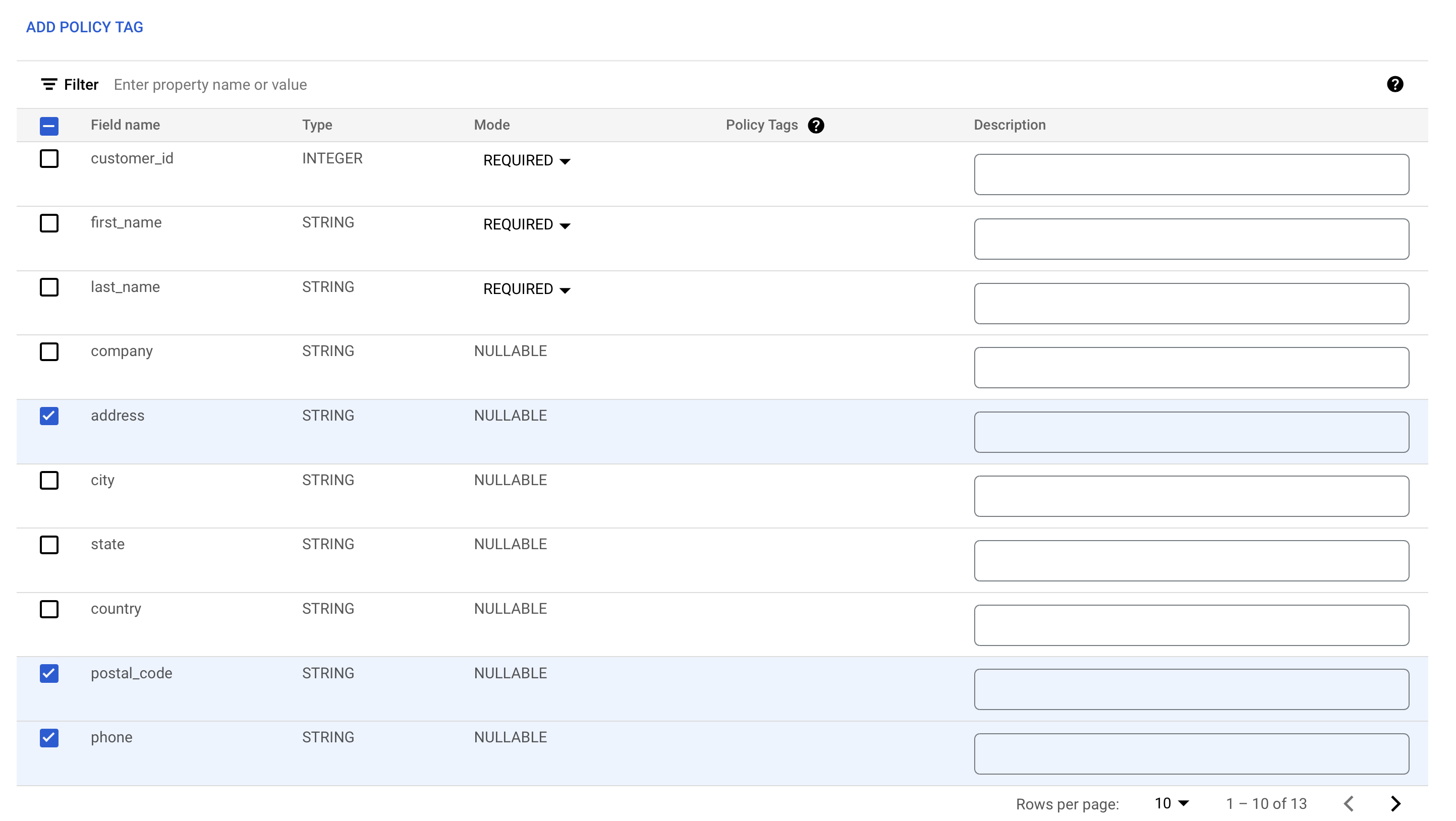

Adicionar tags de política às colunas

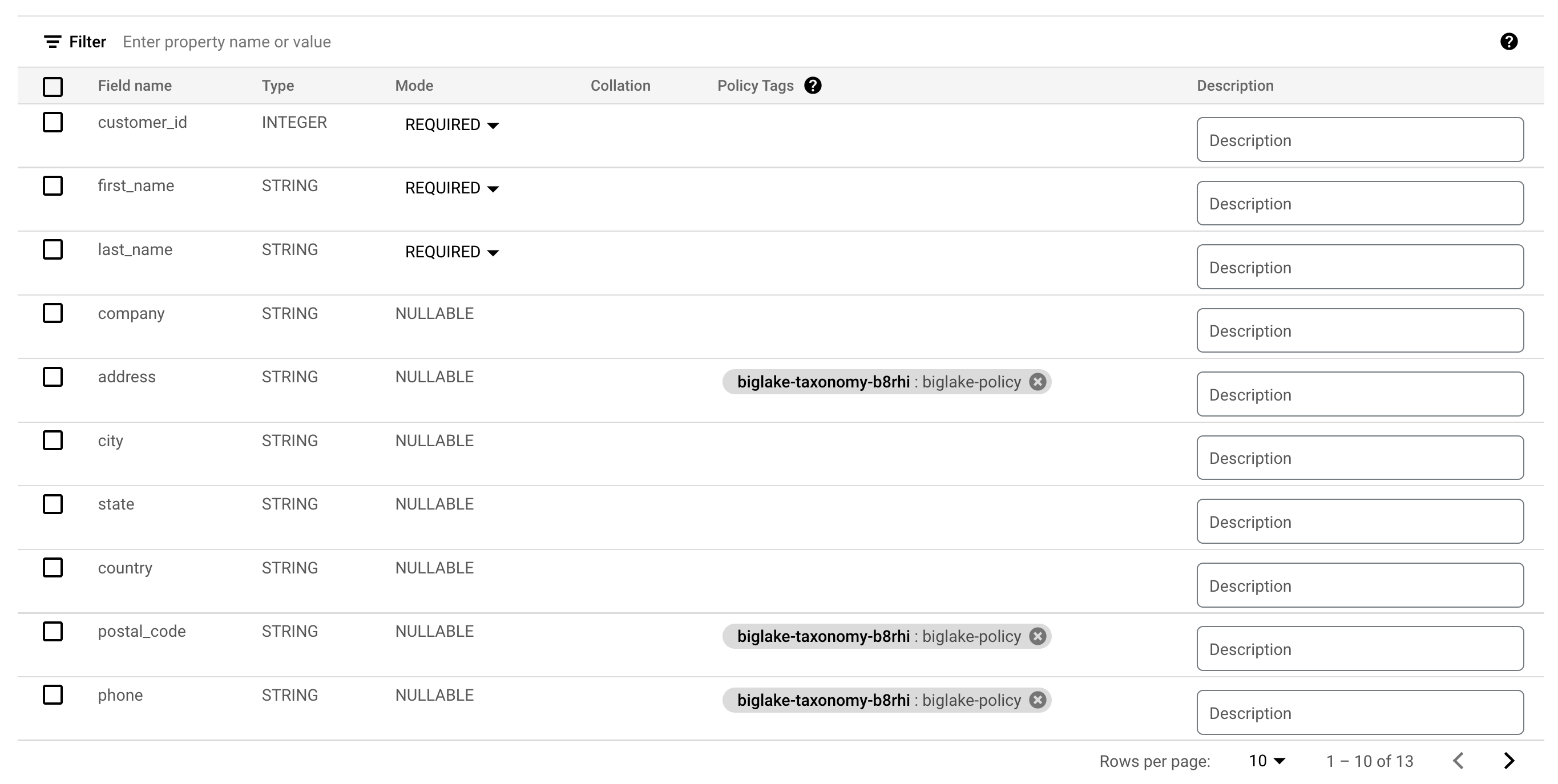

Agora você vai usar a tag de política criada para restringir o acesso a determinadas colunas na tabela do BigQuery. Para este exemplo, você vai restringir o acesso a informações sensíveis, como endereço, código postal e número de telefone.

-

No menu de navegação, acesse BigQuery > BigQuery Studio.

-

Navegue até demo-dataset > biglake_table e clique na tabela para abrir a página do esquema dela.

-

Clique em Editar esquema.

-

Marque as caixas ao lado dos campos endereço, postal_code e telefone.

-

Clique em Adicionar tag de política.

-

Clique em

para expandir e selecionar biglake-policy.

-

Clique em Selecionar.

Suas colunas agora devem ter as tags de política anexadas a elas.

-

Clique em Salvar.

-

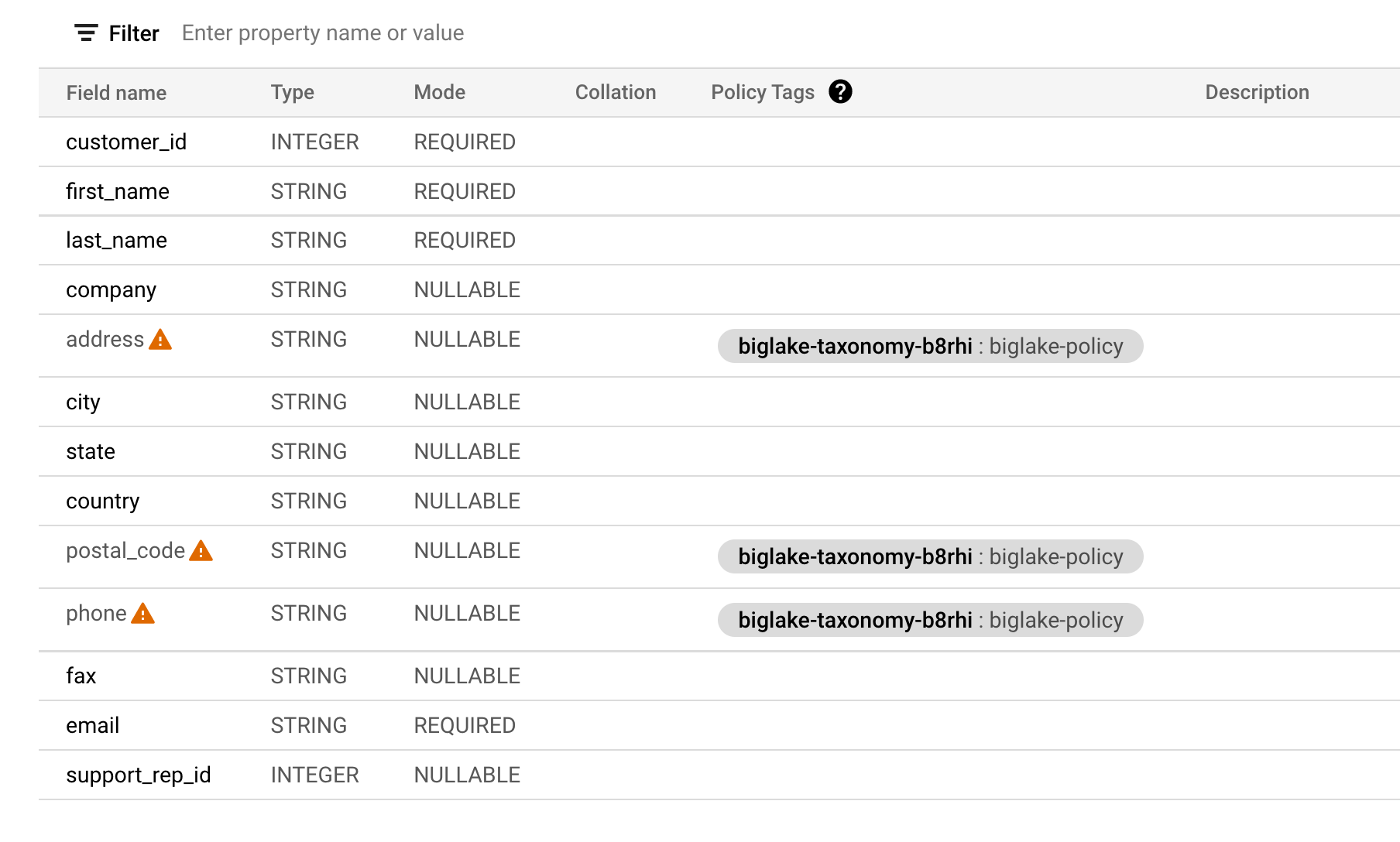

Verifique se o esquema de tabela agora se parece com o seguinte.

Verifique a segurança no nível da coluna

-

Abra o editor de consultas do biglake_table.

-

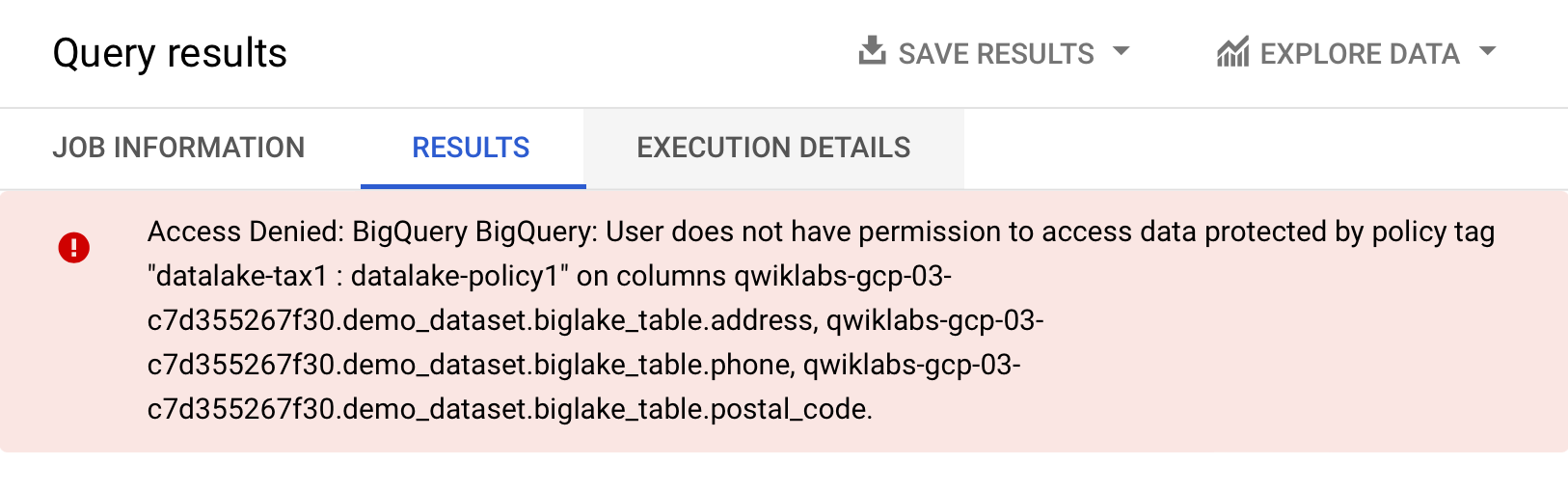

Execute o seguinte para consultar a tabela do BigLake por meio do Editor do BigQuery:

-

Clique em Executar.

Você vai receber uma mensagem de erro de acesso negado:

- Execute agora a seguinte consulta, omitindo as colunas às quais você não tem acesso:

A consulta deve ser executada sem problemas e retornar as colunas disponíveis para seu acesso. Esse exemplo mostra que a segurança no nível da coluna executada pelo BigQuery também pode ser aplicada às tabelas do BigLake.

Tarefa 6: fazer upgrade de tabelas externas para tabelas do BigLake

É possível fazer upgrade das tabelas atuais para tabelas do BigLake associando-as a uma conexão de recurso do Cloud. Consulte bq update e bq mkdef para ter acesso a uma lista completa de flags e argumentos.

Criar a tabela externa

-

Clique nos três pontos ao lado do demo_dataset e escolha Criar tabela.

-

Em Criar tabela de, abaixo de "Origem", escolha Google Cloud Storage.

-

Clique em Procurar para selecionar o conjunto de dados. Navegue até o bucket chamado

e, em seguida, até o arquivo invoice.csvpara importá-lo para o BigQuery e clique em Selecionar. -

Em Destino, verifique se seu projeto do laboratório foi selecionado e se você está usando o demo_dataset.

-

Para o nome da tabela, use

external_table. -

Defina o tipo de tabela como Tabela externa.

- Em Esquema, ative a opção Editar como texto e copie e cole o esquema a seguir na caixa de texto:

- Clique em Criar tabela.

Clique em Verificar meu progresso para conferir o objetivo.

Atualizar a tabela externa para tabela do Biglake

- Abra uma nova janela do Cloud Shell e execute o seguinte comando para gerar uma nova definição de tabela externa que especifica a conexão a ser usada:

- Verifique se a definição de tabela foi criada:

- Receba o esquema de sua tabela:

- Atualize a tabela usando a nova definição de tabela externa:

Clique em Verificar meu progresso para conferir o objetivo.

Verificar a tabela atualizada

-

No menu de navegação, acesse BigQuery > BigQuery Studio.

-

Navegue até demo-dataset > e clique duas vezes em external_table.

-

Abra a guia Detalhes.

-

Verifique, em Configuração de dados externos, se a tabela está usando o ID de conexão adequado.

Ótimo! Você atualizou com sucesso a tabela externa existente para uma tabela do BigLake associando-a a uma conexão de recurso do Cloud.

Parabéns!

Neste laboratório, você criou um recurso de conexão, configurou o acesso a um data lake do Cloud Storage e criou uma tabela do BigLake a partir dele. Em seguida, você consultou a tabela do BigLake por meio do BigQuery e configurou políticas de controle de acesso no nível da coluna. Por fim, você atualizou uma tabela externa existente para uma tabela do BigLake usando o recurso de conexão.

Próximas etapas / Saiba mais

Confira a documentação a seguir para praticar mais com o BigLake:

- Introdução às tabelas do BigLake

- Criar e gerenciar a documentação das tabelas do BigLake

- Consultar uma tabela do BigLake usando conectores

Treinamento e certificação do Google Cloud

Esses treinamentos ajudam você a aproveitar as tecnologias do Google Cloud ao máximo. Nossas aulas incluem habilidades técnicas e práticas recomendadas para ajudar você a alcançar rapidamente o nível esperado e continuar sua jornada de aprendizado. Oferecemos treinamentos que vão do nível básico ao avançado, com opções de aulas virtuais, sob demanda e por meio de transmissões ao vivo para que você possa encaixá-las na correria do seu dia a dia. As certificações validam sua experiência e comprovam suas habilidades com as tecnologias do Google Cloud.

Manual atualizado em 16 de janeiro de 2024

Laboratório testado em 16 de janeiro de 2024

Copyright 2024 Google LLC. Todos os direitos reservados. Google e o logotipo do Google são marcas registradas da Google LLC. Todos os outros nomes de produtos e empresas podem ser marcas registradas das respectivas empresas a que estão associados.