Punkty kontrolne

Create a lake, zone, and asset

/ 20

Query BigQuery table to review data quality

/ 20

Create and upload a data quality specification file

/ 20

Define and run a data quality job

/ 20

Review data quality results in BigQuery

/ 20

Ocenianie jakości danych przy użyciu Dataplex

- GSP1158

- Opis

- Konfiguracja i wymagania

- Zadanie 1. Tworzenie jeziora danych, strefy i zasobu w Dataplex

- Zadanie 2. Wykonywanie zapytania na tabeli BigQuery w celu sprawdzenia jakości danych

- Zadanie 3. Tworzenie i przesyłanie pliku specyfikacji jakości danych

- Zadanie 4. Definiowanie i uruchamianie zadania dotyczącego jakości danych w Dataplex

- Zadanie 5. Przeglądanie wyników kontroli jakości danych w BigQuery

- Gratulacje!

GSP1158

Opis

Dataplex to inteligentna tkanina danych, która umożliwia organizacjom centralne wykrywanie i monitorowanie danych w jeziorach, hurtowniach i składnicach danych oraz zarządzanie nimi na potrzeby analiz przeprowadzanych na dużą skalę.

Cenną funkcją Dataplex jest możliwość definiowania i przeprowadzania kontroli jakości danych w zasobach Dataplex, takich jak tabele BigQuery i pliki w Cloud Storage. Za pomocą zadań dotyczących jakości danych w Dataplex możesz włączyć kontrole jakości danych w codzienne przepływy pracy przez sprawdzanie poprawności danych wchodzących w skład potoku produkcyjnego, regularne monitorowanie jakości danych pod kątem określonego zestawu kryteriów i tworzenie raportów dotyczących jakości danych na potrzeby spełnienia wymogów prawnych.

W tym module dowiesz się, jak ocenić jakość danych za pomocą Dataplex. Utworzysz własny plik specyfikacji jakości danych i wykorzystasz go, aby zdefiniować i uruchomić zadanie dotyczące jakości na danych BigQuery.

Jakie zadania wykonasz

- Utworzysz jezioro danych, strefę i zasób Dataplex.

- Wykonasz zapytanie na tabeli BigQuery, aby sprawdzić jakość danych.

- Utworzysz i prześlesz plik specyfikacji jakości danych.

- Zdefiniujesz i uruchomisz zadanie dotyczące jakości danych.

- Przejrzysz wyniki zadania dotyczącego jakości danych.

Konfiguracja i wymagania

Zanim klikniesz przycisk Rozpocznij moduł

Zapoznaj się z tymi instrukcjami. Moduły mają limit czasowy i nie można ich zatrzymać. Gdy klikniesz Rozpocznij moduł, na liczniku wyświetli się informacja o tym, na jak długo udostępniamy Ci zasoby Google Cloud.

W tym praktycznym module możesz spróbować swoich sił w wykonywaniu opisywanych działań w prawdziwym środowisku chmury, a nie w jego symulacji lub wersji demonstracyjnej. Otrzymasz nowe, tymczasowe dane logowania, dzięki którym zalogujesz się i uzyskasz dostęp do Google Cloud na czas trwania modułu.

Do ukończenia modułu potrzebne będą:

- dostęp do standardowej przeglądarki internetowej (zalecamy korzystanie z przeglądarki Chrome).

- Odpowiednia ilość czasu na ukończenie modułu – pamiętaj, że gdy rozpoczniesz, nie możesz go wstrzymać.

Rozpoczynanie modułu i logowanie się w konsoli Google Cloud

-

Kliknij przycisk Rozpocznij moduł. Jeśli moduł jest odpłatny, otworzy się wyskakujące okienko, w którym możesz wybrać formę płatności. Po lewej stronie znajduje się panel Szczegóły modułu z następującymi elementami:

- przyciskiem Otwórz konsolę Google Cloud;

- czasem, który Ci pozostał;

- tymczasowymi danymi logowania, których musisz użyć w tym module;

- innymi informacjami potrzebnymi do ukończenia modułu.

-

Kliknij Otwórz konsolę Google Cloud (lub kliknij prawym przyciskiem myszy i wybierz Otwórz link w oknie incognito, jeśli korzystasz z przeglądarki Chrome).

Moduł uruchomi zasoby, po czym otworzy nową kartę ze stroną logowania.

Wskazówka: otwórz karty obok siebie w osobnych oknach.

Uwaga: jeśli pojawi się okno Wybierz konto, kliknij Użyj innego konta. -

W razie potrzeby skopiuj nazwę użytkownika znajdującą się poniżej i wklej ją w oknie logowania.

{{{user_0.username | "Username"}}} Nazwę użytkownika znajdziesz też w panelu Szczegóły modułu.

-

Kliknij Dalej.

-

Skopiuj podane niżej hasło i wklej je w oknie powitania.

{{{user_0.password | "Password"}}} Hasło znajdziesz też w panelu Szczegóły modułu.

-

Kliknij Dalej.

Ważne: musisz użyć danych logowania podanych w module. Nie używaj danych logowania na swoje konto Google Cloud. Uwaga: korzystanie z własnego konta Google Cloud w tym module może wiązać się z dodatkowymi opłatami. -

Na kolejnych stronach wykonaj następujące czynności:

- Zaakceptuj Warunki korzystania z usługi.

- Nie dodawaj opcji odzyskiwania ani uwierzytelniania dwuskładnikowego (ponieważ konto ma charakter tymczasowy).

- Nie rejestruj się w bezpłatnych wersjach próbnych.

Poczekaj, aż na karcie otworzy się konsola Google Cloud.

Aktywowanie Cloud Shell

Cloud Shell to maszyna wirtualna oferująca wiele narzędzi dla programistów. Zawiera stały katalog domowy o pojemności 5 GB i działa w Google Cloud. Dzięki wierszowi poleceń Cloud Shell zyskujesz dostęp do swoich zasobów Google Cloud.

- Kliknij Aktywuj Cloud Shell

na górze konsoli Google Cloud.

Po połączeniu użytkownik od razu jest uwierzytelniony. Uruchomi się Twój projekt o identyfikatorze PROJECT_ID. Dane wyjściowe zawierają wiersz z zadeklarowanym identyfikatorem PROJECT_ID dla tej sesji:

gcloud to narzędzie wiersza poleceń Google Cloud. Jest ono już zainstalowane w Cloud Shell i obsługuje funkcję autouzupełniania po naciśnięciu tabulatora.

- (Opcjonalnie) Aby wyświetlić listę aktywnych kont, użyj tego polecenia:

-

Kliknij Autoryzuj.

-

Dane wyjściowe powinny wyglądać tak:

Dane wyjściowe:

- (Opcjonalnie) Aby wyświetlić identyfikator projektu, użyj tego polecenia:

Dane wyjściowe:

Przykładowe dane wyjściowe:

gcloud w Google Cloud znajdziesz w opisie narzędzia wiersza poleceń gcloud.

Włączanie Dataproc API

-

Na pasku wyszukiwania u góry konsoli Google Cloud wpisz Cloud Dataproc API.

-

Kliknij wynik z interfejsem Cloud Dataproc API w sekcji Marketplace.

-

Kliknij Włącz.

Zadanie 1. Tworzenie jeziora danych, strefy i zasobu w Dataplex

Aby zdefiniować i uruchomić zadania dotyczące jakości danych, musisz najpierw utworzyć pewne zasoby Dataplex.

W tym zadaniu utworzysz nowe jezioro danych Dataplex na informacje o klientach sklepu internetowego, dodasz do jeziora strefę nieprzetworzoną, a potem dołączysz do strefy gotowy zbiór danych BigQuery jako nowy zasób.

Tworzenie jeziora

- W Menu nawigacyjnym (

) konsoli Google Cloud kliknij Analityka > Dataplex.

Jeśli pojawi się okno Welcome to the new Dataplex experience (Witamy w nowej usłudze Dataplex), kliknij Zamknij.

-

W sekcji Zarządzanie jeziorami kliknij Zarządzaj.

-

Kliknij Utwórz jezioro danych.

-

Wpisz informacje potrzebne do utworzenia nowego jeziora:

| Właściwość | Wartość |

|---|---|

| Wyświetlana nazwa | Ecommerce Lake |

| Identyfikator | Pozostaw wartość domyślną. |

| Region |

W pozostałych opcjach pozostaw wartości domyślne.

- Kliknij Utwórz.

Utworzenie jeziora może zająć do 3 minut.

Dodawanie strefy do jeziora

-

Na karcie Zarządzanie kliknij nazwę jeziora.

-

Kliknij Dodaj strefę.

-

Wpisz informacje potrzebne do utworzenia nowej strefy:

| Właściwość | Wartość |

|---|---|

| Wyświetlana nazwa | Customer Contact Raw Zone |

| Identyfikator | Pozostaw wartość domyślną. |

| Typ | Strefa nieprzetworzona |

| Lokalizacje danych | Region |

W pozostałych opcjach pozostaw wartości domyślne.

Przykładowo: opcja Włącz wykrywanie metadanych w sekcji Ustawienia wykrywania jest domyślnie włączona i pozwala uprawnionym użytkownikom wykrywać dane w strefie.

- Kliknij Utwórz.

Utworzenie strefy może zająć do 2 minut.

Dołączanie zasobu do strefy

-

Kliknij nazwę strefy na karcie Strefy.

-

Na karcie Zasoby kliknij Dodaj zasoby.

-

Kliknij Dodaj zasób.

-

Wpisz informacje potrzebne do dołączenia nowego zasobu:

| Właściwość | Wartość |

|---|---|

| Typ | Zbiór danych BigQuery |

| Wyświetlana nazwa | Contact Info |

| Identyfikator | Pozostaw wartość domyślną. |

| Zbiór danych |

|

W pozostałych opcjach pozostaw wartości domyślne.

-

Kliknij Gotowe.

-

Kliknij Dalej.

-

W Ustawieniach wykrywania wybierz Odziedzicz, aby odziedziczyć ustawienia wykrywania z poziomu strefy. Następnie kliknij Dalej.

-

Kliknij Prześlij.

Kliknij Sprawdź postępy, aby zobaczyć, jak Ci poszło.

Zadanie 2. Wykonywanie zapytania na tabeli BigQuery w celu sprawdzenia jakości danych

W poprzednim zadaniu utworzyliśmy nowy zasób Dataplex ze zbioru danych BigQuery o nazwie customers, który został utworzony wcześniej na potrzeby tego modułu. Zbiór danych zawiera tabelę contact_info, w której znajdują się nieprzetworzone dane kontaktowe klientów fikcyjnego sklepu internetowego.

W tym zadaniu wykonasz zapytanie na tej tabeli, aby zacząć wyszukiwać potencjalne problemy z jakością danych, które można będzie włączyć jako poszczególne kontrole w zadanie dotyczące jakości danych. Wskażesz też inny utworzony wcześniej zbiór danych, w którym będzie można zapisać wyniki zadania dotyczącego jakości danych w jednym z późniejszych kroków.

-

W Menu nawigacyjnym (

) konsoli Google Cloud otwórz BigQuery > Obszar roboczy SQL.

-

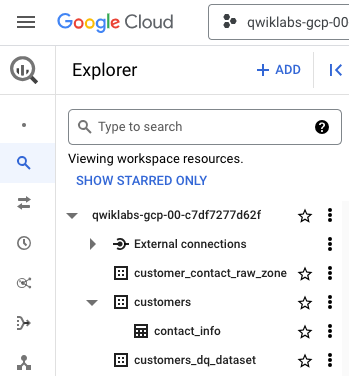

W panelu Eksplorator rozwiń strzałkę przy identyfikatorze projektu, aby wyświetlić zawartość:

Oprócz zbioru danych customer_contact_raw_zone utworzonego przez Dataplex do zarządzania tą strefą są tam 2 zbiory danych BigQuery, które zostały utworzone wcześniej na potrzeby tego modułu:

- customers

- customers_dq_dataset

Zbiór danych customers zawiera jedną tabelę o nazwie contact_info, w której znajdują się dane kontaktowe klientów, takie jak identyfikator klienta, jego imię i nazwisko, adres e-mail itp. To tabela, którą w tym module przeanalizujesz i sprawdzisz pod kątem problemów z jakością danych.

Zbiór danych customers_dq_dataset nie zawiera żadnych tabel. W późniejszym kroku, przy definiowaniu zadania dotyczącego jakości danych, wykorzystasz ten zbiór danych jako lokalizację docelową dla nowej tabeli z wynikami zadania dotyczącego jakości danych.

- W edytorze SQL kliknij Utwórz nowe zapytanie. Wklej to zapytanie, a potem kliknij Uruchom:

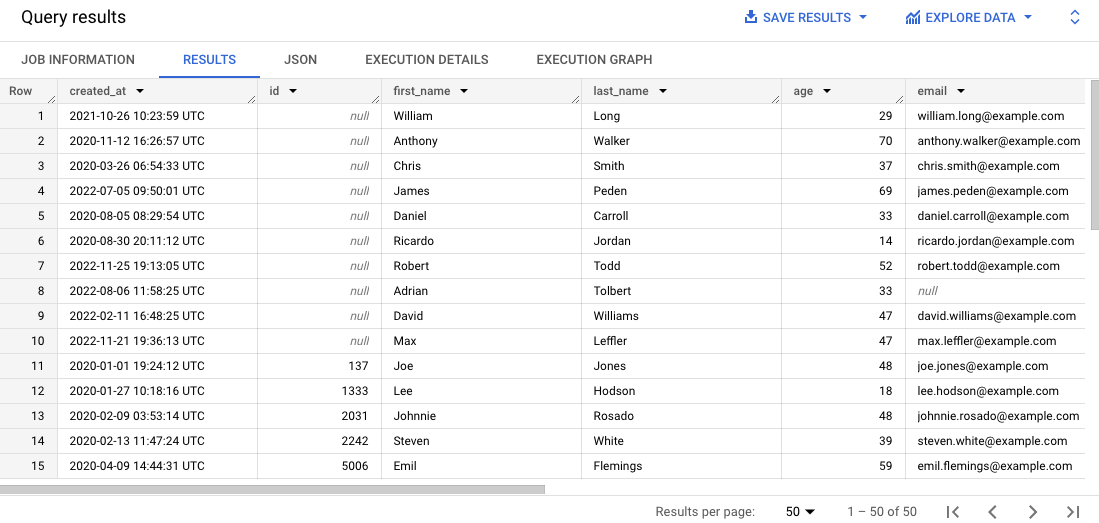

To zapytanie wybiera 50 rekordów z oryginalnej tabeli i porządkuje je w wynikach według identyfikatora klienta.

- Przewiń wyniki w panelu Wyniki.

Zauważ, że w niektórych rekordach nie ma identyfikatora klienta lub adres e-mail jest niepoprawny, co może utrudnić zarządzanie zamówieniami klientów.

Kliknij Sprawdź postępy, aby zobaczyć, jak Ci poszło.

Zadanie 3. Tworzenie i przesyłanie pliku specyfikacji jakości danych

Wymagania dotyczące kontroli jakości danych w Dataplex określa się za pomocą plików specyfikacji YAML CloudDQ. Utworzony plik specyfikacji YAML jest przesyłany do zasobnika Cloud Storage, który jest udostępniany zadaniu dotyczącemu jakości danych.

Plik YAML ma 4 kluczowe sekcje:

- lista reguł do uruchomienia (mogą to być reguły wstępnie zdefiniowane lub dostosowane);

- filtry wierszy pozwalające wybrać podzbiór danych do sprawdzenia poprawności;

- powiązania reguł, które umożliwiają zastosowanie zdefiniowanych reguł w tabelach;

- opcjonalne wymiary reguł, dzięki którym można określić typy reguł dopuszczalne w pliku YAML.

W tym zadaniu zdefiniujesz nowy plik specyfikacji YAML na potrzeby różnych kontroli jakości danych, które wskażą brakujące identyfikatory klienta i adresy e-mail w danej tabeli BigQuery. Po zdefiniowaniu pliku prześlesz go do utworzonego wcześniej zasobnika Cloud Storage, co pozwoli wykorzystać go później przy uruchamianiu zadania dotyczącego jakości danych.

Tworzenie pliku specyfikacji jakości danych

- Aby utworzyć nowy pusty plik na specyfikację jakości danych, uruchom w Cloud Shell to polecenie:

- Wklej ten kod:

- Przejrzyj kod, aby znaleźć 2 główne reguły dotyczące jakości danych zdefiniowane w tym pliku.

Plik dq-customer-raw-data.yaml rozpoczyna się od najważniejszych parametrów określających zasoby Dataplex, takich jak identyfikator projektu, region oraz nazwy jeziora danych i strefy Dataplex.

Potem wskazuje dozwolone wymiary reguł i 2 główne reguły:

- Reguła dotycząca wartości NOT_NULL odnosi się do wymiaru kompletności, np. wartości null.

- Reguła dotycząca wartości VALID_EMAIL odnosi się do wymiaru zgodności, np. wartości nieprawidłowych.

Reguły są powiązane z encjami (tabelami) i kolumnami za pomocą powiązań reguł do walidacji jakości danych:

- Powiązanie pierwszej reguły nazwano VALID_CUSTOMER. Łączy ono regułę NOT_NULL z kolumną id w tabeli contact_info, co pozwoli sprawdzić, czy kolumna z identyfikatorami zawiera jakiekolwiek wartości null.

- Drugie powiązanie reguły nazwano VALID_EMAIL_ID. Łączy ono regułę VALID_EMAIL z kolumną email w tabeli contact_info, co pozwoli sprawdzić adresy e-mail pod kątem poprawności.

- Naciśnij

Ctrl + X, a potem wpiszY, aby zapisać i zamknąć plik.

Przesyłanie pliku do Cloud Storage

- Uruchom w Cloud Shell to polecenie, aby przesłać plik do zasobnika Cloud Storage utworzonego na potrzeby tego modułu:

Kliknij Sprawdź postępy, aby zobaczyć, jak Ci poszło.

Zadanie 4. Definiowanie i uruchamianie zadania dotyczącego jakości danych w Dataplex

Proces kontroli jakości danych wykorzystuje plik specyfikacji YAML, aby wykonać zadanie dotyczące jakości danych. Na tej podstawie generuje wskaźniki jakości danych zapisywane do zbioru danych BigQuery.

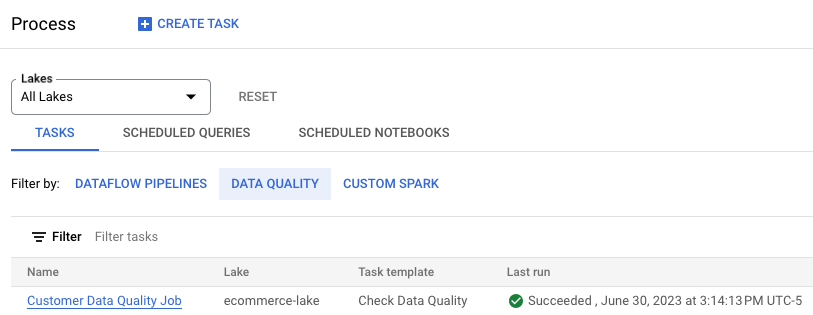

W tym zadaniu zdefiniujesz i uruchomisz zadanie dotyczące jakości danych za pomocą pliku specyfikacji YAML przesłanego do Cloud Storage w poprzednim kroku. Przy definiowaniu zadania wskażesz również utworzony wcześniej zbiór danych BigQuery customer_dq_dataset jako miejsce do przechowywania wyników kontroli jakości danych.

-

W Menu nawigacyjnym (

) konsoli Google Cloud kliknij Analityka > Dataplex.

-

W sekcji Zarządzanie jeziorami kliknij Przetwarzanie.

-

Kliknij Utwórz zadanie.

-

W sekcji Sprawdzanie jakości danych kliknij Utwórz zadanie.

-

Wpisz informacje potrzebne do utworzenia nowego zadania dotyczącego jakości danych:

| Właściwość | Wartość |

|---|---|

| Jezioro danych Dataplex | ecommerce-lake |

| Wyświetlana nazwa | Customer Data Quality Job |

| Identyfikator | Pozostaw wartość domyślną. |

| Wybierz plik GCS |

|

| Wybierz zbiór danych BigQuery |

|

| Tabela BigQuery | dq_results |

| Konto usługi użytkownika | Domyślne konto usługi Compute Engine |

W pozostałych opcjach pozostaw wartości domyślne.

Uwaga: domyślne konto usługi Compute Engine zostało wcześniej skonfigurowane na potrzeby tego modułu tak, aby miało odpowiednie role i uprawnienia. Więcej informacji znajdziesz w dokumentacji Dataplex dotyczącej tworzenia konta usługi.

-

Kliknij Dalej.

-

W polu Uruchom wybierz Natychmiast.

-

Kliknij Utwórz.

Kliknij Sprawdź postępy, aby zobaczyć, jak Ci poszło.

Zadanie 5. Przeglądanie wyników kontroli jakości danych w BigQuery

W tym zadaniu przejrzysz tabele w zbiorze danych customers_dq_dataset, aby znaleźć rekordy, w których brakuje wartości identyfikatora klienta lub znajduje się niepoprawny adres e-mail.

-

W Menu nawigacyjnym (

) konsoli Google Cloud otwórz BigQuery > Obszar roboczy SQL.

-

W panelu Eksplorator rozwiń strzałkę przy identyfikatorze projektu, aby wyświetlić zawartość:

-

Rozwiń strzałkę przy zbiorze danych customer_dq_dataset.

-

Kliknij tabelę dq_summary.

-

Kliknij kartę Podgląd, aby wyświetlić wyniki.

Tabela dq summary zawiera przydatne informacje na temat ogólnej jakości danych, w tym liczbę rekordów, które nie są zgodne z 2 regułami zawartymi w pliku specyfikacji jakości danych.

-

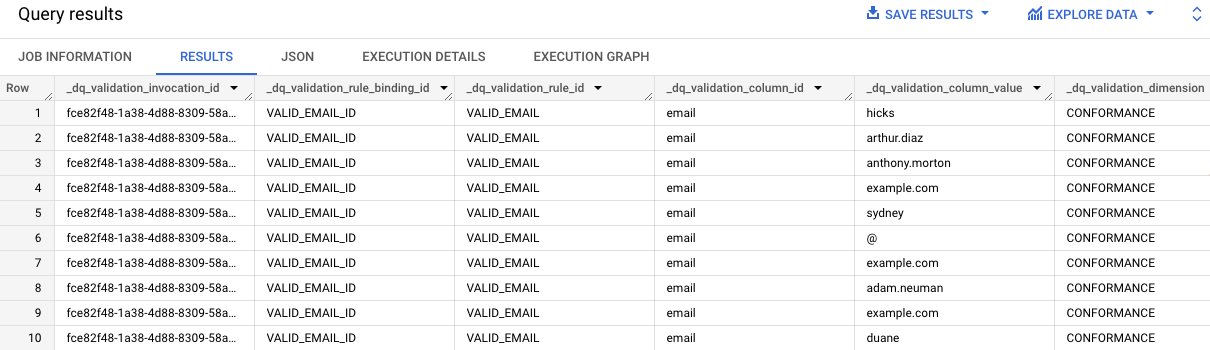

Przewiń do ostatniej kolumny o nazwie failed_records_query.

-

Kliknij strzałkę w dół w pierwszym wierszu, aby rozwinąć tekst i wyświetlić całe zapytanie dla wyników reguły VALID_EMAIL.

Zwróć uwagę na to, że zapytanie jest dość długie i kończy się instrukcją ORDER BY _dq_validation_rule_id.

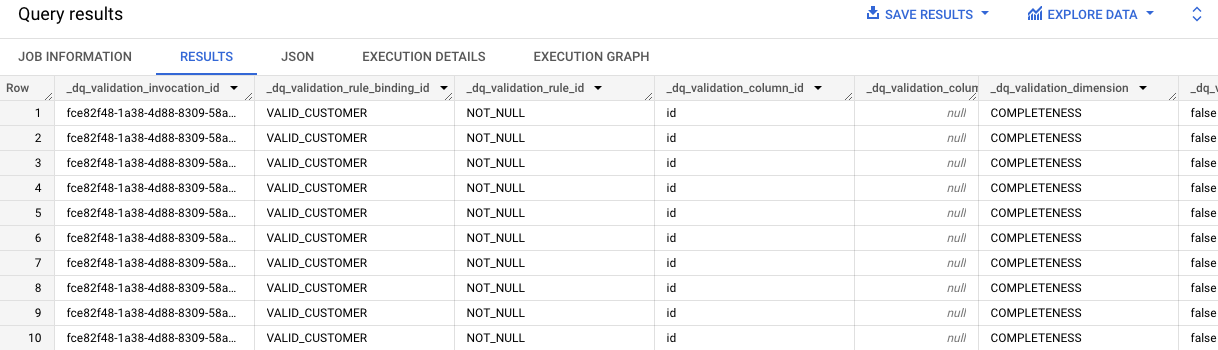

- Kliknij Utwórz nowe zapytanie. Skopiuj i wklej zapytanie do edytora SQL, a następnie kliknij Uruchom.

Wyniki zapytania zawierają nieprawidłowe wartości adresów e-mail w tabeli contact_info.

- Powtórz kroki 7–8 dla drugiej komórki, która zawiera zapytanie dotyczące wyników reguły VALID_CUSTOMER.

Wyniki zapytania wskazują, że w tabeli contact_info jest 10 rekordów, w których brakuje wartości.

Kliknij Sprawdź postępy, aby zobaczyć, jak Ci poszło.

Gratulacje!

Udało Ci się ocenić jakość danych przy użyciu Dataplex przez utworzenie własnego pliku specyfikacji jakości danych i wykorzystanie go do wykonania zadania dotyczącego jakości danych na tabeli BigQuery.

Szkolenia i certyfikaty Google Cloud

…pomogą Ci wykorzystać wszystkie możliwości technologii Google Cloud. Nasze zajęcia obejmują umiejętności techniczne oraz sprawdzone metody, które ułatwią Ci szybką naukę i umożliwią jej kontynuację. Oferujemy szkolenia na poziomach od podstawowego po zaawansowany prowadzone w trybach wirtualnym, na żądanie i na żywo, dzięki czemu możesz dopasować program szkoleń do swojego napiętego harmonogramu. Certyfikaty umożliwią udokumentowanie i potwierdzenie Twoich umiejętności oraz doświadczenia w zakresie technologii Google Cloud.

Ostatnia aktualizacja instrukcji: 4 lipca 2023 r.

Ostatni test modułu: 4 lipca 2023 r.

Copyright 2025 Google LLC. Wszelkie prawa zastrzeżone. Google i logo Google są znakami towarowymi Google LLC. Wszelkie inne nazwy firm i produktów mogą być znakami towarowymi odpowiednich podmiotów, z którymi są powiązane.